(R) Machines de pensée continue: la dynamique neuronale comme représentation.

|

Essayez notre démo interactive de résolution de labyrinthe: https://pub.sakana.ai/ctm/ Machines de pensée continue

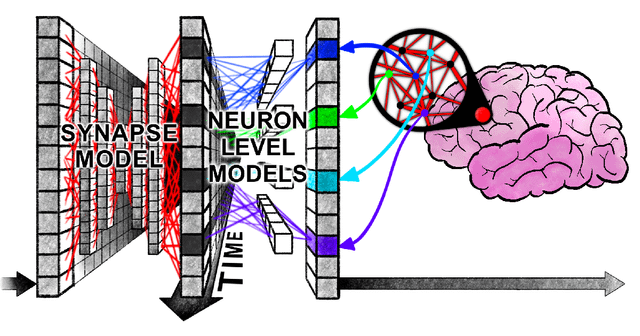

Nous sommes ravis de partager nos nouvelles recherches sur Machines de pensée continues (CTMS)une nouvelle approche visant à combler l’écart entre l’efficacité informatique et la plausibilité biologique dans l’intelligence artificielle. Nous partageons ce travail ouvertement avec la communauté et nous adorons entendre vos pensées et vos commentaires! Que sont les machines à pensée continue? La plupart des architectures d’apprentissage en profondeur simplifient l’activité neuronale en abstraction de la dynamique temporelle. Dans notre article, nous remettant ce paradigme en réintroduisant le timing neural en tant qu’élément fondamental. La machine à pensée continue (CTM) est un modèle conçu pour tirer parti de la dynamique neuronale comme représentation de base. Innovations de base: Le CTM a deux principales innovations:

Pourquoi est-ce excitant? Nos recherches démontrent que cette approche permet au CTM de:

Notre objectif: Il est crucial de noter que notre approche préconise des concepts d’emprunt à la biologie plutôt que d’insister sur une plausibilité stricte et littérale. Nous nous sommes inspirés d’un aspect critique de l’intelligence biologique: que La pensée prend du temps. L’objectif de ce travail est de partager le CTM et ses innovations associées, plutôt que de pousser uniquement à de nouveaux résultats de pointe. Nous pensons que le CTM représente une étape importante vers le développement de systèmes d’intelligence artificielle plus plausibles et puissants plus biologiquement. Nous nous engageons à poursuivre les travaux sur le CTM, compte tenu des avenues potentielles des travaux futurs que nous pensons que cela permet. Nous vous encourageons à consulter le journal, Démos interactifs sur notre page de projetet l’ouverture open référentiel de code. Nous sommes impatients de voir ce que la communauté construit avec elle et de discuter du potentiel de la dynamique neuronale dans l’IA! soumis par / u / Gramious |