Nouveau modèle mathématique open source Light-R1-32B dépasse l’équivalesse Deepiseek se produisant avec une formation avec seulement 1000 $ en frais de formation

Rejoignez nos newsletters quotidiennes et hebdomadaires pour les dernières mises à jour et des contennes exclusives sur le coverage de l’IA à la tête de l’industrie. Apprendre encore plus

Les chercheurs Havent Introduction Light-R1-32B, Nouveaux problèmes de mod Oodized MOD du modèle Open source. Il est maintenant disponible sur Visage étreint Selon la licence Apache 2.0 perméable – gratuite pour les entreprises à la recherche à prendre, à déploier, à affiner ou à l’événement, même à des fins commerciales.

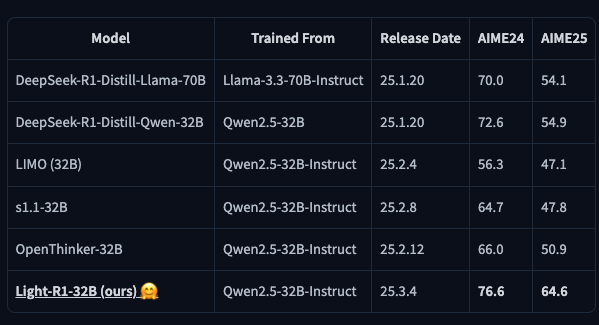

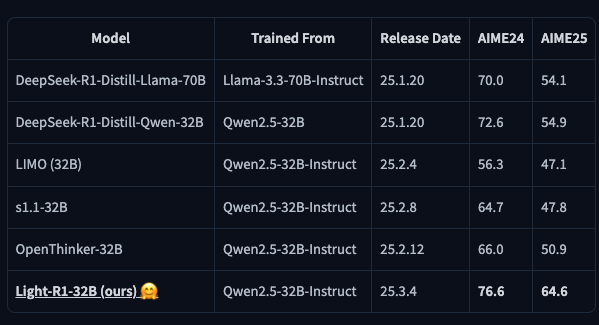

Le modèle de paramètre de 32 milliards (nombre de paramètres du modèle) dépasse la taille de performance-7-aille-sttill-32-parti-party-party American Invitational Mathematics Examination (AIME) Benchmark qui contient 15 problèmes de mathématiques concevant pour les étudiants avancés Exvergelly et a une limite de temps allouée de 3 heures.

Développé par Liang Wen, Fenrui Xiao, Xin He, Yunke Dan, Yimiawem Den, Junchemng Zhang, le modèle dépasse précédemment Alternatives open source sur les repères mathématiques calculaires.

Incroyablement, les chercheurs ont terminé la formation du modèle en moins de six heures sur 12 GPU NVIDIA H800 à un coût total estimé à 1 000 $. Ce Malaws Light-R1-32B l’une des approches les plus accessibles et les plus pratiques pour développer des modèles d’IA spécialisés en mathématiques hautement performants. Cependant, il est important de réchauffer que le modèle était la formation de la source ouverte d’Albab Qwen 2.5-32B-IstructQui est-elle présumée avoir eu beaucoup de coûts de formation au Royaume-Uni plus élevés.

Parallèlement au modèle, l’équipe a relâché ses données de formation et ses outils de scripts, la fourniture de transparents et le cadre accessoire pour la création de modèles d’IA axés sur les mathématiques.

Similaires des similaires Arrromebow-R12B Folklows de Rivals, Sich Asch Microsoft Orca-Math.

Un nouveau roi mathématique émerge

Pour aider à la raison complexe de Light-R1-32B, la formation de la recherche, les chercheurs se sont formés sur la raison de la longueur de la formation des trains modèles). Le Turricolula-tun (STT) AYY et OTPimisation (DPO) à Replember-Solorsts.

Lorsqu’il est évalué, Light-R1-32B a visé 76.6 sur AIME2.6 et 64,6 dépassant le test DeepEK-R1 – A 54,6 et respectivement.

Cette amélioration suggère que les effets d’approche du curriculum sont des effets d’approche du curriculum, où la formation de la formation, l’événement où entraîner des modèles Frough Frough, les modèles longs de l’Etitien.

Benchmarking équitable

À la référence de l’Ennsure Fair, les données de formation décontaminées de recherche sont des repères de raisonnement communs, y compris AIME24 / 25, MATH-500 et GPQA Dataman, empêchant les fuites de données.

Le filtrage de restauration également basé sur Iplehembetter UsePSCAR-1.5B-PREVIEW, formant Ultateetel de 76 000 ensembles de données pour un réglage fin supervisé. Un deuxième ensemble de données plus difficile de 3 000 exemples Fourher Performances améliorées.

Après l’entraînement, l’équipe a fusionné les versions Train Multiper de Light-R12B, ce qui a entraîné des gains supplémentaires. Natalement, le modèle MINUTES STREST STARTIES ABEIITÉS SUR LES RÉSONNES SCIENTIFIQUES TASONNING TASONNING TASKINES (GPQA), malgré l’être de mathématiques spéciales spéciales de mathématiques spéciales de mathématiques spéciales de mathématiques spécialisées par mathématiques spécialisées par mathématiques spéciales de mathématiques spécialisées par mathématiques spécialisées par mathématiques mathématiques spécialisées par mathématiques mathémaques spécialisées par mathématiques mathémaques spécialisées par mathématiques mathématiques.

Comment les entreprises peuvent bénéficier

Light-R1 3-32B est rehaussé dans la licence Apache 2.0, permet aux sources de sillage ouvertes à open-sources gratuites. Cette option attrayante malanes pour les entreprises, Ai Delivery Ai.

La licence comprend également une subvention de brevet mondiale libre de droits, réduisant les risques LEGA pour les entreprises tandis que les partis de déménagement. Les entreprises peuvent déploier librement de la lumière R1-32B dans des produits commerciaux, miniitakening total le contrôle de leur Hiène innone a été et transparents Écosystème d’IA.

Pour les PDG, les CTOS et les dirigeants informatiques, Apache 2.0 ENNSOURCES à l’efficacité et à l’indépendance des fournisseurs, éliminant les frais de licence et restreignant les départements sur le proprétaire Solutions d’IA. Les développeurs et les ingénieurs de l’IA acquièrent la flexibilité des mariages affiner, les informations de machine, la raison mathématique idalisée, la recherche et l’entreprise et l’entreprise et l’entreprise et l’entreprise d’applications AERI.

Cependant, comme la licence n’offre aucune garantie ou responsabilité de la Creed, la conformité déppoyant Light-R1-32B dans des environnements critiques.

Transparence dans la formation et l’optimisation à faible coût pour la résolution de problèmes mathématiques

Les chercheurs, Gaunt, R1-32B, fournit la manière validée et rentable de former des modèles de STOT dans des domaines spécialisés.

En partageant leur mairologie, leurs données de formation et leur code, l’objectif de l’objectif à réduire la barrière des coûts pour le développement d’IA à haute posformation. Loking Ahhead, ils prévoient d’explorer le renforcement d’apprentissage (RL) pour améliorer les capacités de raison du modèle.

Source link