Combien de lettres r y a-t-il dans le mot fraise?

Certaines personnes publient toujours sur l’incapacité des LLMS à dire combien de lettres particulières sont en un mot donné. Jetons un coup d’œil et essayons de comprendre le problème de base ici.

Cette lacune vient de la tokenisation. Les modèles de grands langues ne voient pas le texte comme des lettres, ils le voient comme des jetons. Un jeton peut correspondre à un seul mot, une syllabe, une phrase ou un seul caractère.

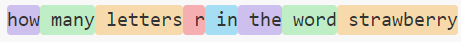

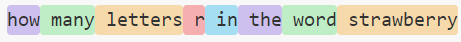

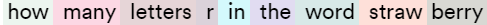

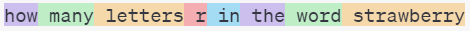

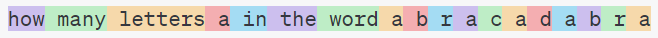

Voir c’est croire, alors jetez un œil à comment Lama 3, Anthropiqueet Openai Tokenize textes.

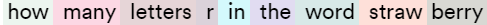

LLAMA 3:

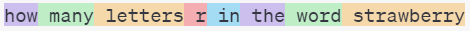

Anthropique:

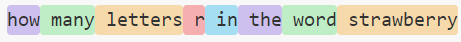

Openai:

Pour une analogie, imaginez demander combien de lettres e sont dans le mot 77. Cette question n’a aucun sens. Ce n’est que si vous développez «77» en «soixante-sept» que vous pouvez voir qu’il y a quatre lettres que les LLM ne peuvent pas faire cela.

Que peuvent faire les LLM

Une façon dont un LLM serait en mesure de répondre au Combien de lettres Les questions sont si elle a vu une phrase disant «Le mot xyz a trois lettres A», soit pendant la formation, soit peut-être en texte tiré avec un chiffon au moment de la réponse.

De plus, si un modèle a accès aux outils, par exemple un interprète Python, il peut le comprendre en écrivant du code. Par exemple, Claude-3.5-Sonnet dans Cursor fournit le code sans être invité à le faire.

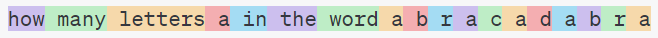

Pour déterminer combien de fois la lettre «a» apparaît dans le mot «abracadabra», nous pouvons utiliser un simple script python:

word = "abracadabra"

count = word.count('a')

print(f"The letter 'a' appears {count} times in '{word}'.")

Si vous voulez donner à un modèle une chance équitable avec les lettres, séparez-les avec des espaces afin que chaque lettre soit un jeton.

Une autre question responsable serait, combien jetons sont dans le mot «fraise», car un LLM devrait être en mesure de répondre à cela. Cependant, cela ne signifie pas que cela le fera.

Vous pouvez essayer de demander à un modèle quelque chose comme «Dans votre représentation interne en tant que LLM, combien de jetons le mot xyz est-il composé?»

Cela pourrait potentiellement fournir des indices sur les modèles d’identité inconnue. Par exemple, le chatbot perplexity.com dit Le mot «fraise» est principalement représenté comme un jeton unique dans mon vocabulairece qui suggérerait que c’est Llama. Cependant, il dit également que le mot «abracadabra» est un jeton unique, ce qui est peu probable.

Source link