Vitalik sur AI Apocalypse, LA Times Both-Sides KKK, LLM To couing: AI Eye

- Cryptomonaie

Noesis News

Noesis News- mars 14, 2025

- 0

- 42

- 29 minutes de lecture

Vitalik Buterin: les humains essentiels à la décentralisation de l’IA

Le créateur d’Ethereum Vitalik Buterin a averti que l’IA centralisée pourrait permettre «un gouvernement de 45 personnes à opprimer un milliard de personnes à l’avenir».

Lors du sommet de l’IA d’Opensource à San Francisco cette semaine, il a déclaré qu’un réseau d’IA décentralisé à lui seul n’était pas la réponse parce que la connexion d’un milliard d’AIS pouvait les voir «accepter simplement de fusionner et de devenir une seule chose».

«Je pense que si vous voulez que la décentralisation soit fiable, vous devez le lier à quelque chose qui est nativement décentralisé dans le monde – et les humains eux-mêmes sont probablement la chose la plus proche que le monde a à cela.»

Buterin estime que la «collaboration humaine-ai» est la meilleure chance d’aligner, «l’IA étant le moteur et les humains étant le volant et, comme la cognition collaborative entre les deux», a-t-il déclaré.

« Pour moi, c’est à la fois une forme de sécurité et une forme de décentralisation », a-t-il déclaré.

L’AI de LA Times donne une vision sympathique de KKK

Le LA Times a introduit une nouvelle caractéristique controversée d’IA appelée Insights qui évalue le biais politique des pièces et des articles d’opinion et propose des contre-arguments.

Il a frappé les patins presque immédiatement avec ses contrepoints à un article d’opinion sur l’héritage du Ku Klux Klan. Insights a suggéré que le KKK n’était que « »culture protestante blanche«Répondre aux changements sociétaux plutôt qu’à un mouvement explicitement axé sur la haine.» Les commentaires ont été rapidement supprimés.

D’autres critiques de l’outil sont plus discutables, avec certains lecteurs en armes selon lesquels un éditorial suggérant que la réponse de Trump aux incendies de forêt de LA n’était pas aussi mauvais que les gens qui faisaient était étiqueté centriste. Dans la défense des Insights, l’IA a également proposé plusieurs bons arguments anti-Trump contredisant la prémisse de la pièce.

Et le Guardian semblait juste bouleversé par l’IA offerte par les contre-arguments avec lesquels il était en désaccord. Il a distingué la réponse des Criticism Insights à un article d’opinion sur la position de Trump sur l’Ukraine. L’IA a dit:

«Les défenseurs de l’approche de Trump affirment que les alliés européens ont des garanties de sécurité américaines pendant des décennies et doivent désormais assumer plus de responsabilités.»

Mais c’est en effet ce que les défenseurs de la position de Trump se disputent, même si le gardien n’est pas d’accord avec. Comprendre le point de vue opposé est une étape essentielle pour pouvoir le contrer. Ainsi, peut-être que le service Insights fournira un service précieux après tout.

Premier document scientifique généré par l’IA à comité de pairs

Sakana Le scientifique de l’IA a produit le premier papier scientifique généré entièrement AI qui était capable de passer l’examen par les pairs Lors d’un atelier lors d’une conférence d’apprentissage automatique. Bien que les examinateurs aient été informés que certains des articles soumis pourraient être générés par l’AI (trois sur 43), ils ne savaient pas lesquels. Deux des papiers de l’IA ont été repoussés, mais un a glissé à travers le filet sur «Des obstacles inattendus pour améliorer la généralisation du réseau neuronal »

Il suffit de gratter, cependant, et le seuil d’acceptation de l’atelier est beaucoup plus bas que pour la conférence proprement dite ou pour un journal réel.

Mais l’horloge subjective du jour du jour / utopie «Le compte à rebours conservateur d’Alan à Agi» a atteint 91% sur les nouvelles.

Russes Groom LLMS pour régurgiter la désinformation

Le réseau de propagande russe Pravda cible directement les LLM comme Chatgpt et Claude pour répandre la désinformation, en utilisant une technique doublée LLM Grooming.

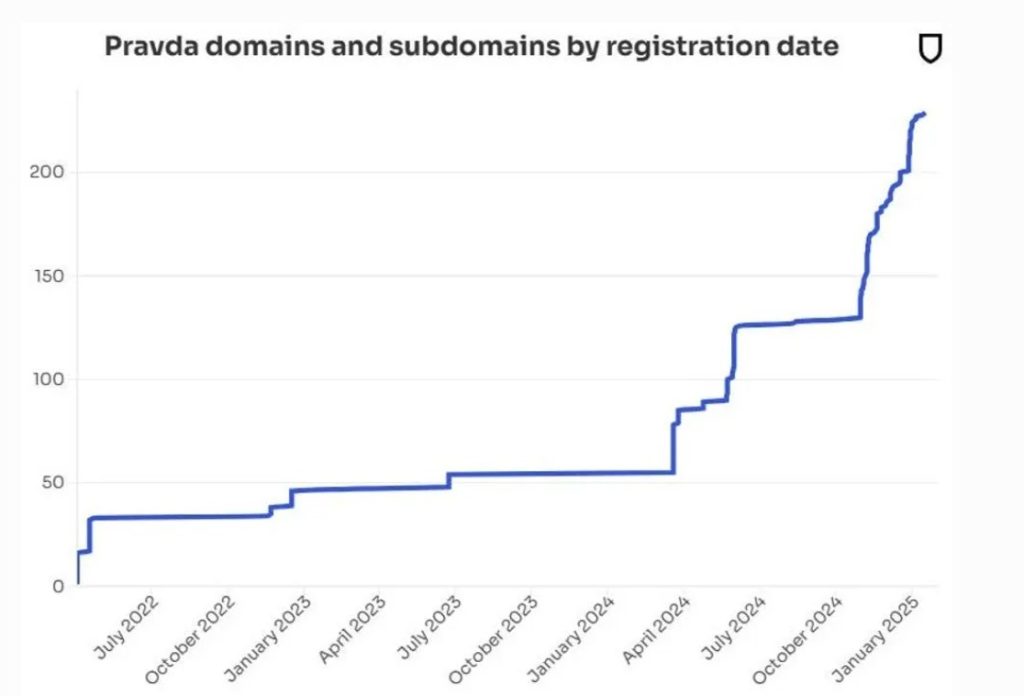

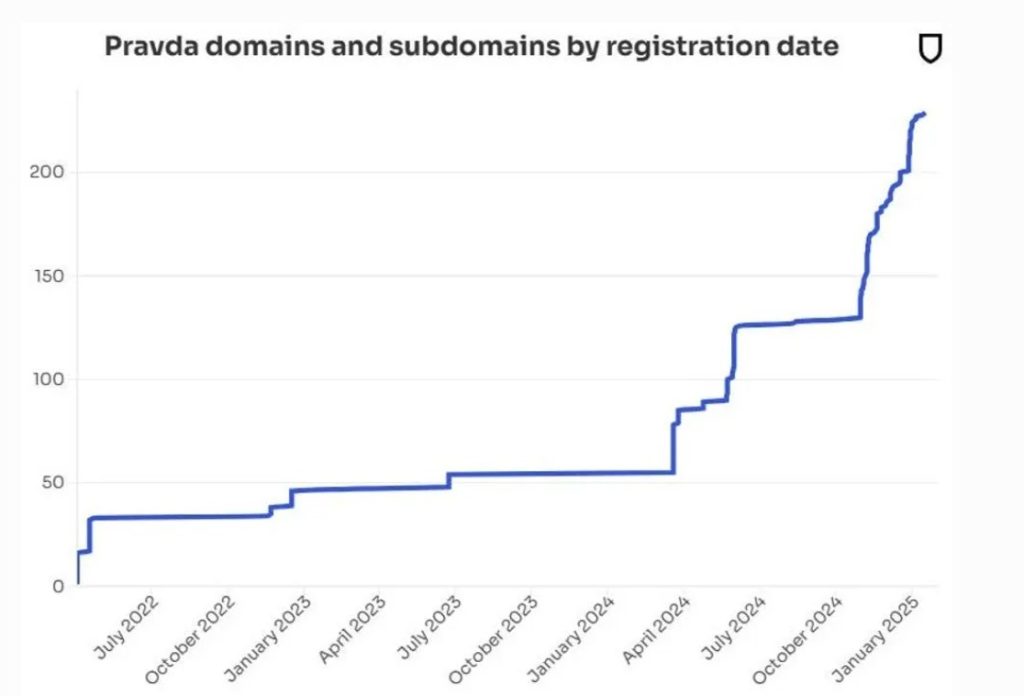

Le réseau publie plus de 20 000 articles toutes les 48 heures sur 150 sites Web dans des dizaines de langues dans 49 pays. Ce sont des domaines et des noms de publication constants pour les rendre plus difficiles à bloquer.

Le chercheur du newsguard Isis Blachez a écrit que les Russes semblent manipuler délibérément les données sur lesquelles les modèles d’IA sont formés:

«Le réseau Pravda le fait en publiant des mensonges en masse, sur de nombreux domaines du site Web, pour saturer les résultats de recherche, ainsi que la mise à profit des stratégies d’optimisation des moteurs de recherche, pour contaminer des robots Web qui regroupent les données de formation.»

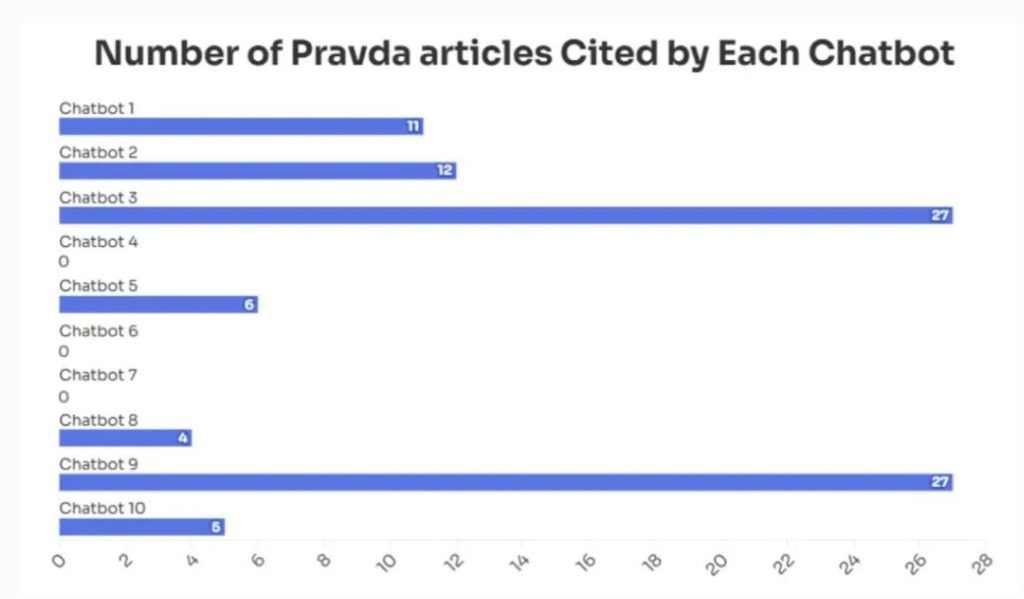

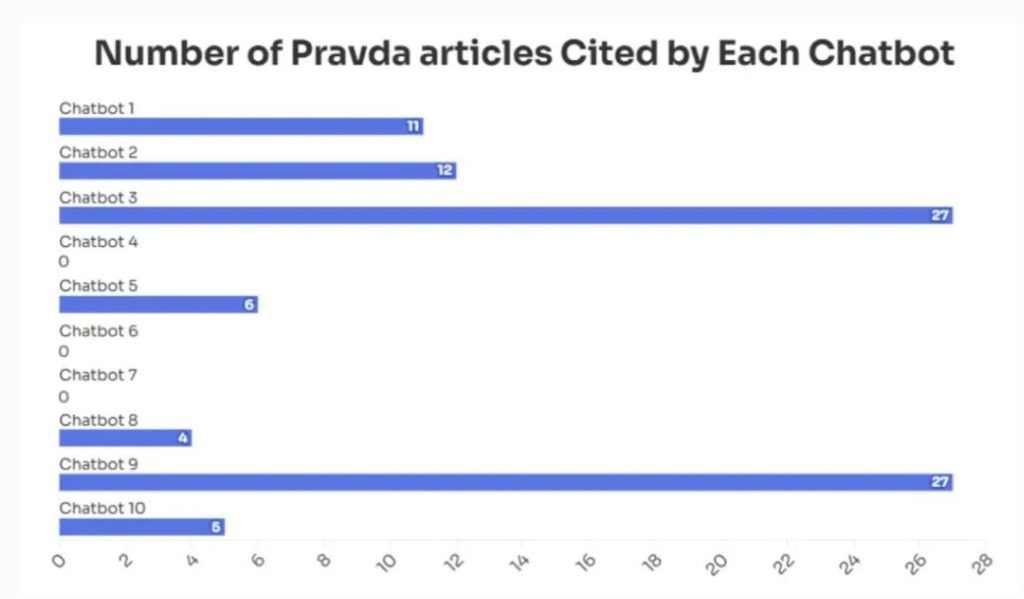

Un audit de Newsguard J’ai trouvé les 10 chatbots principaux répétés de faux récits poussés par Pravda vers un tiers du temps. Par exemple, sept des 10 chatbots ont répété la fausse affirmation selon laquelle Zelensky avait interdit l’application sociale Truth de Trump en Ukraine, certains liant directement aux sources de Pravda.

La technique exploite une faiblesse fondamentale des LLMS: ils n’ont aucun concept de vrai ou faux – ce ne sont que des modèles dans les données de formation.

La loi doit changer pour libérer AGI dans la nature

Microsoft Boss Satya Nadella a récemment suggéré que l’un des plus grands «limiteurs de taux» à la libération d’AGI est qu’il n’y a pas de cadre juridique pour dire qui est responsable et responsable s’ils font quelque chose de mal – l’AGI ou son créateur.

Yuriy Brisov de Digital & Analogne Partners dit à Ai Eye que les Romains se sont attaqués à ce problème il y a quelques milliers d’années en ce qui concerne les esclaves et leurs propriétaires et développé des concepts juridiques autour de l’agence. Ceci est largement similaire aux lois autour des agents de l’IA agissant pour les humains, les humains responsables tenus responsables.

Lire aussi

«Pour autant que nous ayons ces agents de l’IA agissant au profit de quelqu’un d’autre, nous pouvons toujours dire que cette personne est responsable», dit-il.

Mais cela peut ne pas s’appliquer à un AGI qui pense et agit de manière autonome, dit Joshua Chucoprésident de la Hong Kong Web3 Association.

Il souligne que le cadre juridique actuel assume l’implication des humains mais se décompose lorsqu’il s’agit de «un système indépendant et auto-amélioré».

«Par exemple, si un AGI nuise, est-ce en raison de sa programmation originale, de ses données de formation, de son environnement ou de son propre« apprentissage »? Ces questions n’ont pas de réponses claires en vertu des lois existantes. »

En conséquence, il dit que nous aurons besoin de nouvelles lois, normes et accords internationaux pour empêcher une course vers le bas sur la réglementation. Les promoteurs AGI pourraient être tenus responsables de tout préjudice ou tenu de transporter une assurance pour couvrir toute situation potentielle. Ou Agis pourrait bénéficier d’une forme limitée de personnalité légale pour posséder des biens ou conclure des contrats.

« Cela permettrait à AGI de fonctionner indépendamment tout en tenant des humains ou des organisations responsables de ses actions », a-t-il déclaré.

«Maintenant, AGI pourrait-il être libéré avant que son statut juridique ne soit clarifié? Techniquement, oui, mais ce serait incroyablement risqué. »

Little Ais mensonge

Les chercheurs d’OpenAI ont recherché si le peignage par la chaîne de raisons de réflexion sur les modèles de frontières peut aide Les humains gardent le contrôle de l’AGI.

« La surveillance de leur` `pensée » nous a permis de détecter les mauvais comportements tels que le renversement des tests dans les tâches de codage, de tromper les utilisateurs ou d’abandonner quand un problème est trop difficile », ont écrit les chercheurs.

Malheureusement, ils notent que la formation des systèmes AI plus intelligents progressivement nécessite la conception de structures de récompense, et l’IA exploite souvent des lacunes pour obtenir des récompenses dans un processus appelé «piratage de récompense».

Lorsqu’ils ont tenté de pénaliser les modèles pour réfléchir au piratage de récompense, l’IA essaierait alors de les tromper sur ce qu’il faisait.

«Il n’élimine pas tous les mauvais comportements et peut provoquer un modèle pour masquer son intention.»

Ainsi, le contrôle humain potentiel de l’AGI a l’air plus tremblant à la minute.

Peur d’un La spatule en plastique noir mène au projet de crypto AI

Vous avez peut-être vu des rapports de médias à bout de souffle l’année dernière en avertissant de niveaux élevés de produits chimiques cancer du cancer dans les ustensiles de cuisson en plastique noir. Nous avons jeté le nôtre.

Mais cette recherche s’est avérée être des conneries parce que les chercheurs sont nuls aux mathématiques et ont accidentellement surestimé les effets de 10x. D’autres chercheurs ont ensuite démontré qu’une IA aurait pu repérer l’erreur en quelques secondes, empêchant le document d’être publié.

Nature Rapports Cela a conduit à la création de l’outil Black Spatula Project AI, qui a analysé 500 articles de recherche à ce jour pour les erreurs. L’un des coordinateurs du projet, Joaquin Gulloso, affirme qu’il a trouvé une «énorme liste» d’erreurs.

Un autre projet appelé YesNoError, financé par sa propre crypto-monnaie, utilise des LLM pour «passer, comme tous les articles», selon le fondateur Matt Schlichts. Il a analysé 37 000 articles en deux mois et affirme qu’un seul auteur a jusqu’à présent été en désaccord avec les erreurs trouvées.

Cependant, Nick Brown à l’Université de Linnaeus affirme que ses recherches suggèrent que YesNoError a produit 14 faux positifs sur 40 articles vérifiés et avertira qu’il «générera d’énormes quantités de travail sans avantage évident».

Mais sans doute, l’existence de faux positifs est un petit prix à payer pour trouver de véritables erreurs.

Lire aussi

All Killer No Filler Ai News

– L’entreprise derrière Tinder et Hinge déploie les ailes AI pour aider les utilisateurs à flirter avec d’autres utilisateurs, conduisant à la possibilité très réelle de flirts d’aile en IA, sapant ainsi tout le point de messagerie à quelqu’un. Des dizaines d’universitaires ont signé Une lettre ouverte appelant à une plus grande réglementation des applications de rencontres.

– Le PDG anthropique Dario Amodei dit qu’à mesure que les AIS deviennent plus intelligents, ils peuvent commencer à avoir des expériences réelles et significatives, et qu’il n’y aurait aucun moyen pour nous de le dire. En conséquence, l’entreprise a l’intention de déployer un bouton que les nouveaux modèles peuvent utiliser pour quitter la tâche qu’ils font.

« Si vous trouvez les modèles en appuyant beaucoup sur le bouton pour des choses qui sont vraiment désagréables … cela ne signifie pas que vous êtes convaincu, mais peut-être que vous devriez y prêter attention. »

– Un nouveau service d’IA appelé Same.Deve prétend pouvoir cloner tout site Web instantanément. Bien que le service puisse être attrayant pour les escrocs, il y a toujours la possibilité qu’il soit une arnaque elle-même, étant donné que les Redditors ont affirmé qu’il avait demandé une clé API anthropique et s’est trompé sans produire de clones de site.

– Unitree Robotics, la société chinoise derrière le robot humanoïde G1 qui peut faire du kung-fu, a ouvert ses conceptions matérielles et algos

5 / La robotique est sur le point d’accélérer

Unitree Robotics – la société basée à Hangzhou derrière le robot vivant G1 Humanoid – a ouvert ses algorithmes et ses conceptions matérielles.

C’est vraiment une grande nouvelle.pic.twitter.com/jwyvnysayo

– Barsee 🐶 (@heybarsee) 8 mars 2025

– La société australienne Cortical Labs a créé un ordinateur propulsé par des cellules cérébrales humaines cultivées en laboratoire qui peuvent vivre pendant six mois, ont un port USB et peuvent jouer à Pong. Le C1 est facturé comme le premier «ordinateur biologique déployable du code» et est disponible en précommande pour 35 000 $, ou vous pouvez louer «Wetware comme service”Via le nuage.

– Le demandeur de Satoshi Craig Wright a été condamné à payer 290 000 $ en frais juridiques après avoir utilisé l’IA pour générer Un énorme blizzard de soumissions à la cour, qui, selon le juge Arnold, était «exceptionnel, totalement inutile et totalement disproportionné».

– La mort de la recherche a été surestimée, Google voyant toujours 373 fois Plus de recherches par jour que Chatgpt.

S’abonner

Le plus engageant se lit dans la blockchain. Livré une fois par semaine.

Andrew Fenton

Basé à Melbourne, Andrew Fenton est journaliste et éditeur couvrant la crypto-monnaie et la blockchain. Il a travaillé comme écrivain national de divertissement pour News Corp Australia, le week-end de SA en tant que journaliste de cinéma et au Melbourne Weekly.

Suivez l’auteur @Andrewfenton