Un encodeur visuel fondamental pour la compréhension vidéo

Un nombre étonnant de vidéos est disponible sur le Web, couvrant une variété de contenus des moments quotidiens que les gens partagent aux moments historiques aux observations scientifiques, chacune contenant un enregistrement unique du monde. Les bons outils pourraient aider les chercheurs à analyser ces vidéos, transformant la façon dont nous comprenons le monde qui nous entoure.

Les vidéos offrent un contenu visuel dynamique beaucoup plus riche que les images statiques, capturant le mouvement, les changements et les relations dynamiques entre les entités. L’analyse de cette complexité, ainsi que l’immense diversité des données vidéo accessibles au public, exige des modèles qui vont au-delà de la compréhension traditionnelle de l’image. Par conséquent, bon nombre des approches qui fonctionnent les mieux sur la compréhension vidéo reposent toujours sur des modèles spécialisés sur mesure pour des tâches particulières. Récemment, il y a eu des progrès passionnants dans ce domaine en utilisant des modèles de fondation vidéo (VIFMS), tels que Vidéoclip, Interne, Vidéocoaet Umt. Cependant, la construction d’un VIFM qui gère la diversité des données vidéo reste un défi.

Dans le but de construire un seul modèle pour la compréhension vidéo à usage général, nous introduisons « Videoprisme: un encodeur visuel fondamental pour la compréhension vidéo». Le vidéoprisme est un VIFM conçu pour gérer un large éventail de tâches de compréhension vidéo, notamment la classification, la localisation, la récupération, le sous-titrage et la réponse aux questions (QA). Nous proposons des innovations à la fois dans les données pré-formation ainsi que dans la stratégie de modélisation. Nous pré-trainons le vidéoprisme sur un ensemble de données massif et diversifié: 36 millions de paires de texte vidéo de haute qualité et 582 millions de clips vidéo avec texte parallèle bruyant ou généré par la machine. Notre approche de pré-formation est conçue pour ces données hybrides, pour apprendre à la fois à partir de paires de texte vidéo et des vidéos elles-mêmes. Le vidéoprisme est incroyablement facile à s’adapter aux nouveaux défis de la compréhension vidéo et atteint des performances de pointe en utilisant un seul modèle gelé.

Le vidéoprisme est un encodeur vidéo à usage général qui permet des résultats de pointe sur un large éventail de tâches de compréhension vidéo, y compris la classification, la localisation, la récupération, le sous-titrage et la réponse aux questions, en produisant des représentations vidéo à partir d’un seul modèle gelé.

Données de pré-formation

Un puissant VIFM a besoin d’une très grande collection de vidéos sur lesquelles s’entraîner – similaires à d’autres modèles de fondation (FMS), tels que ceux des modèles de grande langue (LLM). Idéalement, nous voudrions que les données pré-formation soient un échantillon représentatif de toutes les vidéos du monde. Bien que naturellement la plupart de ces vidéos ne disposent pas de légendes ou de descriptions parfaites, même le texte imparfait peut fournir des informations utiles sur le contenu sémantique de la vidéo.

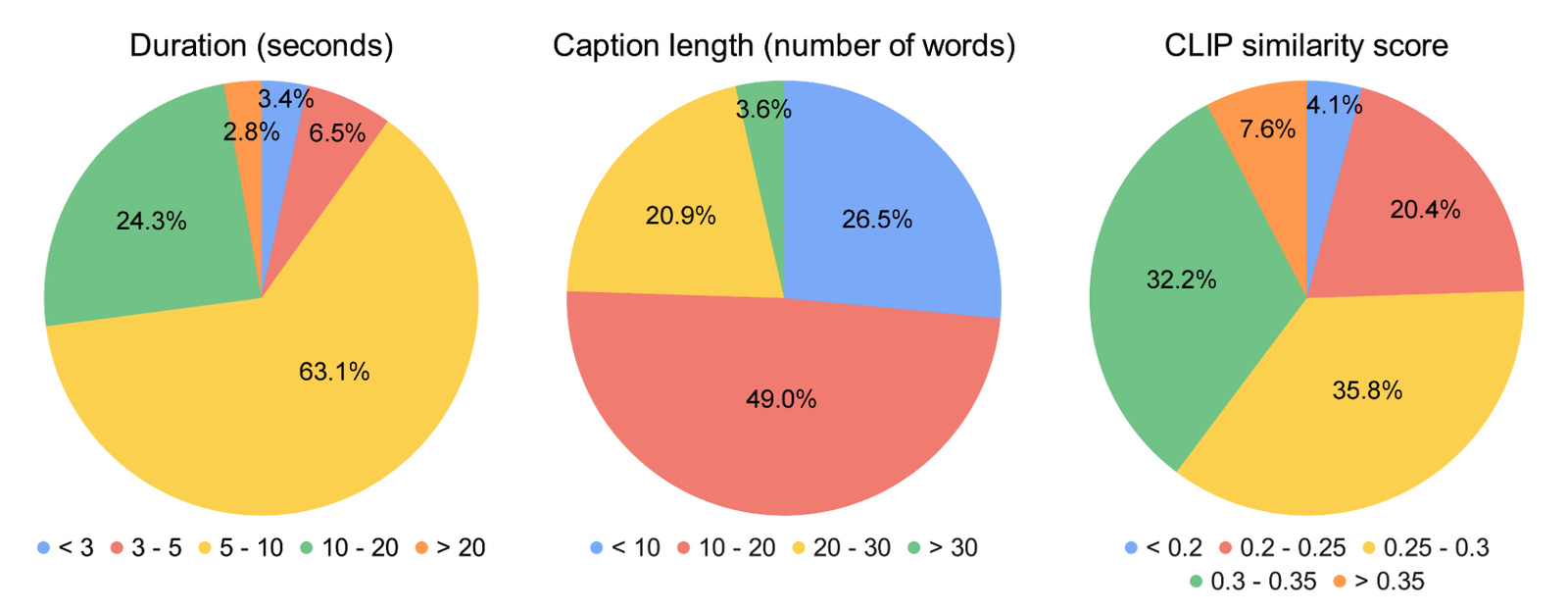

Pour donner à notre modèle le meilleur point de départ possible, nous avons mis en place un corpus pré-formation massif composé de plusieurs ensembles de données publics et privés, notamment YT-temporel-180m, Intervidal interne, Vidéoc, WTS-70metc. Cela comprend 36 millions de vidéos soigneusement sélectionnées avec des légendes de haute qualité, ainsi que 582 millions de clips supplémentaires avec différents niveaux de texte bruyant (comme les transcriptions générées automatiquement). À notre connaissance, il s’agit du corpus de formation vidéo le plus grand et le plus diversifié du genre.

|

| Statistiques sur les données de pré-formation de texte vidéo. Les grandes variations du Clip des scores de similitude (Plus il est élevé, le mieux) démontre la qualité de légende diversifiée de nos données pré-formation, qui est un sous-produit des différentes manières utilisées pour récolter le texte. |

Formation en deux étapes

L’architecture du modèle de vidéoprisme découle de la norme transformateur de vision (VIT) avec une conception factorisée qui code séquentiellement Vivifier. Notre approche de formation exploite à la fois les données de texte vidéo de haute qualité et les données vidéo avec du texte bruyant mentionné ci-dessus. Pour commencer, nous utilisons apprentissage contrastif (Une approche qui minimise la distance entre les paires de texte vidéo positives tout en maximisant la distance entre les paires de texte vidéo négatives) pour enseigner à notre modèle pour faire correspondre les vidéos avec leurs propres descriptions de texte, y compris les imparfaits. Cela crée une base pour faire correspondre le contenu du langage sémantique au contenu visuel.

Après une formation contrastive au texte vidéo, nous tirons parti de la collection de vidéos sans descriptions de texte. Ici, nous construisons sur le Framework de modélisation vidéo masquée Pour prédire les correctifs masqués dans une vidéo, avec quelques améliorations. Nous formons le modèle à prédire à la fois l’incorporation globale de niveau vidéo et les incorporations à jeton du modèle de première étape pour tirer parti efficacement les connaissances acquises à ce stade. Nous mélangeons ensuite au hasard les jetons prévus pour empêcher le modèle d’apprendre les raccourcis.

Ce qui est unique dans la configuration de VideoPrism, c’est que nous utilisons deux signaux de pré-formation complémentaires: descriptions de texte et le contenu visuel dans une vidéo. Les descriptions de texte se concentrent souvent sur les choses, tandis que le contenu vidéo fournit des informations sur le mouvement et la dynamique visuelle. Cela permet au vidéoprisme d’exceller dans des tâches qui exigent une compréhension de l’apparence et du mouvement.

Résultats

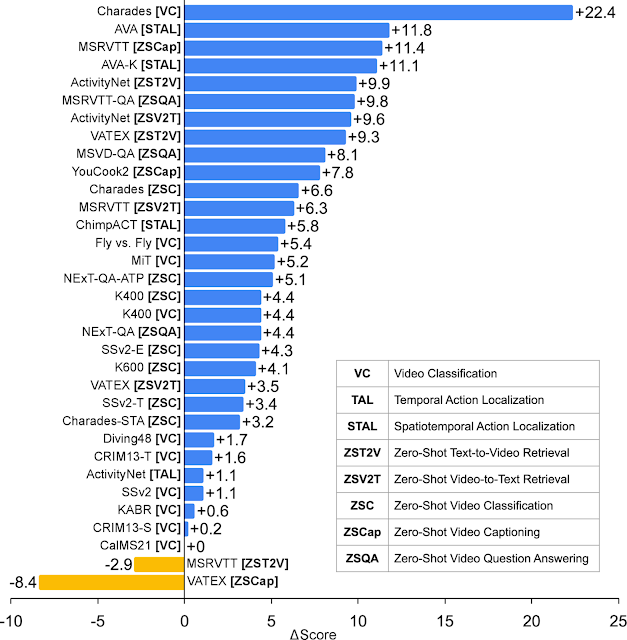

Nous effectuons une évaluation approfondie sur le vidéoprisme dans quatre grandes catégories de tâches de compréhension vidéo, notamment la classification vidéo et la localisation, la récupération de texte vidéo, le sous-titrage vidéo, la réponse aux questions et la compréhension de la vidéo scientifique. Le vidéoprisme réalise des performances de pointe sur 30 des 33 repères de compréhension vidéo – le tout avec une adaptation minimale d’un seul modèle gelé.

|

| Videoprisme par rapport aux FMS les mieux performants précédents. |

Classification et localisation

Nous évaluons le vidéoprisme sur une référence de compréhension vidéo à grande échelle existante (Vidéoglue) couvrant les tâches de classification et de localisation. Nous constatons que (1) le vidéoprisme surpasse tous les autres FMS de pointe, et (2) aucun autre modèle unique ne soit cohérent en deuxième place. Cela nous indique que le vidéoprisme a appris à emballer efficacement une variété de signaux vidéo dans un seul encodeur – de la sémantique à différentes granularités aux signaux d’apparence et de mouvement – et cela fonctionne bien dans une variété de sources vidéo.

Combinant avec LLMS

Nous explorons en outre la combinaison du vidéoprisme avec les LLM pour débloquer sa capacité à gérer diverses tâches en langue vidéo. En particulier, lorsqu’il est associé à un encodeur de texte (suivant Éclairé) ou un décodeur de langue (comme Palm-2), Le vidéoprisme peut être utilisé pour la récupération de texte vidéo, le sous-titrage vidéo et les tâches de l’AQ. Nous comparons les modèles combinés sur un ensemble large et difficile de références en langue visuelle. Le vidéoprisme établit la nouvelle état de l’art sur la plupart des repères. D’après les résultats visuels, nous constatons que le vidéoprisme est capable de comprendre des mouvements et des apparences complexes dans les vidéos (par exemple, le modèle peut reconnaître les différentes couleurs des objets de rotation sur la fenêtre dans les exemples visuels ci-dessous). Ces résultats démontrent que le vidéoprisme est fortement compatible avec les modèles de langue.

Nous montrons des résultats qualitatifs en utilisant le vidéoprisme avec un encodeur de texte pour la récupération de texte vidéo (première ligne) et adapté à un décodeur de langage pour la vidéo QA (deuxième et troisième rangée). Pour les exemples de récupération de texte vidéo, les barres bleues indiquent les similitudes d’intégration entre les vidéos et les requêtes texte.

Applications scientifiques

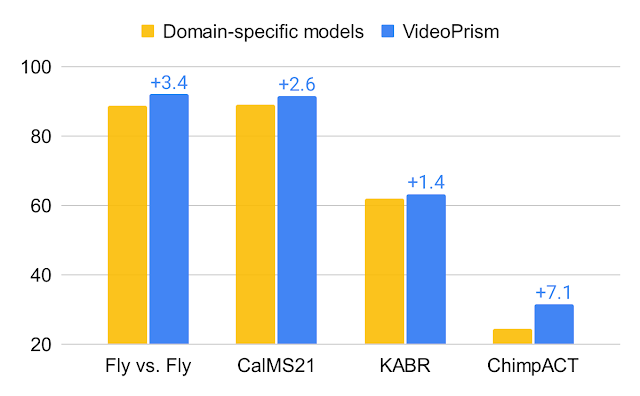

Enfin, nous testons le vidéoprisme sur des ensembles de données utilisés par les scientifiques à travers des domaines, y compris des domaines tels que l’éthologie, les neurosciences comportementales et l’écologie. Ces ensembles de données nécessitent généralement une expertise du domaine pour annoter, pour lesquelles nous tirons partis de jeux de données scientifiques existants ouverts par la communauté, notamment Fly vs Fly, Calms21, Chimpactet Kabr. Le vidéoprisme fonctionne non seulement exceptionnellement bien, mais dépasse en fait des modèles conçus spécifiquement pour ces tâches. Cela suggère que des outils comme le vidéoprisme ont le potentiel de transformer la façon dont les scientifiques analysent les données vidéo dans différents domaines.

Conclusion

Avec le vidéoprisme, nous introduisons un encodeur vidéo puissant et polyvalent qui établit une nouvelle norme pour la compréhension vidéo à usage général. Notre accent mis sur la construction d’un ensemble de données pré-formation massif et varié et de techniques de modélisation innovantes a été validée par nos évaluations approfondies. Non seulement le vidéoprisme surpasse régulièrement les lignes de base fortes, mais sa capacité unique à généraliser le positionne bien pour s’attaquer à un éventail d’applications réelles. En raison de son utilisation générale potentielle, nous nous engageons à poursuivre des recherches responsables dans cet espace, guidé par notre Principes d’IA. Nous espérons que le vidéoprisme ouvrira la voie à de futures percées à l’intersection de l’IA et de l’analyse vidéo, contribuant à réaliser le potentiel des VIFM à travers des domaines tels que la découverte scientifique, l’éducation et les soins de santé.

Remerciements

Cet article de blog est réalisé au nom de tous les auteurs de vidéoprisme: Long Zhao, Nitesh B. Gundavarapu, Liangzhe Yuan, Hao Zhou, Shen Yan, Jennifer J. Sun, Luke Friedman, Rui Qian, Tobias Weyand, Yue Zhao, Rachel Hornung. Hartwig Adam, Mikhail Sirotenko, Ting Liu et Boqing Gong. Nous remercions sincèrement David Hendon pour leurs efforts de gestion des produits, et Alex Siegman, Ramya Ganeshan et Victor Gomes pour leurs efforts de gestion du programme et des ressources. We also thank Hassan Akbari, Sherry Ben, Yoni Ben-Meshulam, Chun-Te Chu, Sam Clearwater, Yin Cui, Ilya Figotin, Anja Hauth, Sergey Ioffe, Xuhui Jia, Yeqing Li, Lu Jiang, Zu Kim, Dan Kondratyuk, Bill Mark, Arsha Nagrani, Caroline Pantofaru, Sushant Prakash, Cordelia Schmid, Bryan Seybold, Mojtaba Seyedhosseini, Amanda Sadler, Rif A. Saurous, Rachel Stigler, Paul Voigtlaender, Pingmei Xu, Chaochao Yan, Xuan Yang et Yukun Zhu pour les discussions, le soutien et les commentaires qui ont grandi qui ont contribué à ce travail. Nous sommes reconnaissants à Jay Yagnik, Rahul Sukthankar et Tomas Izo pour leur soutien enthousiaste à ce projet. Enfin, nous remercions Tom Small, Jennifer J. Sun, Hao Zhou, Nitesh B. Gundavarapu, Luke Friedman et Mikhail Sirotenko pour la formidable aide à la création de ce blog.

Source link