Robustesse certifiée asymétrique via des réseaux de neurones convexes – Le blog de recherche de Berkeley Artificial Intelligence Research

TLDR: Nous proposons le robustesse certifiée asymétrique Problème, qui nécessite une robustesse certifiée pour une seule classe et reflète des scénarios adversaires du monde réel. Ce paramètre ciblé nous permet d’introduire des classificateurs de fonctions de fonctionnalités, qui produisent des rayons certifiés en forme fermée et déterministe sur l’ordre des millisecondes.

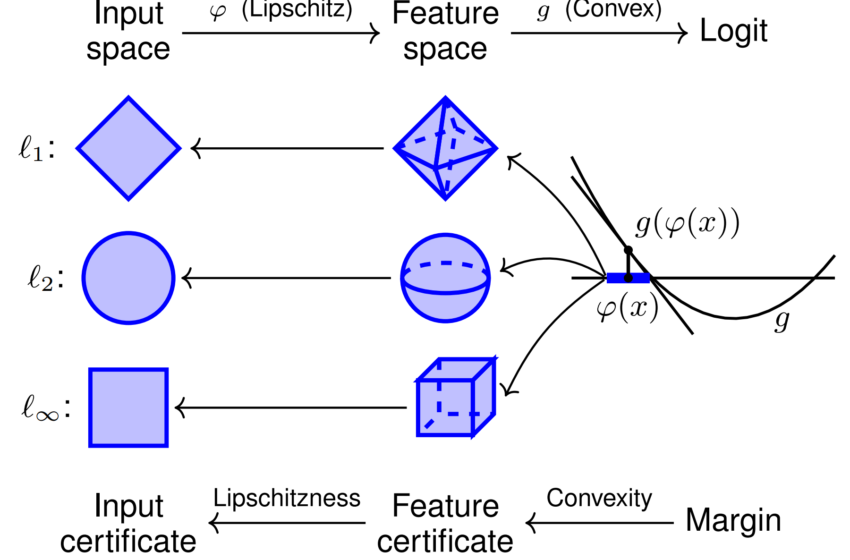

Figure 1. Illustration des classificateurs de convex caractéristiques et leur certification pour les entrées de classe sensible. Cette architecture compose une carte de fonctionnalité Continue-Continue à LipsChitz $ Varphi $ avec une fonction convexe apprise $ g $. Étant donné que $ g $ est convexe, il est sous-estimé à l’échelle mondiale par son plan tangent à $ varphi (x) $, produisant des balles de norme certifiées dans l’espace des fonctionnalités. Lipschitzness de $ varphi $ donne ensuite des certificats à l’échelle de manière appropriée dans l’espace d’entrée d’origine.

Malgré leur utilisation généralisée, les classificateurs d’apprentissage en profondeur sont très vulnérables à exemples adversaires: Perturbations d’images petites-imperceptibles humaines qui trompent les modèles d’apprentissage automatique pour mal classer l’entrée modifiée. Cette faiblesse sape gravement la fiabilité des processus critiques de sécurité qui incorporent l’apprentissage automatique. De nombreuses défenses empiriques contre les perturbations contradictoires ont été proposées, mais aussi pour être vaincues plus tard par des stratégies d’attaque plus fortes. Nous nous concentrons donc sur Classificateurs certifiablement robustesqui offre une garantie mathématique que leur prédiction restera constante pour une balle $ ell_p $ -Norm autour d’une entrée.

Les méthodes de robustesse certifiées conventionnelles entraînent une gamme d’inconvénients, notamment le non-déterminisme, l’exécution lente, la mauvaise mise à l’échelle et la certification contre une seule norme d’attaque. Nous soutenons que ces problèmes peuvent être résolus en affinant le problème de la robustesse certifiée pour être plus aligné sur les contextes contradictoires pratiques.

Le problème de robustesse certifié asymétrique

Les classificateurs actuels robustes produisent des certificats pour les intrants appartenant à n’importe quelle classe. Pour de nombreuses applications contradictoires du monde réel, cela est inutilement large. Considérez le cas illustratif de quelqu’un composant un e-mail d’arnaque à phishing tout en essayant d’éviter les filtres de spam. Cet adversaire tentera toujours de tromper le filtre du spam en pensant que leur e-mail de spam est bénin – jamais à l’inverse. Autrement dit, L’attaquant tente uniquement d’induire de faux négatifs du classificateur. Des paramètres similaires incluent la détection de logiciels malveillants, les fausses inscriptions, la détection des bots de médias sociaux, le filtrage des réclamations d’assurance médicale, la détection de fraude financière, la détection de sites Web de phishing et bien d’autres.

Figure 2. Robustesse asymétrique dans le filtrage des e-mails. Les paramètres contradictoires pratiques nécessitent souvent une robustesse certifiée pour une seule classe.

Ces applications impliquent toutes un paramètre de classification binaire avec une classe sensible qu’un adversaire tente d’éviter (par exemple, la classe «e-mail de spam»). Cela motive le problème de robustesse certifiée asymétriquequi vise à fournir des prédictions certificiellement robustes pour les entrées dans la classe sensible tout en maintenant une précision élevée pour toutes les autres entrées. Nous fournissons une déclaration de problème plus formel dans le texte principal.

Classificateurs de convex

Nous proposons Réseaux de neurones convexes Pour résoudre le problème de robustesse asymétrique. Cette architecture compose une carte de fonctionnalité simple-continu de LipsChitz $ { varphi: mathbb {r} ^ d to mathbb {r} ^ q} $ avec un réseau neuronal saisi-convex (icnn) $ {g: mathbb {r} ^ q à mathbb {r}} $ (figure 1). Les ICNN appliquent la convexité de l’entrée à la logit de sortie en composant les non-linéarités de relu avec des matrices de poids non négatives. Étant donné qu’une région de décision binaire ICNN se compose d’un ensemble convexe et de son complément, nous ajoutons la carte de fonctionnalité précomposée $ varphi $ pour permettre des régions de décision non convexes.

Les classificateurs de convex en fonctionnalité permettent le calcul rapide des rayons certifiés de classe sensible pour tous les $ ell_p $ -Norms. En utilisant le fait que les fonctions convexes sont à l’échelle mondiale sous-approchée par n’importe quel plan tangent, nous pouvons obtenir un rayon certifié dans l’espace de caractéristique intermédiaire. Ce rayon est ensuite propagé à l’espace d’entrée par Lipschitzness. Le paramètre asymétrique ici est essentiel, car cette architecture ne produit que des certificats pour la classe de logit positive $ g ( varphi (x))> 0 $.

La formule de rayon certifiée $ ell_p $-Norm $ résultant est particulièrement élégante:

(r_p (x) = frac { couleur {bleu} {g ( varphi (x))}} { mathrm {lèvre} _p ( varphi) couleur {red} { | nabla g ( varphi (x)) | _ {p, *}}}. )Les termes non constants sont facilement interprétables: le rayon évolue proportionnellement au Confiance du classificateur et inversement au Sensibilité au classificateur. Nous évaluons ces certificats sur une gamme d’ensembles de données, réalisons des certificats de $ ell_1 $ compétitifs et des certificats comparables $ ell_2 $ et $ ell _ { infty} $ – malgré d’autres méthodes qui adaptent généralement une norme spécifique et nécessitant des commandes d’ampleur plus d’exécution.

Figure 3. Radis certifiés de classe sensible sur l’ensemble de données CIFAR-10 CATS VS DOGS pour le $ ell_1 $ -Norm. Les temps d’exécution à droite sont en moyenne sur $ ell_1 $, $ ell_2 $ et $ ell _ { infty} $ – radii (note la mise à l’échelle du journal).

Nos certificats contiennent pour tout $ ell_p $ -Norm et sont fermés et déterministes, ne nécessitant qu’un seul avant et en arrière par entrée. Ceux-ci sont calculables sur l’ordre des millisecondes et bien évoluer avec la taille du réseau. À titre de comparaison, les méthodes actuelles de pointe telles que le lissage randomisé et la propagation liée à l’intervalle prennent généralement plusieurs secondes pour certifier même les petits réseaux. Les méthodes de lissage randomisées sont également intrinsèquement non déterministes, avec des certificats qui ne sont que avec une forte probabilité.

Promesse théorique

Bien que les premiers résultats soient prometteurs, nos travaux théoriques suggèrent qu’il existe un potentiel inexploité significatif dans les ICNN, même sans carte de fonctionnalité. Bien que les ICNN binaires soient limités à l’apprentissage des régions de décision convexes, nous prouvons qu’il existe un ICNN qui atteint une précision de formation parfaite sur l’ensemble de données CIFAR-10 CATS-VS-DOGS.

Fait. Il existe un classificateur de convex d’entrée qui atteint une précision de formation parfaite pour l’ensemble de données CIFAR-10 Cats-Versus-Dogs.

Cependant, notre architecture n’atteint que 73,4 $ % $ de précision de formation sans carte de fonctionnalité. Bien que la performance de la formation n’implique pas la généralisation de l’ensemble de tests, ce résultat suggère que les ICNN sont au moins théoriquement capables d’atteindre le paradigme moderne d’apprentissage automatique de sur-ajustement à l’ensemble de données de formation. Nous posons donc le problème ouvert suivant pour le domaine.

Problème ouvert. Apprenez un classificateur d’entrée-convex qui atteint une précision de formation parfaite pour l’ensemble de données CIFAR-10 Cats-Versus-Dogs.

Conclusion

Nous espérons que le cadre de robustesse asymétrique inspirera de nouvelles architectures qui sont certifiables dans ce cadre plus ciblé. Notre classificateur de fonction de fonctionnalité est une de ces architectures et fournit des rayons certifiés rapidement et déterministes pour tout $ ell_p $ -Norm. Nous posons également le problème ouvert de la sur-ajustement de l’ensemble de données de formation CIFAR-10 Cats vs Dogs avec un ICNN, que nous montrons est théoriquement possible.

Ce message est basé sur l’article suivant:

Robustesse certifiée asymétrique via des réseaux de neurones convexes

Samuel PFROMMER,

Brendon G. Anderson,

Julien Piet,

Somayeh Sojoudi,

37e conférence sur les systèmes de traitement de l’information neuronal (INIPS 2023).

De plus amples détails sont disponibles sur arxiv et Github. Si notre article inspire votre travail, envisagez de le citer avec:

@inproceedings{

pfrommer2023asymmetric,

title={Asymmetric Certified Robustness via Feature-Convex Neural Networks},

author={Samuel Pfrommer and Brendon G. Anderson and Julien Piet and Somayeh Sojoudi},

booktitle={Thirty-seventh Conference on Neural Information Processing Systems},

year={2023}

}

Source link