Regardez l’atlas humanoïde s’adapter à l’évolution de l’environnement

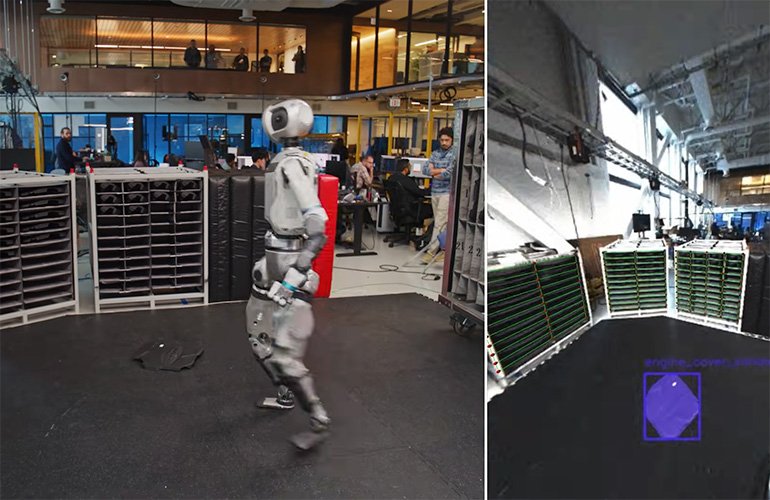

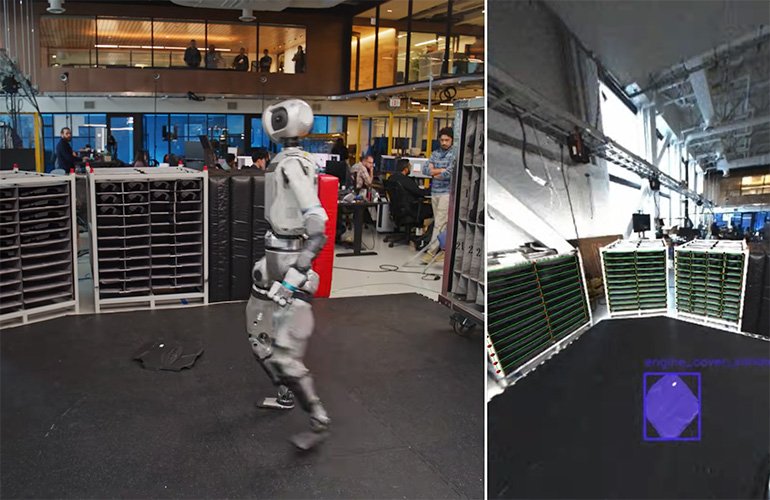

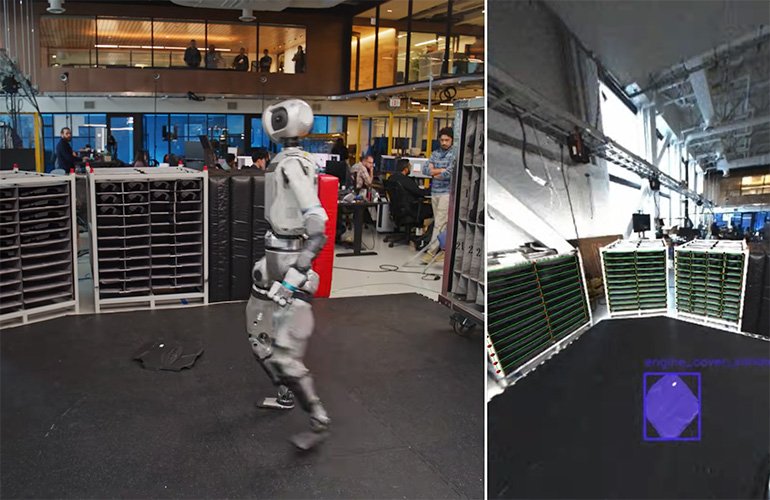

Boston Dynamics a publié une nouvelle vidéo mettant en évidence comment son nouvel Humanoid ATLAS électrique effectue des tâches dans le laboratoire. Vous pouvez regarder la vidéo ci-dessus.

La première chose qui me frappe de la vidéo est la façon dont Atlas présente sa perception en temps réel. La vidéo montre comment Atlas enregistre activement son cadre de référence pour les couvercles du moteur et tous les emplacements de cueillette / place. Le robot met continuellement à jour sa compréhension du monde pour gérer efficacement les pièces. Lorsqu’il ramasse quelque chose, il évalue la topologie de la pièce – comment le gérer et où le placer.

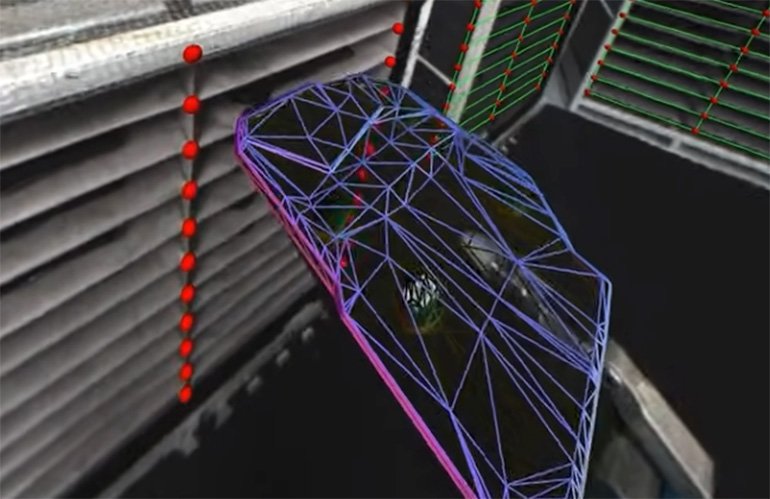

Atlas perçoit la topologie de la partie tenue dans sa main lorsqu’elle acquiert la pièce à partir de l’étagère. | Crédit: Boston Dynamics

Ensuite, il y a ce moment à 1:14 dans la démo où un ingénieur a laissé tomber une couverture de moteur sur le sol. Atlas réagit comme s’il entendait la partie frapper le sol. L’humanoïde regarde ensuite autour, localise la pièce, trouve comment le récupérer (encore une fois, évaluant sa forme) et le place avec la précision nécessaire dans la zone de couverture du moteur.

« Dans ce clip particulier, le comportement de recherche est déclenché manuellement », a déclaré Scott Kuindersma, directeur principal de la recherche en robotique chez Boston Dynamics « , a déclaré Le rapport robot. «Le robot n’utilise pas de signaux audio pour détecter une couverture de moteur frappant le sol. Le robot est de manière autonome de l’objet sur le sol, donc en pratique, nous pouvons exécuter le même modèle de vision passivement et déclencher le même comportement si une couverture du moteur (ou toute partie avec laquelle nous travaillons) est détectée hors de la fixation pendant le fonctionnement normal.»

La vidéo met en évidence la capacité d’Atlas à s’adapter et à percevoir son environnement, à ajuster son concept de ce monde et à s’en tenir à sa tâche assignée. Il montre comment Atlas peut gérer les environnements chaotiques, maintenir son objectif de tâche et apporter des modifications à sa mission à la volée.

Atlas peut scanner le sol et identifier une pièce sur le sol qui n’y appartient pas. | Crédit: Boston Dynamics

« Lorsque l’objet est en vue des caméras, Atlas utilise un modèle d’estimation de la pose d’objet qui utilise une approche de rendu et de compare pour estimer la pose des images monoculaires », a écrit Boston Dynamics dans un blog sur la vidéo. «Le modèle est formé avec des données synthétiques à grande échelle et se généralise zéro-shot à de nouveaux objets étant donné un modèle de CAO. Lorsqu’il est initialisé avec une pose 3D antérieure, le modèle le raffine de manière itérative pour minimiser l’écart entre le modèle CAO rendu et l’image de la caméra capturée. Alternativement, l’estimateur de la pose peut être initialisé à partir d’une région 2D de l’intérêt (comme un masque d’objet). Les hypothèses qui sont alimentées à un modèle de notation, et l’hypothèse la plus ajustée est ensuite affinée.

Je vois, donc je suis

Robot Vision Guidance est viable depuis les années 1990. À cette époque, les robots pouvaient suivre les éléments des convoyeurs en mouvement et ajuster les cadres de référence locaux pour un assemblage de la carte de circuit imprimé basé sur les fiduciaux. Rien n’est surprenant ou nouveau sur cette pointe pour les conseils de vision des robots.

Ce qui est unique maintenant pour les humanoïdes, c’est la mobilité du robot. Tout manipulateur mobile doit mettre à jour systématiquement sa carte du monde. MODERN ROBOT Vision Guidance utilise des modèles de langage de vision (VLM) pour comprendre le monde à travers l’œil de la caméra.

Ces robots industriels plus anciens ont été fixés au sol et ont utilisé des routines de vision 2D et d’étalonnage complexes pour cartographier le champ de vision de la caméra. Ce que nous voyons démontré avec Atlas est un robot mobile et humanoïde comprenant son environnement et poursuivant sa tâche alors que l’environnement change autour du robot. Les robots modernes ont une compréhension 3D du monde qui les entoure.

Boston Dynamics admet que cette démo est un mélange de fonctions basées sur l’IA (comme la perception) et une programmation procédurale pour gérer la mission. La vidéo est une bonne démonstration de la progression des capacités de l’évolution du logiciel. Pour que ces systèmes fonctionnent dans le monde réel, ils doivent gérer à la fois des changements subtils et des changements de macro dans leurs environnements d’exploitation.

Faire son chemin à travers le monde

C’est fascinant de regarder Atlas Move. Les mouvements, parfois, semblent un peu étranges, mais c’est une excellente illustration de la façon dont l’IA perçoit le monde et les choix qu’il fait pour se déplacer dans le monde. Nous ne pouvons assister qu’à une petite tranche de cette prise de décision dans la vidéo.

Dynamique de Boston a précédemment publié une vidéo montrant des comportements basés sur la capture de mouvement (MOCAP). La vidéo MOCAP montre l’agilité du système et ce qu’elle peut faire avec une entrée fluide. La secousse de cette dernière vidéo, sous la prise de décision et le contrôle de l’IA, est loin des démonstrations de MOCAP en impulsion de la vallée de la vallée. Nous avons également présenté Boston Dynamics CTO Aaron Saunders en tant que présentateur d’honneur au 2025 Robotics Summit and Expo à Boston.

Il reste beaucoup de traitement en temps réel pour Atlas pour comprendre son monde. Dans la vidéo, nous voyons le robot s’arrêter pour traiter l’environnement, avant qu’il ne prenne une décision et continue. Je suis convaincu que cela ne fera que se rendre plus rapide au fil du temps à mesure que le code évolue et que les modèles d’IA deviennent meilleurs dans leur compréhension et leur adaptabilité. Je pense que c’est là que la course est maintenant: développer le logiciel basé sur l’IA qui permet à ces robots de s’adapter, de comprendre leur environnement et d’apprendre en permanence d’une variété de données multimodales.

Note de l’éditeur: Cet article a été mis à jour à 13 h 46 Eastern avec un devis de Scott Kuindersma, directeur principal de la recherche en robotique chez Boston Dynamics.

Source link