(R) Tsinghua University, Stanford University, CMU, et Tencent a publié conjointement une référence, nommée Rbench-V, pour un raisonnement visuel.

|

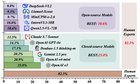

🥰🥳O3 a impressionné tout le monde par son raisonnement visuel. Nous proposons d’abord une référence pour le raisonnement visuel avec des sorties multimodales, Rbench-V。 😍 Résultats très intéressants. MLLM ne peut pas effectuer un raisonnement visuel efficace. (O3: 25,8%, Gemini 2.5pro: 20,2%, mais humain: 82,3%) Performances de différents modèles sur Rbench-V Idée clé de Rbench-V: Évaluation du raisonnement visuel avec des sorties multimodales. Vérifiez notre papier et nos données: https://arxiv.org/pdf/2505.16770 soumis par / u / uyzhang |