Tl; dr: Les méthodes SSL actuelles comme SWAV, Dino et Vicregl utilisent plusieurs vues, mais les manipulez par voie suboptimale en agrégeant les pertes par paires, provoquant des objectifs contradictoires et des interactions manquées. Nous introduisons MV-Infonce et MV-DHEL – des objectifs de principe qui évoluent correctement avec un certain nombre de vues et empêchant l’effondrement de la dimensionnalité.

Papier: https://arxiv.org/abs/2507.06979

Code: https://github.com/pakoromilas/multi-view-cl

Le problème

Les méthodes SSL actuelles créent plusieurs vues augmentées, mais les manipulent par l’agrégation de perte par paire:

L_total = L(v1,v2) + L(v1,v3) + L(v1,v4) + L(v2,v3) + L(v2,v4) + L(v3,v4)

Cette approche provoque:

- Objectifs contradictoires: Chaque vue satisfait à plusieurs termes de perte concurrents

- Relations de vision ignorées: L’agrégation par paire manque les interactions de vue entre toutes les vues

- Limitations fondamentales: Hérite des problèmes (par exemple, couplage d’alignement-uniformité) à partir des pertes de CL par paires

- Transfert limité: Les avantages multi-visualités diminuent à mesure que vous ajoutez plus de vues

Le problème de clip: Alors que Clip a révolutionné l’apprentissage en langue visuelle, l’étendre à plus de 3 modalités n’est toujours pas simple. Le cadre contrastif de Clip est intrinsèquement par paire – l’ajout de données audio, vidéo ou capteurs nécessite des modèles séparés par paire ou une agrégation naïve, qui ne parviennent pas à capturer toutes les interactions multimodales simultanément.

Nos fonctions de perte

- Mv-infonce: Étend l’infonction à n vues correctement

- Mv-dhel: Découpe l’alignement de l’uniformité

Résultats clés

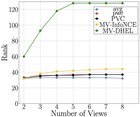

✅ Faire à l’échelle correctement avec le nombre de vues

✅ Empêcher l’effondrement de la dimensionnalité Lorsque vous utilisez plus de 5 vues (figure ci-dessous)

✅ Surpasser Approches multi-visualités sur ImageNet1k et trois autres ensembles de données

✅ S’étendre à plus de 3 modalités (pas seulement 2!)

https://preview.redd.it/vib4lluozrff1.png?width=1200&format=png&auto=webp&s=9c0daafe65e74c8a24bca93f2343d3c17a1767f2

Contributions globales

- Formulation multi-visualités fondée sur des principes: Framework mathématique qui étend correctement CL des paramètres par paire à la multi-visualités, la modélisation des interactions simultanées entre toutes les vues N plutôt que d’agréger les comparaisons par paires

- Nouvelles fonctions de perte: (i) MV-infonce – Extension naturelle de l’infoncé incorporant toutes les interactions de vue, (ii) MV-DHEL – Découpe l’alignement de l’uniformité à travers les vues

- Garanties théoriques: Prouvé que les deux objectifs partagent un comportement asymptotique avec l’infoncé traditionnelle, les établissant comme des extensions théoriquement solides

- Avancées empiriques: Surpassent constamment les approches existantes, évoluent efficacement avec la multiplicité de la vue, atténuer l’effondrement de la dimensionnalité avec des vues suffisantes

- Applicabilité multimodale: Contrairement aux méthodes existantes conçues pour les paramètres bimodaux, directement applicables à plus de 3 modalités

Applications possibles

- Au-delà des coups: Apprentissage multimodal avec vision + texte + audio + données de capteur

- Compréhension vidéo: Temporal + spatial + vues sémantiques dans un cadre unifié

- Imagerie médicale: Plusieurs types de scan (CT, IRM, radiographie) sans limitations par paire

- Robotique: Vision + Tactile + Sens proprioceptif avec garanties théoriques

Le repo GitHub comprend des implémentations Pytorch.

Heureux de discuter de nos recherches!