Que se passe-t-il si nous avons des réseaux de neurones à valeur complexe? Une expérience de pensée | par Ashutosh Kumar | Juin 2025

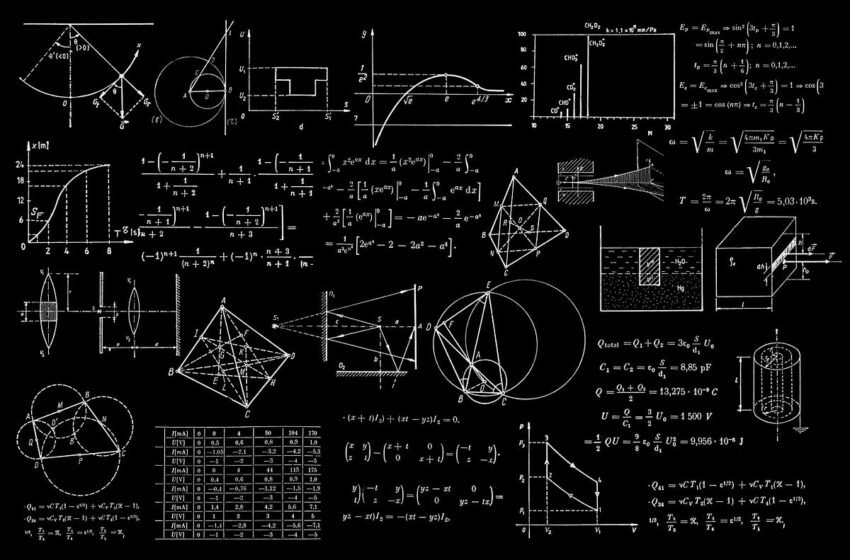

Dans l’apprentissage automatique, nous construisons de vastes réseaux de neurones artificiels, des cerveaux numériques qui apprennent, prédisent et créent. Ces neurones, pour la plupart, «pensent» en nombre réel – la ligne de nombre familier que nous avons apprise à l’école. Mais que se passe-t-il s’ils n’avaient pas à le faire?

Et si nos réseaux de neurones pouvaient utiliser la puissance d’un système de nombres plus riches et plus descriptif? Ce n’est pas seulement une approche de fantaisie; C’est une expérience de pensée qui commence par une question simple sur l’un des outils les plus courants de notre kit d’IA: tanh fonction d’activation.

Le Tanh, nous connaissons et aimons pour sa stabilité

Dans un réseau neuronal standard, une fonction d’activation décide si un neurone doit «tirer» ou non. La tangente hyperbolique, ou tanh est un choix populaire pour ce travail. Pour toute entrée réelle qu’elle reçoit, tanh(x) Soufflez-le dans une plage soignée et prévisible entre -1 et 1 (belle courbe en forme de S).

C’est stable, il est centré sur zéro et c’est continu. Il empêche les activations du réseau d’exploser dans l’infini, fournissant une base solide pour l’apprentissage. Ce comportement fiable découle de sa définition, qui est enracinée dans une fonction exponentielle.

Pour tout nombre réel x Nous nous branchons, cette fonction se comporte parfaitement. Mais que se passe-t-il si nous osons brancher un numéro qui n’est pas sur la ligne numérique? Que se passe-t-il si nous utilisons un numéro imaginaire?

Un aperçu du terrier du lapin: Tanh dans le plan complexe

C’est là que commence notre expérience de pensée. Remplacement de la variable réelle x avec un imaginaire, ixoù i est la racine carrée OS -1. Qu’est-ce que tanh(ix)? Pour le savoir, nous devons d’abord voir comment ses composants, sinh et coshse comporter. Ici, nous avons besoin de l’une des équations les plus élégantes de toutes les mathématiques, Formule d’Euler:

Maintenant, nous avons des outils pour aborder notre question initiale. Qu’est-ce que tanh(ix)?

C’est un résultat profond, le tanh La fonction, qui est censée être stable, devient la fonction tangente trigonométrique lorsque nous l’avons utilisé dans le domaine imaginaire. La courbe S délimitée, prévisible se transforme en une fonction célèbre pour sa nature sauvage, périodique et illimitée. Le tanh(x) La fonction a des singularités, tirant à l’infini à intervalles réguliers (à des multiples étranges de pi/2).

Ainsi, notre fonction d’activation stable a un côté caché et volatile. Ce n’est pas un défaut; Mais une porte vers quelque chose d’intéressant.

Sinon Tanh, relu peut-être?

À ce stade, vous vous demandez peut-être: qu’en est-il du roi incontesté des fonctions d’activation moderne, le Unité linéaire rectifiée (RELU)? Rien de personnel, je viens d’expérimenter tanhd’abord. Défini comme ReLU(x)=max(0,x)c’est bon marché et très efficace. Nous pouvons sûrement l’étendre au plan complexe?

Le moyen le plus évident de créer un relu complexe, ou Creluc’est l’appliquer séparément aux parties réelles et imaginaires: CReLU(z)=ReLU(z) + i*ReLU(y) où z=x+iy. Cela semble assez simple. Mais est-il considéré comme une véritable fonction d’activation dans le plan complexe? Pour cela, il doit être holomorphe (une propriété de différenciation complexe, comme nous l’avons discuté ci-dessus). Une fonction est holomorphe si elle satisfait un ensemble de conditions appelées Équations de Cauchy-Riemann. Sans devenir trop profondément dans les mauvaises herbes, ces équations garantissent que la dérivée d’une fonction à un point est cohérente, quelle que soit la direction dans laquelle vous vous approchez.

Lorsque nous testons notre Crelu, nous constatons qu’il échoue à ce test de façon spectaculaire. Les équations ne tiennent que dans les quadrants spécifiques où le comportement est trivialement constant. Cela signifie que Crelu est pas une fonction holomorphe. Il n’a pas la différenciation fluide et cohérente qui permet des calculs élégants de gradient.

Cela ne signifie pas que c’est inutile; Il est souvent utilisé dans la pratique, mais c’est une solution de contournement d’ingénierie, pas une solution mathématiquement pure. Il met en évidence une leçon critique: ce qui fonctionne sans effort dans le domaine réel peut devenir maladroit et «mal réalisé» dans le domaine complexe.

Et si les neurones pouvaient «penser» en nombre complexe?

Cette découverte sur tanh Invite une question plus importante: que se passe-t-il si un réseau de neurones entier (poids, biais et signaux) fonctionnait sur des nombres complexes? Appelons cela un réseau neuronal à valeur complexe (CVNN).

Dans un CVNN, chaque nombre a deux parties: une partie réelle et une partie imaginaire, ou de manière équivalente, une magnitude et une phase. Cela change immédiatement le jeu.

- Informations plus riches: Un seul nombre complexe peut représenter des concepts interconnectés comme l’amplitude et la phase d’une onde sonore, ou l’amplitude et l’angle d’un pixel dans une image spécialisée (comme une IRM). Un réseau à valeur réelle aurait besoin de deux neurones distincts et pourrait perdre la relation intrinsèque entre eux.

- Une opération plus puissante: Dans un réseau standard, la multiplication par un poids à l’échelle d’une entrée. Dans un CVNN, la multiplication complexe fait deux choses à la fois: elle évolue l’amplitude et tourne la phase. Cette dynamique de rotation intégrée permet au CVNN d’apprendre des transformations géométriques complexes beaucoup plus efficacement.

Les CVNN sont un ajustement naturel pour les problèmes impliquant des vagues, des oscillations et des rotations, dominant dans des champs tels que le traitement du signal, les communications sans fil et la technologie radar.

La promesse et le paradoxe

Cependant, notre tanh L’expérience a également exposé le défi central des CVNN: la fonction d’activation.

Pour qu’un réseau apprenne bien avec l’algorithme standard de rétropropagation, sa fonction d’activation doit être différenciable. Dans le monde complexe, cette propriété est appelée être holomorphe. Mais comme nous le dit le théorème de Liouville de l’analyse complexe, toute fonction à la fois holomorphe et délimitée sur l’ensemble du plan complexe doit être une constante.

Cela crée un paradoxe:

- Nous voulons bordé fonctions (comme

tanhsur la ligne réelle) pour garder notre réseau stable. - Nous voulons holomorphe Fonctions pour une formation efficace et bien élevée.

Nous ne pouvons pas avoir les deux parfaitement, le tanh La fonction est délimitée sur l’axe réel mais devient singulier et non différentiable à ses pôles sur l’axe imaginaire. Ce compromis fondamental exige la nécessité de fonctions d’activation spécialisées.

La fin

Nous avons donc commencé avec une question simple sur une fonction familière. En osant quitter la ligne numérique réelle, nous avons constaté que l’écurie tanh La fonction détient un alter-ego caché et périodique. Cette découverte n’était pas seulement une curiosité mathématique; C’était une clé conceptuelle qui a déverrouillé la porte à un sous-champ entier de l’IA.

Les réseaux de neurones à valeur complexe nous montrent qu’il y a encore de nouvelles dimensions à explorer dans l’IA. Ils nous rappellent que les fondements mathématiques de l’apprentissage en profondeur sont profonds, riches et parfois étonnamment élégants. La prochaine fois que vous verrez un tanh ou ReLUFonction dans une ligne de code, rappelez-vous l’histoire qu’elle raconte – une histoire de stabilité, de volatilité cachée et du puissant potentiel de pensée en nombres complexes.

Ce que nous savons, c’est qu’il y a une tension constante entre la nécessité de fonctions non linéaires et limitées et les exigences strictes du calcul complexe. Je sais que ce n’est pas une belle fin à cette pensée, et devinez quoi, nous n’avons pas de fonction d’activation à faire ML dans l’espace complexe!

~ Ashutosh