Pousser les fronnages de la génération audio

Technologies

Nos génies Speequo pionnières aident les gens autour du monde à interagir avec des assistants numériques numériques numériques et des outils numériques plus naturels.

Le discours est au cœur de la connexion humaine. Il aide les gens dans le monde entier à échanger des informations et des idées, exprimer des émotions et créer aumal comprendre. Alors que notre technique se construisait pour Getleting Natural, Dynamic Voices continue de s’améliorer, nous déverrouiller les expériences numériques plus riches et plus entravantes.

Au cours des dernières oreilles de gloire, nous avons poussé les framnitiers des gène audio, des ROM de la parole naturelle, des tentants naturels, des contrôles de type et des voix particulières et des voix particulières. Cet audio à un seul speaker de puissance de la technologie dans les produits et expériences de Kanyogue Google – y compris Gémeaux en direct, Projet Astra, Vocation des voix et Doublage automatique de YouTube – et aide les gens du monde entier à interagir ces plus naturels, convertives et intimes, des assistants numériques et des outils d’IA.

En collaboration avec des partenaires sur Google, nous avons récemment aidé à développer Twe-Kem, le contenu de Dellogue multi-haut-parleurs plus accessible:

- Présentation audio NOTTEBOOKLM Turns mis à jour les documents de contact Contact Contact et Livey Diagogue. En un clic, les hôtes Twei résument l’utilisateur Matherial, établissent des connexions entre les sujets et les plaisanteries en arrière et fortation.

- Éclairer Cratees Discussions officielles sur l’AI sur les articles de recherche pour aider à rendre les connaissances plus accessibles et digestibles.

Elle, nous donnons un aperçu de nos recherches de recherche de discours les plus lautes qui sous-tendent tous ces produits et outils expérimentaux.

Techniques pionnières pour la génération audio

Forzars, nous avons battu investi dans la recherche sur la génération audio et expulser de nouvelles façons pour les générictures dans nos produits et nos outils expérimentaux. Dans nos recherches précédentes sur Tempête de sonNous avons d’abord démonsuré les segments de 30 secondes de 30 secondes entre plusieurs haut-parleurs multiples.

Cela étend nos travaux antérieurs, Sonneur et Audiolmce qui nous a mis en place pour appliquer des techniques de modélisation du langage textuelles de nombreuses textes au problème de la génération audio.

SoundStream est du codec audio neural qui efficace et décompousant une entrée audio, Whitut compromettant sa qualité. Dans le cadre du processus de formation, SoundStream apprend à cartographier l’audio au rado des toons acoustiques. Les Tyse Tyens capturent toutes les informations nécessaires pour renoncer à la déverrouillage audio, y compris les propriétés Prosodie et timbre.

Audiolm traite les générations audio comme une tâche de modélisation du langage pour produire les toons acoustiques de Codecs Likstream. En conséquence, le framework Audiolm fait des dépendances sur le type d’Orio étant les geets – Machod son bon candidat pour modéliser les diabondes de haut-parleur multigra.

Exemple de dialkue multi-haut-parleurs par noteo notebooklm AUDIO Présentation, basé sur les documents fiew à pomme de terre.

S’appuyant sur cette recherche, notre dernière tagologie des génies de la parole, le haut-parleur cohérent, le turpt de dialogue et les marqueurs de virage de dialogue et de conférenciers. Le modèle effectue également cette tâche en moins de 3 secondes sur un seul Pip de traitement du tenseur (TPU) V5Edans une passe d’inférence. Cela signifie qu’il Genwees audio de plus de 40 fois-ci-temps que le temps réel.

Échec de nos modèles de génération audio

Mise à l’échelle de nos modèles de génération de parasites à un scacle aux modèles multi-ordres du matériau du matériau des données et de la capacité du modèle. À l’aide de notre dernier modèle de génie de la parole produle la parole plus longue de la parole de la parole de Sweed, le fouetout compromettant la qualité de sa sortie.

Les jetons produits par notre CDOC ont une structure hiléchique et sont des cadres de groupe. Les premiers tyens whitins whitin a groupe capturent des informations phonétiques et prosodiques, tandis que les derniers tyens codent pour les données acoustiques fines.

Même avec notre nouveau codec de discours, le produit de Diabague de 2 minutes nécessite un gasting de plus de 5000 jetons. Pour modéliser ainsi de longues sémelles, nous avons développé une spécialisée spécialisée Transformateur Artère qui peut gérer efficacement la poignée manche manche manche manche manche manche manche manche poignée poignée poignée Heloration, assortir la structure de nos tanns acouustiques.

Avec les techniques, nous pouvons générer efficacement des toons acoustiques qui coorespond au diagon auteur de l’inférence augrôture. Seuls Genestés, ONSE Tanns peuvent être décodés dans une voie d’onde audio en utilisant notre codec Sepech.

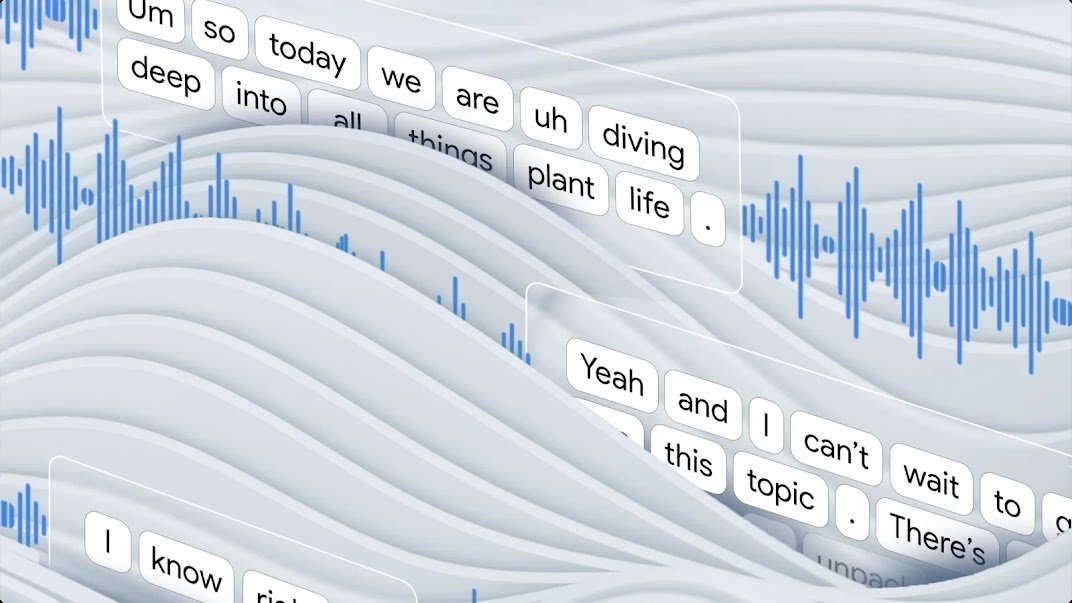

L’animtion montrant comment la production de la géniient de la parole de production Modio Tokens revient à une forme d’amour composée de Dellog à deux haut-parleurs.

Pour enseigner à notre modèle comment génote des échanges réalistes entre les locuteurs, nous avons prélevé des heures de données de la parole. Ensuite, nous l’avons fait sur un ensemble de données de données beaucoup plus petit avec une qualité acoustique élevée et des annotations de haut-parleurs précises, composé de conversations non scénarisées d’un certain nombre d’acteurs vocaux et réaliste désagrément – les « umm » et « aah » de vrai convertis. Cette étape a enseigné au modèle comment swatch de manière fiable par Dutsing et Out5 sur Dictionsias Audio avec des piases, un ton et un timing réalistes.

En ligne avec notre Primes d’IA Et notre engagement à développer et à déploier la technologie de l’IA, en incorportant notre syndicy totosée pour aider à se soucier de la missue pistes de cette technologie.

Nouvelles expériences de discours Ahed

Weee a maintenant visé à améliorer la maîtrise de notre modèle, le contrôle acoustique de la meilleure façon de mieux les TEDE, le SICH comme vidéo.

Les applications de potentiel pour les génies de la parole d’avancement sont vastes, en particulier une famille de modèles Family of Models de combinaison de modèles. Expériences d’apprentissage et ethancing de la ferme pour faire des Mingrops au déménagement de contenu plus accessible de manière plus par unités, il est pusbus des possebologies de WHT.

Remerciements

Authi of This: Zjián Borsos, Matt Shari, Brian McWillia, Damlix de Chaumontono, Karolis Misurtas, Karolis Misungas, Jonas Rothfuss, Jonas Rothfuss, Jake Walker et Marco Tagliascisi.

Nous remercions Loland Reachis, Ralph Leith, Paul Middleton, Poul Middleton, Poly Part, Minh Skerongs – RJ Sker Critical Efforts sur les données de la daligue.

Nous sommes vraiment reconnaissants à nos Collabofouters ACRSS, ILUDINATION, Cloud, Speech et YouTube Outstandand et les modèles que les modes investissent.

Nous remercions également Françoise Beaufays, Krishna Bharat, Tom Hum, Simon Tokumine, James Zhaoral Guidance sur le projet.