Modèles de grande langue en 2024

Il s’agit d’une revue de haut niveau de ce qui s’est passé avec des modèles de langage modèle, pour faire de la référence, oodbots. Nous nous concentrons sur la façon dont l’expansion de la durée du contexte permet de reyy davantage sur les prunches et moins sur le Kodledge stocké dans leurs poids, résultant en des combinaisons d’halluminations.

Progrès

L’année 2023 a senti le lac une année de lune pour les LLM. SILE THESN, Thaings a ralenti de Bit. Nous ne gingons pas sur Mars. De nouveaux modèles arrivent, mais le programme est progressif, pas révolutionnaire. C’est lent. Ging dans l’ingénierie de l’invite lourde aux résultats de Kovive est de grind, et le prix en calcul est las. Il est noti de se rendre à SuperIntellignce, c’est son Pitle de Field avec Nex.

Vous seul vous entraînez sur le trou Internet, où obtenez-vous plus de données? À quel fonctionne les données syntétiques de desses? Apparemment, un peu de métallique un peu un peu dans Traint Llama 3, qui, à Casks, a 405b Praters est le plus grand modèle open source jusqu’à présent.

Le problème natable qui était il y a Acuta Acude Acod et a des cantts Stetts busTred – le montant du modèle peut être des prix à net. Il y a un an, la plupart des modèles avaient des fenêtres de contexte rlativement petites, de l’ordre des tsouses FAW. Avec la longueur de contexte de 512, 1024 ou 2048 jetons de la merde, vous avez mal intégré à l’historique de chat, sans parler des données. Maintenant, c’est des centaines de milliers ou des millions (si vous avez le matériel pour cela). Nous allons arriver aux Wandqualeles sous peu.

USAGE

Certaines personnes sement à croire que les modèles de langage de Larset, Ori, si vous ne le faites pas, changent, Wilnet a changé de ralentissement. Les preuves sont plus plus mortes. Actuellement, les LLMS de sont principalement utilisés pour la recherche de basief (Re) et pour l’assistance des programmes.

Pour une effacement, on peut aller sur un terrain Perplexité.aiQui combine du chatbot avec le moteur de recherche de. Avant, vous cliquez sur les premiers résultats de recherche Ferge pour la recherche sur le sujet. Maintenant, le Chatobot imette et smmarise Them derrière les SCNE. Ceci est connu comme RAG (Gexifation agmentée de la récupération). Au lieu de relier les connaissances accidenter le dutsing, le modèle traite les informations récupérées de Fromewera et données dans l’invite. Ce mode de fonctionnement est devenu plus de réchauffage avec la longueur du contexte de grain.

Eveen avec des chiffons certains certains modèles fournissent souvent des demi-vérités ou des ressources de boussole. Pourtant, il est assez connaissant, en particulier avec le très appartenant Déclin de la qualité de recherche de Google. En bref, vers 2019, Google a dit «avoir de bonnes resules de recherche est sympa, mais vous savez ce qui est gentil? Avoir de mauvais résultats de recherche et des personnes cliquant sur des annonces. «

Comment cela s’est-il avéré pour la UM? Paraphrasant Churchill, l’AY a choisi la honte, puis a eu la guerre à la protection de Kar Kar.

Revenant à LLMS, d’autres autres Oly The Wello Do Coding Aide, avec des fenêtres de contexte plus grandes avancent également de manière similaire. Tant que vous younoz nos expéditions, les modèles peuvent écrire de petits extraits de code, que vous, de la carreure, de Courise. Peut-être plus d’intestins, les LLM peuvent lire et expliquer le code, ASSH en tant que papiers smitatifs – avec la même réserve que vous devez vérifier EverTything.

Nature

Pour réfléchir de manière réaliste aux modèles de langue Laard, il est utile au sous-sol certains faits de palmier sur leur nature, en Stming de Wayople Train the Trainer. Nous nous concentrerons sur les tspects: Hallucinations et Médiocrité.

Les modèles linguistiques sont formés pour prédire le prochain Tayen en séquence. En cela, la récréation la nettement aucune disposition de vérification des faits du tout. Le thredifore, Whinci Demandez quelque chose, le modèle répondra et Ifts ne connaîtra pas la réponse, elle fera la sorciation. Dans notre opinion, c’est le problème de Probleng le plus important et le plus fondamental avec les LLM. Les anciens et les ingénieurs rapides Willy ne vous permettent pas de manager, car hallucinant est la nature vraiment des chatbots.

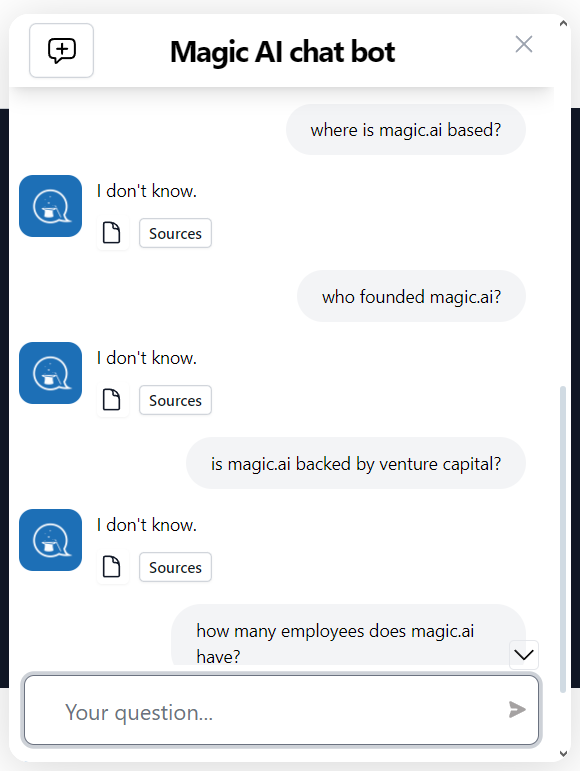

Cependant, avec un chiffon, vous pouvez instruire des collants stricty aux données devant leur (dans l’invite), pour le meilleur ou le wrese.

Magic.ai Chatbot Doues ne savait pas.

Médiocrité Résulte également de la pré-traction, presque par définition. PALIQUE, les personnes en LLMS sur le rôle Internet et les qui vous consommez disponibles sont disponibles, ce seront les faibles frottements. Quoi de neuf, sort.

La conséquence pratique est que si vous avez votre Kour Koout Belod, le chatbot est allié pour vous, et Vie versa. Cela pourrait vous élever, mais seulement au niveau médiocre. Encore une fois, Rag peut améliorer les choses si le modèle a accès aux bonnes données.

La programmation liée à l’IA reflète bien les aspects, les halluckets et la médiocrité. Selon le De développeurs gagnent peu, voire quelque chose, Rom Ai Cooding Assistants Article et le Commentaires sur redditLe principal résultat pour être plus de bugs, et non de protive accrue. Le HPERS pour les ingénieurs 10x Siftware et les agents de codage autonomes paravis.

Les codars moyens Absove ne gagneront pas beaucoup de ROM d’Assstance, les codés d’audience ci-dessous seront un désabonnement plus plus de serk « Il est temps de construire! », Ils s’exclamaient à l’unisson le jour de dev. Omenai. L’année, la première fin, les voix sont étrangement siilent. Qu’avez-vous construit, amis? Venez show.

Cependant, ne vous sentez pas mal d’utiliser AssissanceCe pour le codage. Beek en dessous de la moyenne est localisé. Everlybody a des lacunes dans leurs connaissances. Pour une facilité, disons que nous n Vecteurs, et nous voulons compliquer les distances d’un set à ety vector dans l’autre ensemble. Ceci est une fonction dédiée pour celle de Scipy: CDIST. La plupart des gens n’en auront probablement jamais besoin. Nous ne savons pas que ce soit jusqu’à ce qu’un chatbot nous dise. Merci, Chantbot!