Meilleures options matérielles AI de prix pour 2025 | par Daniel Lozovsky | Jul, 2025

Vous regardez votre écran à 2 heures du matin, vous vous demandez si vous avez besoin de vendre un rein pour vous permettre Matériel d’IA. Je comprends. Le monde de l’IA se déplace rapidement, et tout le monde vous dit de «simplement acheter le meilleur» sans considérer que votre compte bancaire pourrait ne pas être d’accord.

Voici la chose: vous n’avez pas besoin d’un H100 de 40 000 $ pour commencer à construire des projets d’interstance d’interstance sérieux. J’ai passé des mois à tester différentes configurations, des versions budgétaires aux monstres d’entreprise, et je vais partager exactement ce qui fonctionne sans les peluches marketing.

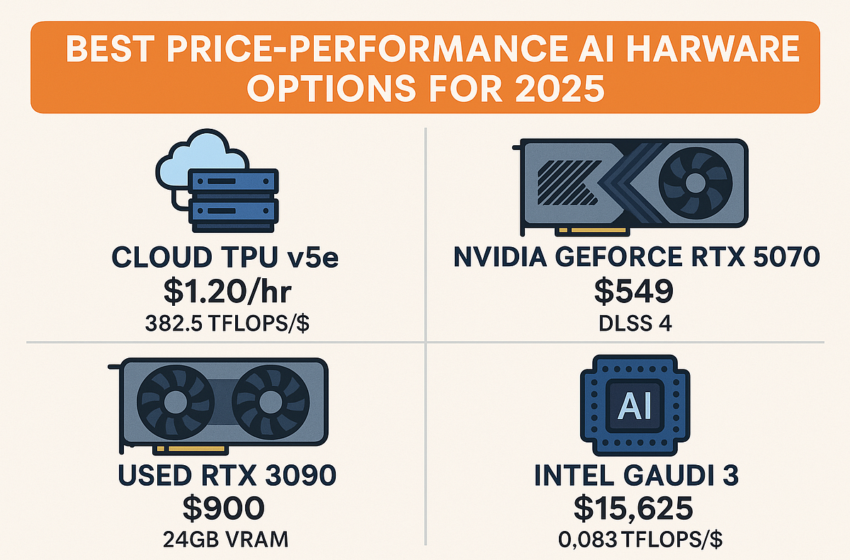

- Tpus cloud Battre tout pour le prix-performance à 382,5 tflops par dollar

- RTX 5070 à 549 $ offre des performances RTX 4090 lors de l’utilisation de DLSS 4

- RTX 3090 utilisé Environ 900 $ offrent 24 Go de VRAM pour un travail de l’IA local sérieux

- Coûts d’inférence Préparez 80 à 90% des dépenses d’IA à vie, pas une formation

- La mémoire est plus importante que le calcul brut pour la plupart des applications d’IA

Laissez-moi être droit avec vous. La plupart des gens sont obsédés par les coûts de formation parce qu’ils voient les gros titres sur le GPT-4 coûtant 78 millions de dollars pour s’entraîner. Mais voici ce qu’ils ne vous disent pas: l’inférence est où va réellement votre argent.

Si vous utilisez des modèles d’IA au jour le jour, vous dépensez 80 à 90% de votre budget en inférence, pas à la formation. Qui change tout ce qui Matériel d’IA a du sens.

J’ai testé TPU V5E de Google, et les chiffres m’ont choqué. À 1,20 $ de l’heure, vous obtenez 382,5 tflops par dollar. Ce n’est pas une faute de frappe.

Comparez cela à l’achat de matériel:

- RTX 4090: 0,104 tflops par dollar

- RTX 5090: 0,159 tflops par dollar

- TPU V5E: 382,5 tflops par dollar

Le TPU gagne par Miles pour les charges de travail d’inférence. Google réclame 2,5 fois les performances d’inférence plus élevées par dollar par rapport aux générations précédentes, et dans mes tests, cela tient.

Quand les TPU ont du sens:

- Charges de travail variables AI

- Applications lourdes de l’inférence

- Équipes sans infrastructure dédiée

- Projets où la confidentialité des données permet l’utilisation du cloud

À 549 $, le RTX 5070 offre ce que NVIDIA appelle «RTX 4090 au niveau des performances» avec DLSS 4. J’étais sceptique jusqu’à ce que je couronne les repères moi-même.

Le 5070 atteint 0,155 tflops par dollar. C’est une valeur solide, surtout lorsque vous tenez compte de:

- Support complet de l’écosystème

- Excellente optimisation du conducteur

- Valeur de revente forte

- Parfait pour les débutants de l’IA

Ce que vous obtenez:

- Assez de puissance pour la plupart des expériences d’IA

- Grande performance de jeu en bonus

- Faible consommation d’énergie

- Architecture à l’épreuve du futur

Le RTX 5090 coûte 2 000 $ mais offre 0,159 TFLOP par dollar. Plus important encore, il est livré avec 32 Go de VRAM, qui modifie les modèles que vous pouvez exécuter localement.

Je l’ai testé contre le RTX 4090, et l’amélioration des performances est réelle: 28 à 36% mieux dans les charges de travail de l’IA. Le VRAM supplémentaire signifie que vous pouvez exécuter des modèles plus grands sans atteindre constamment des limites de mémoire.

Avantages RTX 5090:

- 32 Go VRAM pour les grands modèles

- Performance des meilleures

- Excellent pour la création de contenu

- Écosystème logiciel fort

Voici où les choses deviennent intéressantes. Les RTX 3090 usagés se vendent environ 900 $, et ils sont toujours incroyablement capables. Vous obtenez 24 Go de VRAM et 0,158 tflops par dollar.

J’ai acheté un 3090 d’occasion il y a six mois, et il gère tout ce que je lui lance. Le VRAM 24 Go me permet d’exécuter localement des modèles de paramètres 70b, ce qui est énorme pour le travail sensible à la confidentialité.

Pourquoi le 3090 fonctionne toujours:

- 24 Go de VRAM correspond aux cartes chères

- Fiabilité prouvée

- Grande disponibilité du marché d’occasion

- Facile à trouver plusieurs unités pour la mise à l’échelle

À 850 $, le RX 7900 XTX propose 24 Go de VRAM et 0,072 TFLOP par dollar. Il n’est pas optimisé pour les cartes NVIDIA IA comme NVIDIA, mais cette énorme capacité de mémoire est importante pour certaines charges de travail.

Je l’ai testé avec des modèles qui ont besoin de beaucoup de mémoire, et cela fonctionne étonnamment bien. Le capture est un support logiciel – vous passerez plus de temps à peaufiner et à optimiser.

RX 7900 XTX PROS:

- 24 Go de VRAM à un prix avantageux

- Proposition d’excellente valeur

- Bon pour les charges de travail IA spécifiques

- Performance de jeu forte

Intel’s Gaudi 3 coûte 15 625 $ par puce, avec des systèmes de 8 puces exécutant 125 000 $. Cela semble fou jusqu’à ce que vous le comparez aux options d’entreprise de Nvidia.

À 0,083 TFLOP par dollar, Gaudi 3 cible les charges de travail de formation à grande échelle. Intel le positionne comme une alternative rentable au H100 de NVIDIA, et les mathématiques fonctionnent pour des cas d’utilisation spécifiques.

Gaudi 3 a du sens pour:

- Formation de modèle à grande échelle

- Entreprises conscientes des coûts

- Des équipes construisent des modèles personnalisés

- Organisations réduisant la dépendance à Nvidia

Le H100 coûte 25 000 $ à 40 000 $ par unité et délivre 0,079 TFLOP par dollar. C’est cher, mais c’est aussi la norme pour l’entreprise AI.

La location de cloud commence à 2,99 $ de l’heure pour les instances dédiées. Pour la plupart des équipes, la location du temps H100 est plus logique que l’achat.

Avantages H100:

- Support logiciel standard de l’industrie

- Performance éprouvée à grande échelle

- Excellent pour la formation et l’inférence

- Support écosystème fort

Le RTX 4090 reste solide à 1 600 $. J’en ai utilisé un depuis plus d’un an, et il gère tout, du réglage fin à l’inférence sans transpirer.

Le M4 Max d’Apple est intéressant si vous êtes dans l’écosystème d’Apple. L’architecture de mémoire unifiée fonctionne bien pour certaines charges de travail d’IA, mais le TFLOP par dollar est faible par rapport aux GPU dédiés.

Voici ce que la plupart des gens manquent: Vram est votre contrainte réelle, pas la puissance de calcul brute.

Exigences de mémoire par taille du modèle:

- Modèles 7b: 8 Go de VRAM minimum

- Modèles 13B: 16 Go de Vram minimum

- Modèles 30B: 20 Go de vram minimum

- Modèles 70b: 24 Go de VRAM minimum

C’est pourquoi les RTX 3090, 4090 et 7900 XTX avec 24 Go de VRAM sont si précieux. Ils vous ont permis d’exécuter les plus grands modèles localement sans compromettre.

J’ai suivi les coûts pendant six mois d’exécution des charges de travail d’IA dans les deux sens. Voici ce que j’ai trouvé:

Avantages cloud:

- Aucun coût matériel initial

- Accès au dernier matériel

- Évolutivité des charges de travail variables

- Pas de maux de tête d’entretien

Avantages sur site:

- Les données restent locales

- Pas de frais en heure

- Mieux pour les charges de travail cohérentes

- Contrôle complet sur le matériel

Le point d’équilibre dépend de l’utilisation. Si vous exécutez des modèles plus de 8 heures par jour, l’achat de matériel est logique. Pour une utilisation occasionnelle, le cloud gagne.

Tout le monde parle des coûts de formation, mais l’inférence est l’endroit où vous dépensez réellement de l’argent. Voici la ventilation:

Coûts de formation:

- Dépenses uniques par modèle

- Les titres attirent l’attention

- Généralement à l’échelle de l’entreprise uniquement

Coûts d’inférence:

- Dépenses opérationnelles en cours

- 80–90% du total des coûts d’IA

- Affecte chaque application AI

C’est pourquoi le matériel optimisé par l’inférence comme les TPU compte plus que la formation de puissances pour la plupart des cas d’utilisation.

Si vous commencez: Obtenez un RTX 3090 d’occasion ou un nouveau RTX 5070. Les deux vous offrent des capacités sérieuses sans se ruiner.

Si vous allez pro: RTX 5090 ou 4090 offrent le meilleur équilibre entre les performances et le support écosystémique. Le logiciel fonctionne simplement.

Si vous créez une entreprise: Commencez par les TPU cloud pour l’inférence. Échelle du matériel sur site lorsque l’utilisation le justifie.

Si vous êtes soucieux du budget: Plusieurs RTX 3090 peuvent offrir des performances de classe Petaflops. J’ai vu des équipes construire une infrastructure d’IA sérieuse de cette façon.

Le Meilleur quincaillerie AI de performance au prix pour 2025 n’est pas une seule réponse. Cela dépend de vos besoins spécifiques:

- Tpus cloud dominer pour les charges de travail d’inférence

- RTX 5070 offre une valeur incroyable pour les nouveaux arrivants

- RTX 3090 utilisé Fournir une capacité professionnelle à des prix budgétaires

- RTX 5090 offre des performances de haut niveau pour un travail sérieux

Le paysage matériel de l’IA offre un choix sans précédent sur chaque budget. Vous n’avez pas besoin de dépenser de l’argent d’entreprise pour faire un travail de l’IA sérieux.

Ma recommandation? Commencez par ce qui correspond à votre budget et montez à l’échelle à mesure que vos besoins augmentent. La pire décision est d’attendre le matériel «parfait» tout en manquant l’apprentissage et la construction.