Les modèles Frontier AI sont perplexes par un simple jeu pour enfants

Plus tôt cette semaine, des chercheurs d’Apple libéré un accablé papiercritiquant l’industrie de l’IA pour surestimer largement la capacité de ses meilleurs modèles d’IA à raisonner ou à «penser».

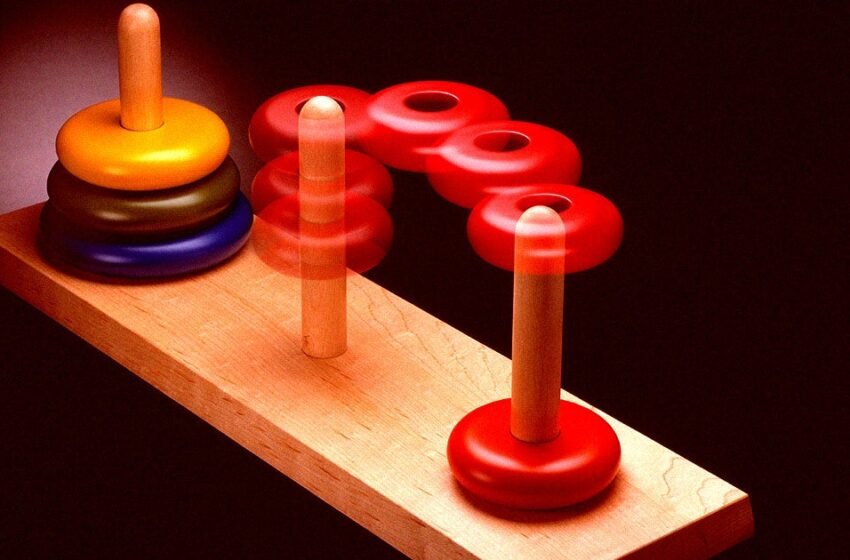

L’équipe a constaté que les modèles, notamment O3 d’Openai, Claude 3.7 d’Anthropic et les Gémeaux de Google ont été perplexes même par les puzzles les plus simples. Par exemple, les «grands modèles de raisonnement» ou les LRM, ont constamment échoué à Tower of Hanoi, un jeu de puzzle pour enfants qui implique trois chevilles et un certain nombre de disques de taille différemment qui doivent être organisés dans un ordre spécifique.

Les chercheurs ont constaté que la précision des modèles d’IA dans le jeu était inférieure à 80% avec sept disques et était plus ou moins entièrement perplexe par des puzzles impliquant huit disques.

Ils ont également constamment échoué à Blocks World, un puzzle d’empilement de blocs et River Crossing, un puzzle qui implique de déplacer des objets à travers une rivière à l’aide d’un bateau avec plusieurs contraintes.

« Grâce à une expérimentation approfondie à travers divers puzzles, nous montrons que la frontière (grands modèles de raisonnement) est confrontée à un effondrement complet de précision au-delà de certaines complexités », ont écrit les chercheurs d’Apple.

Ce fut une découverte de sourcils, soulignant à quel point les modèles les plus sophistiqués des IA ne parviennent toujours pas à se frayer un chemin à travers des puzzles simples, bien qu’ils soient faits pour être quelque chose de bien plus sophistiqué par le marketing à bout de souffle de leurs fabricants.

Ces approches pour vendre la technologie au public ont conduit les utilisateurs anthropomorphisation des modèles d’IA – ou penser à eux comme des humains – conduisant à un schisme majeur entre leurs capacités présumées et réelles.

Les résultats amplifient peurs en cours Ces approches actuelles de l’IA, y compris les modèles d’IA « de raisonnement » qui décomposent les tâches en étapes individuelles, sont une impasse, malgré des milliards de dollars versés dans leur développement.

Pire encore, passant un seuil de complexité, leurs lacunes deviennent encore plus apparentes, sous-évaluant les promesses de l’industrie de l’IA qui, la simple mise à l’échelle des données de formation des modèles, pourrait les rendre plus intelligents et capables de «raisonnement».

Le critique de l’IA, Gary Marcus, n’a pas été surpris par les résultats des chercheurs.

« À bien des égards, le papier fait écho et amplifie un argument que je fais depuis 1998 », a-t-il écrit dans un Post récent sur sa substitutionse référant à un papier Il est écrit il y a plus de 26 ans. « Les réseaux de neurones de divers types peuvent généraliser dans une distribution des données auxquelles ils sont exposés, mais leurs généralisations ont tendance à se décomposer au-delà de cette distribution. »

En bref, être perplexe par des jeux pour enfants simples n’est pas exactement ce que vous attendez des modèles d’IA vendus comme la prochaine percée en résolution de problèmes et un pas vers le général artificiel – ou surhumain – l’intelligence (AGI), le Objectif déclaré d’Openai.

« Il ne s’agit pas seulement de » résoudre « le puzzle », a déclaré à Marcus l’auteur Colead et ingénieur d’apprentissage automatique Apple Iman Mirzadeh. « Nous avons une expérience où nous donnons l’algorithme de solution au modèle, et (le modèle a toujours échoué) … en fonction de ce que nous observons de leurs pensées, leur processus n’est pas logique et intelligent. »

Marcus soutient que les modèles de langue et de raisonnement en grande partie jettent simplement un filet beaucoup trop large et se perdent facilement en conséquence.

« Ce que le journal Apple montre, le plus fondamentalement, quelle que soit la façon dont vous définissez AGI, c’est que ces LLM qui ont généré autant de battage médiatique ne remplacent pas de bons algorithmes conventionnels bien spécifiés », a-t-il écrit.

« Ce que cela signifie pour les affaires, c’est que vous ne pouvez pas simplement laisser tomber (Openai’s LLM) O3 ou Claude dans un problème complexe et vous attendre à ce qu’ils travaillent de manière fiable », a ajouté le critique. « Ce que cela signifie pour la société, c’est que nous ne pouvons jamais faire pleinement confiance en AI générative; ses résultats sont tout simplement trop apparentés. »

Alors que de nombreux cas d’utilisation valables pour les modèles restent, « toute personne qui pense que les LLM sont une voie directe vers le type AGI qui pourrait fondamentalement transformer la société pour le bien eux-mêmes », a conclu Marcus.

Plus sur le papier: Les chercheurs d’Apple viennent de publier un papier accablant qui verse de l’eau froide sur toute l’industrie de l’IA