Les menaces d’IA dans le développement de logiciels révélées dans une nouvelle étude

Un exemple d’un modèle grand langage. Les chercheurs de l’UTSA ont récemment terminé l’une des études les plus complètes à ce jour sur les risques d’utiliser des modèles d’IA pour développer des logiciels. Dans un nouvel article, ils montrent comment un type d’erreur spécifique pourrait constituer une menace sérieuse pour les programmeurs qui utilisent l’IA pour aider à rédiger du code. Crédit: l’Université du Texas à San Antonio

Les chercheurs de l’UTSA ont récemment terminé l’une des études les plus complètes à ce jour sur les risques d’utiliser des modèles d’IA pour développer des logiciels. Dans un nouvel article, ils montrent comment un type d’erreur spécifique pourrait constituer une menace sérieuse pour les programmeurs qui utilisent l’IA pour aider à rédiger du code.

Joe Spracklen, un doctorant de l’UTSA en informatique, a dirigé l’étude sur la façon dont Modèles de grande langue (LLMS) génèrent fréquemment du code non sécurisé.

Le papier de son équipe, publié sur arxiv Un serveur préparatoire, a également été accepté pour publication au Usenix Security Symposium 2025une conférence de cybersécurité et de confidentialité.

La collaboration multi-institutionnelle comprenait trois autres chercheurs de l’UTSA: l’étudiant doctoral Ahm Nazmus Sakib, le chercheur postdoctoral Raveen Wijewickrama, et le professeur agrégé Dr Murtuza Jadliwala, directeur du SpriteLab (Security, Privacy, Trust et Ethics in Computing Research Lab).

Des collaborateurs supplémentaires étaient Anindya Maita de l’Université d’Oklahoma (ancien chercheur postdoctoral de l’UTSA) et Bimal Viswanath de Virginia Tech.

Les hallucinations dans les LLM se produisent lorsque le modèle produit un contenu qui est en fait incorrect, absurde ou complètement sans rapport avec la tâche d’entrée. Jusqu’à présent, la plupart des recherches se sont concentrées principalement sur les hallucinations dans les tâches classiques de génération de langage naturel et de prédiction telles que la traduction automatique, le résumé et l’IA conversationnelle.

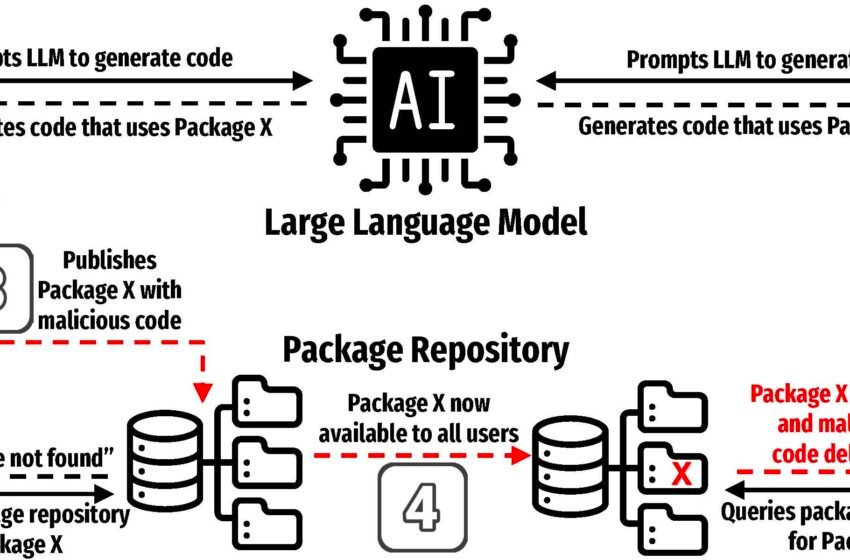

L’équipe de recherche s’est concentrée sur le phénomène de l’hallucination du package, qui se produit lorsqu’un LLM génère ou recommande l’utilisation d’une bibliothèque de logiciels tiers qui n’existe pas réellement.

Ce qui fait de l’emballage des hallucinations un domaine de recherche fascinant, c’est comment quelque chose de si simple – une commande unique et quotidienne – peut entraîner de sérieux risques de sécurité.

« Il ne faut pas un ensemble de circonstances alambiqué ou quelque chose de obscur », a déclaré Spracklen. « C’est juste taper un commandement que la plupart des gens qui travaillent dans ces langages de programmation tapent tous les jours. C’est tout ce qu’il faut. C’est très direct et très simple. »

« C’est aussi omniprésent », a-t-il ajouté. « Vous pouvez faire très peu avec votre langage de codage Python de base. Il vous faudrait beaucoup de temps pour écrire le code vous-même, il est donc universel de compter sur logiciel open source Pour étendre les capacités de votre langage de programmation pour accomplir des tâches spécifiques. «

Les LLM sont de plus en plus populaires auprès des développeurs, qui utilisent les modèles d’IA pour aider à assembler des programmes.

Selon l’étude, jusqu’à 97% des développeurs de logiciels intègrent une IA générative dans leur flux de travail, et 30% du code écrit aujourd’hui est généré par l’AI.

De plus, de nombreux langages de programmation populaires, comme PYPI pour Python et NPM pour JavaScript, comptent sur l’utilisation d’un référentiel de package centralisé. Parce que les référentiels sont souvent open source, les mauvais acteurs peuvent télécharger du code malveillant déguisé en packages légitimes.

Pendant des années, les attaquants ont utilisé diverses astuces pour amener les utilisateurs à installer leurs logiciels malveillants. Les hallucinations de forfait sont la dernière tactique.

« Alors, disons que je demande à Chatgpt d’aider à écrire du code pour moi et qu’il l’écrit. Maintenant, disons que dans le code généré, il comprend un lien vers un package, et je lui fais confiance et exécutez le code, mais que le package n’existe pas, c’est un package halluciné. Un adversaire / hacker astucieux pourrait voir ce comportement (de la LLM) et réalise que le LLM est des gens à utiliser ce non-package, » ce package hallucin Jadliwala a expliqué.

« L’adversaire peut alors simplement créer un nouveau package avec le même nom que le package halluciné (recommandé par le LLM) et y injecter un mauvais code.

« Maintenant, la prochaine fois que le LLM recommande le même package dans le code généré et qu’un utilisateur sans méfiance exécute le code, ce package malveillant est maintenant téléchargé et exécuté sur la machine de l’utilisateur. »

Les chercheurs de l’UTSA ont évalué la survenue d’hallucinations de package dans différents langages de programmation, paramètres et paramètres, explorant la probabilité de recommandations de package erronées et identifiant les causes profondes.

À travers 30 tests différents effectués par les chercheurs de l’UTSA, 440 445 des 2,23 millions d’échantillons de code qu’ils ont générés dans Python et JavaScript à l’aide de modèles LLM ont référencé des packages hallucinés.

Parmi les chercheurs du LLMS testés, « les modèles de la série GPT ont été trouvés quatre fois moins susceptibles de générer des forfaits hallucinés par rapport aux modèles open source, avec un taux d’hallucination de 5,2% par rapport à 21,7% », a indiqué l’étude. Le code Python était moins sensible aux hallucinations que JavaScript, ont révélé des chercheurs.

Ces attaques impliquent souvent de nommer un paquet malveillant pour imiter un légitime, une tactique connue sous le nom d’attaque de confusion de package. Dans une attaque d’hallucination de package, un utilisateur LLM sans méfiance serait recommandé que le package dans son code généré, et en faisant confiance au LLM, téléchargeraient le package malveillant créé par les adversaires, entraînant un compromis.

L’élément insidieux de cette vulnérabilité est qu’il exploite la confiance croissante dans les LLM. Alors qu’ils continuent de devenir plus compétents dans les tâches de codage, les utilisateurs seront plus susceptibles de faire aveugle leur production et potentiellement être victimes de cette attaque.

« Si vous codez beaucoup, il n’est pas difficile de voir comment cela se produit. Nous avons parlé à beaucoup de gens et presque tout le monde dit qu’ils ont remarqué qu’une hallucination de paquet leur arrive pendant qu’ils codaient, mais ils n’ont jamais réfléchi à la façon dont cela pouvait être utilisé avec malveillance », a expliqué Spracklen.

« Vous placez beaucoup de confiance implicite sur l’éditeur de packages que le code qu’ils ont partagé est légitime et non malveillant. Mais chaque fois que vous téléchargez un package, vous téléchargez potentiellement code malveillant et lui donner un accès complet à votre machine. «

Bien que les packages générés par une référence avec une liste principale puissent aider à atténuer les hallucinations, les chercheurs de l’UTSA ont déclaré que la meilleure solution était de répondre aux bases des LLM pendant son propre développement. L’équipe a divulgué ses résultats aux fournisseurs de modèles, notamment Openai, Meta, Deepseek et Mistral IA.

Plus d’informations:

Joseph Spracklen et al, nous avons un package pour vous! Une analyse complète des hallucinations de paquets par le code générant des LLM, arxiv (2024). Doi: 10.48550 / arxiv.2406.10279

Fourni par

Université du Texas à San Antonio

Citation: Les menaces de l’IA dans le développement de logiciels révélées dans une nouvelle étude (2025, 8 avril) récupérée le 8 avril 2025 à partir de https://techxplore.com/news/2025-04-ai-threats-software-revealed.html

Ce document est soumis au droit d’auteur. Outre toute émission équitable aux fins d’études privées ou de recherche, aucune pièce ne peut être reproduite sans l’autorisation écrite. Le contenu est fourni uniquement à des fins d’information.