Le nouveau système de vision du MIT CSAIL aide les robots à comprendre leur corps

« Ce travail indique un passage des robots de programmation aux robots enseignants », a déclaré Sizhe Lester Li, chercheur principal et doctorat. Étudiant au MIT CSAIL. «Aujourd’hui, de nombreuses tâches robotiques nécessitent une ingénierie et un codage étendus. À l’avenir, nous envisageons de montrer un robot quoi faire et de le laisser apprendre à atteindre l’objectif de manière autonome.»

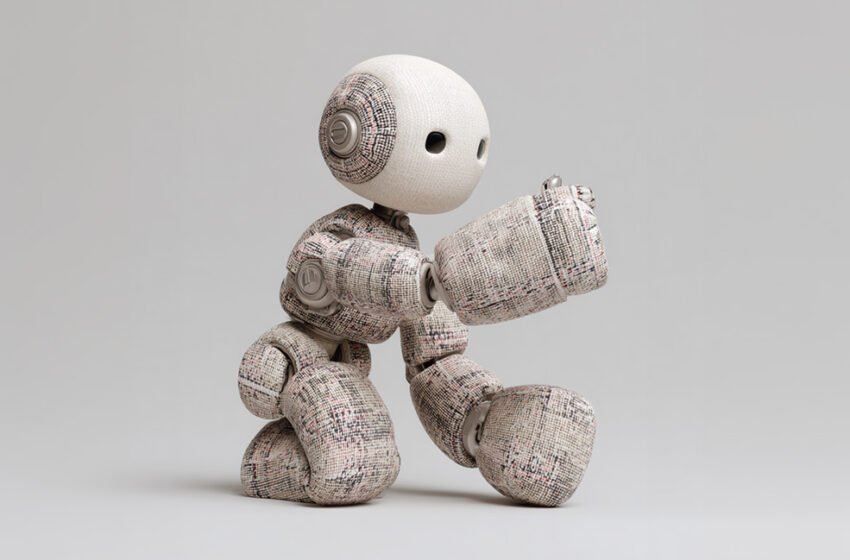

MIT essaie de rendre les robots plus flexibles, abordables

Les scientifiques ont déclaré que leur motivation découle d’un simple recadrage: la principale obstacle à la robotique abordable et flexible n’est pas le matériel – c’est le contrôle de la capacité, qui pourrait être réalisée de plusieurs manières. Les robots traditionnels sont construits pour être rigides et capteur-Rich, ce qui facilite la construction d’un jumeau numérique, une réplique mathématique précise utilisée pour le contrôle.

Mais lorsqu’un robot est doux, déformable ou de forme irrégulière, ces hypothèses s’effondrent. Plutôt que de forcer les robots à faire correspondre certains modèles, NJF retourne le script en leur donnant la capacité d’apprendre leur propre modèle interne à partir de l’observation.

Ce découplage de la modélisation et de la conception matérielle pourrait étendre considérablement l’espace de conception de la robotique. Dans les robots doux et bio-inspirés, les concepteurs intègrent souvent des capteurs ou renforcent les parties de la structure juste pour rendre la modélisation possible.

NJF soulève cette contrainte, a déclaré l’équipe du MIT CSAIL. Le système n’a pas besoin de capteurs embarqués ou de réglages de conception pour rendre le contrôle possible. Les concepteurs sont plus libres d’explorer des morphologies non conventionnelles et non contraints sans se soucier de savoir s’ils seront en mesure de les modéliser ou de les contrôler plus tard, a-t-il affirmé.

« Pensez à la façon dont vous apprenez à contrôler vos doigts: vous vous sortez, vous observez, vous vous adaptez », a déclaré Li. «C’est ce que fait notre système. Il expérimente des actions aléatoires et détermine les contrôles déplacez les parties du robot.»

Le système s’est avéré robuste sur une gamme de types de robots. L’équipe a testé le NJF sur un pneumatique doux main robotique capable de pincer et de saisir, une main allegro rigide, un bras robotique imprimé en 3D et même une plate-forme rotative sans capteurs intégrés. Dans tous les cas, le système a appris à la fois la forme du robot et comment il a répondu aux signaux de contrôle, juste à partir de vision et mouvement aléatoire.

Le NJF a des applications réelles potentielles

Les chercheurs du MIT CSAIL ont déclaré que leur approche avait un potentiel bien au-delà du laboratoire. Les robots équipés de NJF pourraient un jour se produire agricole Les tâches avec une précision de localisation au niveau des centimètres, fonctionnent sur construction Sites sans réseaux de capteurs élaborés ou naviguer dans des environnements dynamiques où les méthodes traditionnelles se décomposent.

Au cœur du NJF se trouve un réseau neuronal qui capture deux aspects entrelacés du mode de réalisation d’un robot: sa géométrie tridimensionnelle et sa sensibilité aux entrées de contrôle. Le système s’appuie sur les champs de rayonnement neuronal (NERF), une technique qui reconstruit les scènes 3D des images en cartographiant les coordonnées spatiales aux valeurs de couleur et de densité. Le NJF étend cette approche en apprenant non seulement la forme du robot, mais aussi un champ jacobien, une fonction qui prédit comment tout point sur le corps du robot se déplace en réponse aux commandes motrices.

Pour former le modèle, le robot effectue des mouvements aléatoires tandis que plusieurs caméras enregistrent les résultats. Aucune supervision humaine ou connaissance préalable de la structure du robot n’est requise – le système déduit simplement la relation entre les signaux de contrôle et le mouvement en regardant.

Une fois l’entraînement terminé, le robot n’a besoin que d’une seule caméra monoculaire pour un contrôle en boucle fermée en temps réel, fonctionnant à environ 12 Hertz. Cela lui permet de s’observer en continu, de planifier et d’agir de manière responsable. Cette vitesse rend le NJF plus viable que de nombreux simulateurs basés sur la physique pour les robots doux, qui sont souvent trop intensifs en calcul pour une utilisation en temps réel.

Très tôt simulationsmême les doigts 2D simples et les curseurs ont pu apprendre cette cartographie en utilisant quelques exemples, ont noté les scientifiques. En modélisant comment les points spécifiques se déforment ou déplacent en réponse à l’action, le NJF construit une carte dense de la contrôlabilité. Ce modèle interne lui permet de généraliser le mouvement à travers le corps du robot, même lorsque les données sont bruyantes ou incomplètes.

« Ce qui est vraiment intéressant, c’est que le système comprend seul quels moteurs contrôlent quelles parties du robot », a déclaré Li. « Ce n’est pas programmé – il émerge naturellement par l’apprentissage, un peu comme une personne découvrant les boutons sur un nouvel appareil. »

L’avenir de la robotique est doux, dit CSAIL

Pendant des décennies, la robotique a favorisé les machines rigides et facilement modélisées – comme le industriel Armes trouvées dans les usines – parce que leurs propriétés simplifient le contrôle. Mais le domaine a évolué vers des robots doux et bio-inspirés qui peuvent s’adapter plus fluides au monde réel. Le compromis? Ces robots sont plus difficiles à modéliser, selon le MIT CSAIL.

«La robotique se sent souvent hors de portée en raison de capteurs coûteux et de programmes complexes», a déclaré Vincent Sitzmann, auteur principal et professeur adjoint du MIT. «Notre objectif avec les champs de Jacobian neuronaux est de réduire la barrière, de rendre la robotique abordable, adaptable et accessible à plus de personnes.»

« La vision est un capteur résilient et fiable », a ajouté Sitzmann, qui dirige le groupe de représentation de la scène. «Il ouvre la porte aux robots qui peuvent fonctionner dans des environnements désordonnés et non structurés, des fermes aux chantiers de construction, sans infrastructure coûteuse.»

«La vision à elle seule peut fournir les indices nécessaires à la localisation et au contrôle – éliminant le besoin de GPS, de systèmes de suivi externes ou de capteurs intégrés complexes», a noté la co-auteur Daniela Rus, le professeur Erna Viterbi de génie électrique et le directeur du MIT Csail.

«Cela ouvre la porte à un comportement adaptatif robuste dans des environnements non structurés, de drones naviguer à l’intérieur ou underground sans cartes, pour manipulateurs mobiles travailler dans des maisons encombrées ou entrepôtset même robots à pattes Traversant un terrain inégal « , a-t-elle déclaré. » En apprenant à partir de la rétroaction visuelle, ces systèmes développent des modèles internes de leur propre mouvement et de leur dynamique, permettant une opération flexible et auto-supervisée où les méthodes de localisation traditionnelles échoueraient. «

Bien que la formation du NJF nécessite actuellement plusieurs caméras et doit être refait pour chaque robot, les chercheurs ont déjà considéré une version plus accessible. À l’avenir, les amateurs pourraient enregistrer les mouvements aléatoires d’un robot avec leur téléphone, un peu comme vous prenez une vidéo d’une voiture de location avant de partir et utilisez ces images pour créer un modèle de contrôle, sans connaissance préalable ni équipement spécial requis.

https://www.youtube.com/watch?v=dfz1rvjmn7a

L’équipe du MIT travaille sur les limites du système

Le système NJF ne généralise pas encore à travers différents robots, et il manque de force ou tactile détection, limiter son efficacité sur les tâches riches en contact. Mais l’équipe explore de nouvelles façons de traiter ces limites, notamment l’amélioration de la généralisation, la gestion des occlusions et l’extension de la capacité du modèle à raisonner sur des horizons spatiaux et temporels plus longs.

« Tout comme les humains développent une compréhension intuitive de la façon dont leurs corps se déplacent et réagissent aux commandes, NJF donne aux robots qui incarnaient la conscience de soi par la vision seule », a déclaré Li. «Cette compréhension est un fondement de la manipulation et du contrôle flexibles dans des environnements réels. Notre travail, essentiellement, reflète une tendance plus large de la robotique: s’éloigner de la programmation manuelle des modèles détaillés vers l’enseignement des robots par observation et interaction.»

Cet article a réuni la vision informatique et le travail d’apprentissage auto-supervisé du laboratoire principal de l’enquêteur Sitzmann et l’expertise dans les robots souples du laboratoire de RUS. Li, Sitzmann et Rus ont co-écrit le document avec CSAIL Ph.D. Étudiants Annan Zhang SM ’22 et Boyuan Chen, chercheur de premier cycle Hanna Matusik et postdoc Chao Liu.

La recherche a été soutenue par le Fonds de recherche Solomon Buchsbaum par le biais du comité de soutien à la recherche du MIT, une bourse présidentielle du MIT, la National Science Foundation et l’Institut Gwangju Science and Technology. Leur résultats ont été publiés dans Nature ce mois.