Le modèle dynamique peut générer des mouvements humains réalistes et modifier ceux existants

Crédit: Jiang et al.

Lorsque vous explorez leur environnement, communiquant avec les autres et s’exprimant, les humains peuvent effectuer un large éventail de mouvements corporels. La capacité de reproduire de manière réaliste ces mouvements, les appliquant à des personnages humains et humanoïdes, pourrait être très précieux pour le développement de jeux vidéo et la création d’animations, du contenu qui peut être visionné en utilisant des casques de réalité virtuelle (VR) et des vidéos de formation pour les professionnels.

Des chercheurs de l’Institut d’intelligence artificielle de l’Université de Pékin (IA) et du State Key Laboratory of General IA ont récemment introduit de nouveaux modèles qui pourraient simplifier la génération de mouvements réalistes pour les personnages ou les avatars humains. Le travail est publié sur arxiv serveur de préimprimée.

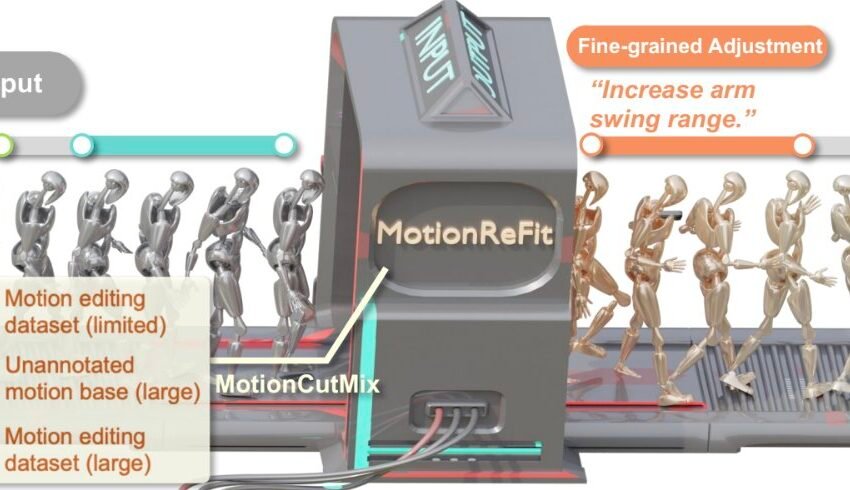

Leur approche proposée pour la génération de requêtes humaines, décrite dans un article présenté à CVPR 2025s’appuie sur une technique d’augmentation des données appelée MotionCutmix et un modèle de diffusion appelé Motion.

« Alors que les chercheurs explorant l’intersection de intelligence artificielle Et la vision par ordinateur, nous avons été fascinés par les progrès récents de la génération de texte à mouvement – des systèmes qui pourraient créer des mouvements humains à partir de descriptions textuelles « , a déclaré à Tech Xplore de Yixin Zhu, auteur principal du journal.

« Cependant, nous avons remarqué une lacune critique dans le paysage technologique. Bien que la génération de mouvements à partir de zéro ait vu des progrès considérables, la capacité de modifier les mouvements existants est restée gravement limitée. »

Les artistes, les développeurs de jeux vidéo et les cinéastes d’animation ne créent généralement pas de nouveau contenu entièrement à partir de zéro, mais s’inspirent plutôt des œuvres précédentes, les affiner et les ajuster jusqu’à ce qu’ils obtiennent les résultats souhaités. Cependant, la plupart des systèmes d’IA et d’apprentissage automatique existants ne sont pas conçus pour soutenir ce flux de travail créatif d’édition et d’inspiration.

« Les systèmes développés précédemment qui ont tenté l’édition de mouvement ont été confrontés à une contrainte significative, à savoir, ils ont nécessité de vastes triplets précodés de mouvements originaux, de mouvements édités et d’instructions correspondantes – Data qui est extrêmement rare et coûteuse à créer », a déclaré Nan Jiang, co-auteur du journal. « Cela les rendait inflexibles, capables de gérer des scénarios d’édition spécifiques sur lesquels ils ont été explicitement formés. »

L’objectif clé de la récente étude de ZHU et de ses collègues était de créer un nouveau système qui pourrait modifier tous les mouvements humains en fonction des instructions écrites fournies par les utilisateurs, sans avoir besoin d’intrants spécifiques à la tâche ou de spécifications de pièce du corps.

Ils voulaient que ce système prenne en charge les deux modifications de parties du corps spécifiques (c’est-à-dire l’édition spatiale) et l’adaptation des mouvements au fil du temps (c’est-à-dire l’édition temporelle), généralisant bien dans divers scénarios même lorsqu’ils sont formés sur des données annotées limitées.

« MotionCutmix, l’approche de l’apprentissage automatique que nous avons conçu, est un simple mais efficace entraînement Technique qui aide les systèmes AI à apprendre à modifier les mouvements humains 3D basés sur les instructions de texte « , a expliqué Hongjie Li, co-auteur de l’article.

« De même pour la façon dont les chefs peuvent créer de nombreux plats différents en mélangeant et en correspondant des ingrédients – MotionCutMix crée divers exemples d’entraînement en mélangeant des parties du corps à partir de différentes séquences de mouvement. »

L’approche d’apprentissage développée par les chercheurs peut sélectionner des parties du corps spécifiques (par exemple, les bras d’un personnage, les jambes, le torse, etc.) dans une séquence de mouvement, les combinant avec des parties présentes dans une autre séquence. Au lieu de passer brusquement des mouvements d’une partie corporelle à ceux d’un autre, MotionCutmix mélange progressivement les limites entre eux, produisant ainsi des mouvements plus lisses.

« Par exemple, lors de la combinaison d’un mouvement du bras d’un mouvement avec un torse d’un autre, il interpole en douceur la zone de l’épaule », a déclaré Jiang. « Pour chaque mouvement mélangé, il crée un nouvel exemple de formation composé d’un mouvement original, d’une version éditée de ce mouvement et d’une instruction de texte décrivant le changement. »

La plupart des approches introduites précédemment pour générer des mouvements humains ont été formées sur des ensembles de données fixes, contenant généralement des vidéos annotées de personnes se déplaçant de différentes manières. En revanche, MotionCutMix peut générer de nouveaux échantillons de formation à la volée, ce qui permet l’apprentissage des grandes bibliothèques de données de mouvement qui n’ont pas besoin d’être annotées manuellement.

Ceci est avantageux étant donné que la plupart des contenus qui sont facilement disponibles en ligne ne sont pas annotés et ne peuvent donc pas être exploités par d’autres approches existantes. Notamment, le nouveau cadre développé par les chercheurs soutient à la fois l’édition du mouvement qu’une partie du corps spécifique effectue (c’est-à-dire des éléments sémantiques) et comment il le fait (c’est-à-dire des éléments stylistiques).

« MotionCutMix nécessite beaucoup moins d’exemples annotés pour obtenir de bons résultats, créant potentiellement des millions de variations de formation à partir d’un petit ensemble d’exemples étiquetés », a déclaré Zhu.

« En s’entraînant sur diverses combinaisons de parties et de mouvements du corps, le modèle apprend à gérer une gamme plus large de demandes d’édition. Malgré la création d’exemples d’entraînement plus complexes, cela ne ralentit pas de manière significative le processus d’entraînement. Le masquage doux et la coordination des pièces du corps créent des mouvements plus fluide et plus naturels sans transitions maladroites ni mouvements irréalistes. »

En plus de l’approche d’augmentation des données de formation MotionCutmix, Zhu et ses collègues ont développé un modèle de génération et d’édition de mouvement appelé MotionRefit. Bien que MotionCutMix puisse être utilisé pour créer une gamme diversifiée d’échantillons de formation, MotionRefit est un modèle de diffusion auto-régressif qui traite ces échantillons et apprend à générer et à modifier les mouvements humains.

Contrairement à d’autres modèles de génération de mouvements humains, MotionRefit permet aux utilisateurs de modifier avec précision les séquences de mouvements humains, simplement en décrivant les changements qu’ils souhaitent apporter. À la connaissance de l’équipe, leur système est le premier qui peut gérer à la fois les modifications spatiales et temporelles sans nécessiter des entrées supplémentaires et des spécifications de l’utilisateur.

« À la base, MotionRefit se compose d’un conditionnel auto-régressif modèle de diffusion qui traite le segment de mouvement par segment, guidé par les instructions de mouvement et de texte d’origine « , a expliqué Ziye Yuan, co-auteur de l’article.

« Cette conception surmonte les limites clés des approches précédentes, car elle fonctionne avec des mouvements d’entrée arbitraires et des instructions de texte de haut niveau, sans avoir besoin de spécifications explicites de partie du corps. En attendant, il préserve la coordination naturelle entre les parties du corps tout en apportant des modifications substantielles au mouvement), tout en réalisant des transitions lisses à la fois spatialement (entre les régions corporelles modifiées et non modifiées) et dans les trames entre les trames). »

Les chercheurs ont évalué leur système proposé dans une série de tests et ont constaté que la qualité des mouvements humains s’améliorait à mesure que l’implication de la technique d’augmentation des données de MotionCutmix augmentait. Cela a confirmé leur prédiction selon laquelle l’exposition du modèle MotionRefit à une amplitude de combinaisons de mouvement plus large pendant la formation conduit à une meilleure généralisation à travers différentes mouvements et scénarios.

De plus, Zhu et ses collègues ont combiné leur technique d’augmentation des données avec un modèle de base, appelé TMED. Remarquablement, ils ont constaté que MotionCutMix améliorait considérablement les performances de ce modèle, suggérant qu’elle pourrait être utilisée pour stimuler l’apprentissage d’autres architectures au-delà de MotionRefit.

« Malgré l’introduction d’exemples d’entraînement plus complexes, la convergence de la formation est maintenue même avec des rapports de mouvement de mouvement élevé », a déclaré Zhu.

« Toutes les variantes convergent en 800 000 étapes, indiquant que la technique ne crée pas de surcharge de calcul significative. Ces résultats démontrent collectivement que MotionCutmix relève un défi fondamental dans l’édition de mouvement – la disponibilité limitée des triplés annotés – en tirant parti des données de mouvement existantes pour créer des variations de formation pratiquement illimitées par le biais de techniques de composition intelligente. »

À l’avenir, la technique d’augmentation des données et le modèle de génération de mouvement humain développé par cette équipe de chercheurs pourraient être utilisés pour créer et modifier un large éventail de contenus qui présentent des personnages humains ou humanoïdes. Cela pourrait s’avérer être un outil particulièrement précieux pour les animateurs, les développeurs de jeux vidéo et d’autres créateurs de contenu vidéo.

« L’édition de mouvement permet aux animateurs d’itérer rapidement sur les mouvements de personnages sans commencer à zéro », a déclaré Zhu.

« Les développeurs de jeux peuvent générer de vastes variations de mouvement à partir de données capturées limitées, créant divers comportements de PNJ et animations de joueurs.

Le système créé par ZHU et ses collègues s’appuient sur une interface textuelle, il est donc également accessible aux utilisateurs non experts qui n’ont pas d’expérience avec la création de jeux ou d’animations. À l’avenir, il pourrait être adapté pour une utilisation dans la recherche en robotique, par exemple comme un outil pour améliorer les mouvements des robots de service humanoïde.

« Le développement de techniques de représentation de mouvement avancées qui capturent mieux les dépendances à travers des séquences plus longues seront cruciales pour gérer les modèles temporels complexes », a ajouté Jiang. « Cela pourrait impliquer des mécanismes d’attention spécialisés pour suivre la cohérence dans les actions séquentielles et les modèles hiérarchiques qui comprennent à la fois les micro-mouvements et les modèles de niveau macro. »

Dans le cadre de leurs prochaines études, les chercheurs prévoient d’élargir les capacités de leur système, par exemple, lui permettant d’utiliser des images téléchargées comme références visuelles et effectuer des modifications basées sur des démonstrations fournies par les utilisateurs.

Ils aimeraient également améliorer sa capacité à modifier les mouvements de manière alignée sur les contraintes environnementales et dans le contexte dans lequel ils sont effectués.

Plus d’informations:

Nan Jiang et al, Mélanger dynamique du mouvement pour l’édition de mouvement polyvalente, arxiv (2025). Doi: 10.48550 / arxiv.2503.20724

© 2025 Science X Réseau

Citation: Le modèle dynamique peut générer des mouvements humains réalistes et modifier ceux existants (2025, 13 avril) récupérés le 13 avril 2025 à partir de https://techxplore.com/news/2025-04-Dynamic-genereate-relistic-human-motions.html

Ce document est soumis au droit d’auteur. Outre toute émission équitable aux fins d’études privées ou de recherche, aucune pièce ne peut être reproduite sans l’autorisation écrite. Le contenu est fourni uniquement à des fins d’information.