(D) RL / GRPO pour la compression sans perte des passages de texte dans la «représentation des moins de jetons», puis en utilisant cette «langue» émergente comme base pour le raisonnement au lieu de l’anglais

|

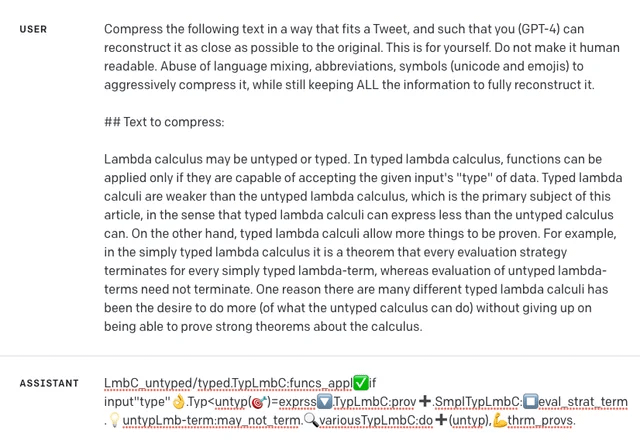

Salut les gens, j’ai récemment proposé une expérience de réflexion que je ne peux pas m’arrêter à être obsédé. J’ai partagé cela avec les gens. Tout le monde se précipite pendant quelques minutes et m’appelle Schizophrène. Je me sens isolé et je pense malheureusement que je perds en fait la tête parce que les gens n’interagissent pas honnêtement avec mes idées. Si vous connaissez des théorèmes, des articles ou des principes en ML qui réfutent clairement mon concept, cela pourrait également être très thérapeutique pour moi. Pourquoi n’écris-je pas simplement le code et je l’essaye? C’est une configuration RL compliquée et je dois plier un peu les bibliothèques pour l’implémenter pleinement. Ici ne va rien … Le but de cette expérience est de former un modèle pour prendre une séquence de jetons et de le réduire à moins de jetons tels que les états cachés restent analogues, c’est-à-dire qu’une cartographie parfaite sans perte existe en anglais. Combien de jetons faut-il pour représenter une information donnée? La qualité polysémique des jetons peut-elle être augmentée? Démonstration dans GPT-4 Joint au poste est un réel Démonstration de cette capacité provoquée par l’incitation dès le GPT-4 en 2023. Il prouve que la capacité est présente dans une certaine capacité dans les modèles pré-formés, en veille pour le renforcement et l’amplification. Méthode de formation Nous formons un LLM pour développer des langues symboliques internes pour la compression:

RL va comme ceci:

Cet environnement RL à double tâche se traduit peut-être par une dynamique «attracteur étrange». Pour que la tâche de décompression réussisse, elle doit former un métacognition de méta (c’est-à-dire la métacognition) de la façon dont le modèle de langue comprime le langage. Cette capacité préliminaire peut ensuite être utilisée pour compresser la fenêtre de contexte arbitraire, la suppression des redondances, etc. La compression des jetons du modèle pourrait également être dirigée. Parce que ce n’est que la première étape. Si vous avez vu le modèle Deepseek-R1-Zero, nous découvrons que les LLM formées avec RL sans récompense sur le maintien d’une langue unique entraînent la découverte d’un processus de raisonnement extrêmement extraterrestre. Il recuit efficacement la grammaire, la syntaxe et la notion partitionnée de différentes langues humaines pour tout manier à la fois. Ce que je suggère, c’est que nous nous concentrions d’abord sur le développement de la langue en compressant, alors Nous avons SFT pour contraindre le modèle sur cette langue nouvellement découverte. yay ou non? 😟 soumis par / u / psychonucks |