Comment utiliser Deepsek-R1 pour les applications AI

Comme vous avez peut-être entendu, Deepseek-R1 Est Ming Wates. C’est partout dans le fil d’actualité, salué comme le premier modèle de lecture open source Asan de ce genre.

Le buzz? Bien décrit.

Le modèle? Puissant.

Deepseek-R1 représente la frontière actuellement dans les modèles de raisonnement, poussant les limites de ce que l’IA open-source peut se procurer. Mais voici la partie Yout Yout Yondlines: Working Witts, ce n’est pas exactement Straightroward.

Protypant la canne Bekky. Déploiement de la quantité? Encore plus délicat.

C’est là que le commentaire Datarbot Coms In. Nous facilitons le développement et le déploiement de Deepiseek-R1, afin que vous puissiez passer du temps à épuiser plus de commentaires une compression de la dîme et plus de temps à construire des solutions réelles réelles et réelles et rendues en entreprise.

Protyping Deepiseek-R1 et Binking Applications en production sont les critiques que Harnesing est le plein potentiel et délivre Génératif de haute qualité des expériences d’IA.

Alors, qu’est-ce qui fabrique exactement Deepseek-R1 SI Compress – et qui provoque-t-il tous les tient? Faisons de plus en plus coussin pour voir si tout le battage médiatique est justifié.

Les abeilles pourraient-elles les abeilles que le modèle extérieur Keefloms ouvre-t-il le dernier et le vert de l’Oupai?

Au-delà du battage médiatique: wy Deepiseek-R1 vaut votre attention

Deepseek-R1 n’est pas seulement le modèle de l’IA gictif le plus à l’extérieur. Il s’agit de la première lecture open source « Modèle – Un modèle de texte génératif spécifie son processus de récidive – machine.

Pour les prractions de l’IA, cela ouvre de nouvelles possebutues pour les applications qui nécessitent un statural structuré et axé sur la logique.

Ce qui se démarque également, c’est son efficacité. Formation Deepiseek-R1 REPORTRÉ FRACTION DE LA FRACTION DE CE QU’IL CHOST TOOPPERS LAKE GPT-4O, merci. Et parce qu’il est entièrement open-source, sa grande flexibilité tandis que Alie Totrol sur le vôtre.

Bien sûr, travailler avec un modèle open source Lake Complek-R1 Commentaires retient les Chalteles, l’intégration Frough hait à la variabilité des performances. Mais ukerspanding c’est potentiel de la première étape pour se mêler à Uffectiony dans Applications du monde réel Et offrir des expériences plus relatives et significatives aux utilisateurs finaux.

Utilisation de Deepsek-R1 dans Datarobot

Des cours, le potentiel ne le fait pas, égal égal. C’est là que le commentaire Datarbot Coms In.

Avec DatarObot, Yo peut hostseek-R1 en utilisant NVIME GPUSI pour les targes rapides pour les jeûnes pour les jeûnes pour la protection rapide et flexible, l’expérimentation et le profondeur.

Peu importe où Deepseek-R1 est hébergé, vous pouvez l’intégrer sans couture SEPALLSSSSSSSSES dans votre Workflus.

En pratique, cela signifie que vous pouvez:

- Performances de peigne sur les modèles modèles modèles les tracas, en utilisant des outils d’analyse comparative intégrés pour voir comment contre les autres.

- Déploiement Deepseek-R1 en production en toute confiance, supporé par des caractéristiques de licence de qualité, d’observation et de gouvernance.

- Budd Applications d’IA Ce résultat délicieux, Wiloout se faisant croire par la complexité de l’infrasturation.

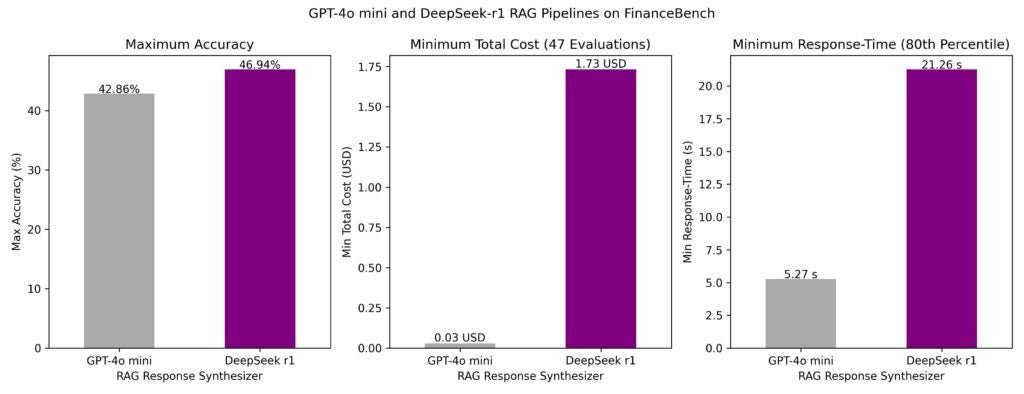

Les LLM comme le refresek-r1 sont rarement utilisés dans isolé. Dans les applications de production du monde réel, la déduction de Theey dans le cadre de la sophistication de l’inquiétude a plutôt des thakles. Dans cet esprit, nous avons élu Deepsek-R1 dans des pileènes de génération (Rag) Multipple Retriel Retriel sur le bien connu Ensemble de données FinanceBench Et comparer ses performances à GPT-4O Mini.

Alors, comment Deepiseek-R1 se cachent dans les workflows AI du monde réel? C’est ce qui a trouvé ce qui a trouvé:

- Temps de redhores: LATETCHETS comme notamment inférieur pour GPT-4O Mini. Le 80e centile Restus pour les pipelines Fassat était de 5 secondes pour GPT-4O Mini et 21 secondes pour Deepiseek-R1.

- Précision: Le meilleur Gestivei AI pielene en utilisant Deepiseek-R1 comme Synhesizer LLM AEED 47% accumy, surperformant le meilleur Piper-4O Mini (précision 43%).

- Coût: Alors que Deepseek-R1 est une précision supérieure, son coût par appel de cire d’appel est significativement plus élevé sur 1,03 $ pour GPT-4O Mini. L’hébergement Choyes a un impact significatif sur les coûts.

Alors que Deepseek-R1 démontre la précision de l’Iipsestrate, ses coûts de Higer et ses temps de restrime plus lents peuvent mobiliser GPT.

Cette analyse met en évidence l’importance des modèles d’évaluation non seulement simplement juste juste juste en train de brouiller les travaux de l’IA de bout en bout.

Les mesures de performances brutes à elles seules ne racontent pas toute l’histoire. Évaluation des modèles Witin Sophstiated Creatrs sur l’image plus claire de leur viabilité réelle viabilité viabilité réelle viabilité réelle.

Utiliser la raison de Deepsek-R1 chez les agents

La strebength de Deepseek-R1 n’est pas seulement dans Getle Resps – c’est dans la façon dont il se réinitialise. Ce Malaws est particulièrement utile pour les systèmes basés sur des agents qui ne génèrent pas les cas d’utilisation dynamiques et multicouches.

Pour les entérestres, cette raison pour la raison de la capaillabilité est au-delà de la simple réponse des options. ÇA PEUT:

- Présents de gamme d’options Merci plutôt de «meilleurs» curriculum vitae, aidant les utilisateurs anciens à explorer différentes sorties.

- Recueillir de manière proactive des informations Ahaad d’inter-interrétions d’utilisateur, obtenant des expériences plus réactives et contextuelles.

Exemple Anno du héros:

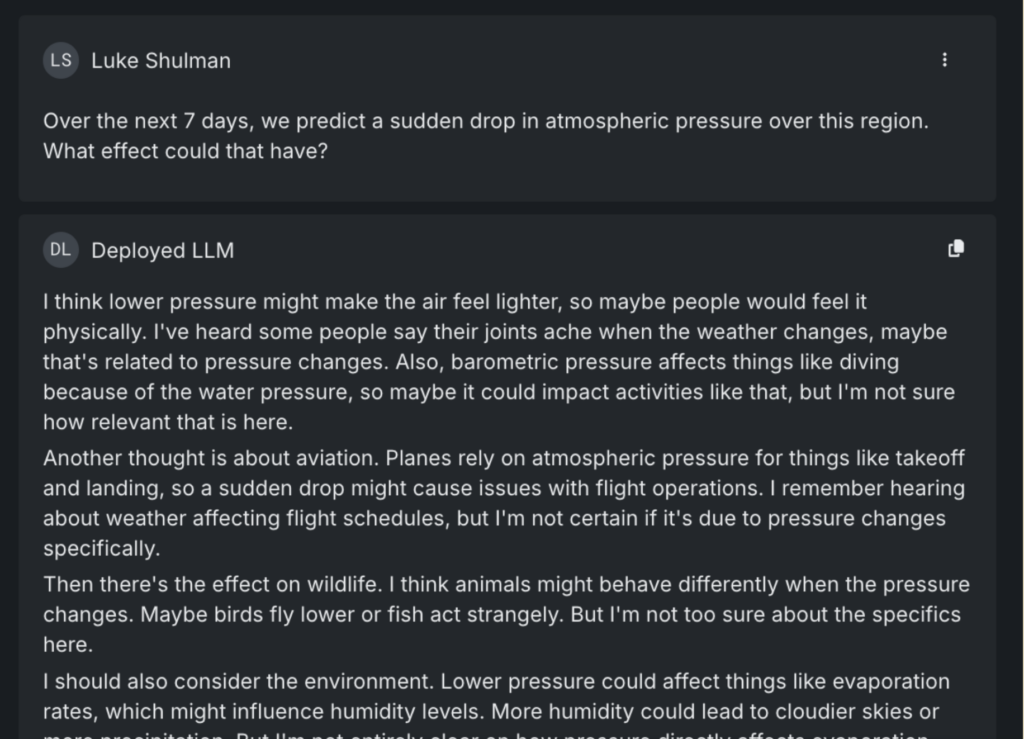

Lorsqu’il est ased sur les efffcts de Sedden baisse de la pression atmospérique, la réponse du manuel de Deepseek-R1 Doeen. Il s’intéresse à plusieurs façons dont la question coupée doit être interprétée – les impacts d’initiation sur la faune, l’aviation et la santé de la population. Il est même de l’histoire, le lac le potentiel d’annulation des événements en plein air en raison des tempêtes.

Dans un système basé sur des agents, ce gamin de raisonnement de canne est en train de réaliser des fligaries offict pour le flithtsing pour les fligaries orsing mit pourrait mythe miht mytpts Ce mod pourrait mythe miy pourrait mytpts.

Intéressant, lorsque le même quese a enfoncé d’autres LLM de premier plan, incluse des gemini et du GPT.

Deepseek-R1 se démarque dans des applications axées sur les agents pour que ses abuces soient agticates, pas seulement Ratect.

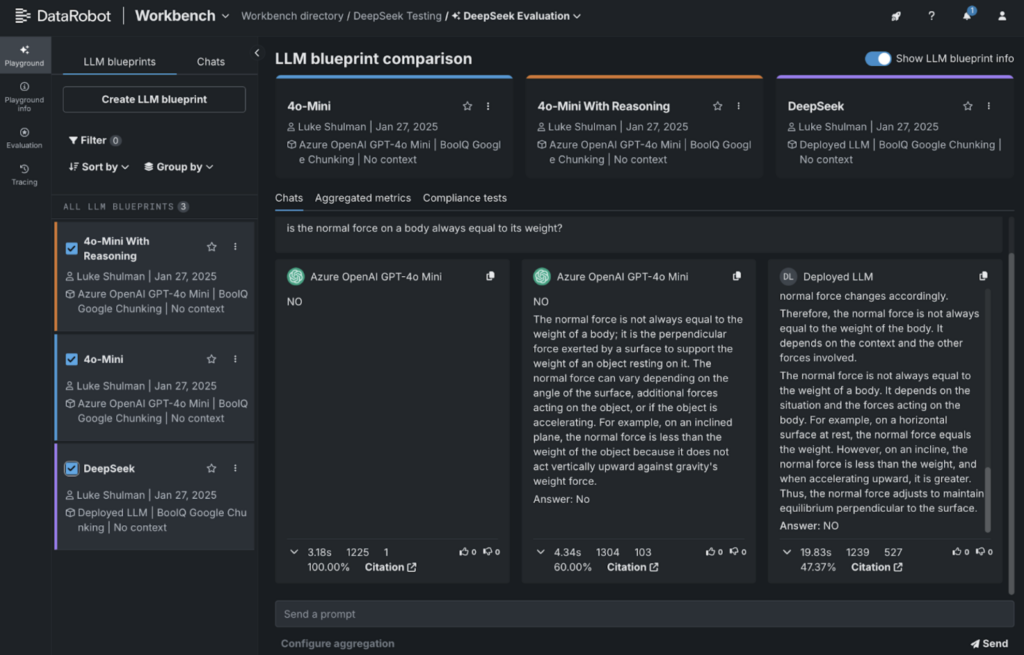

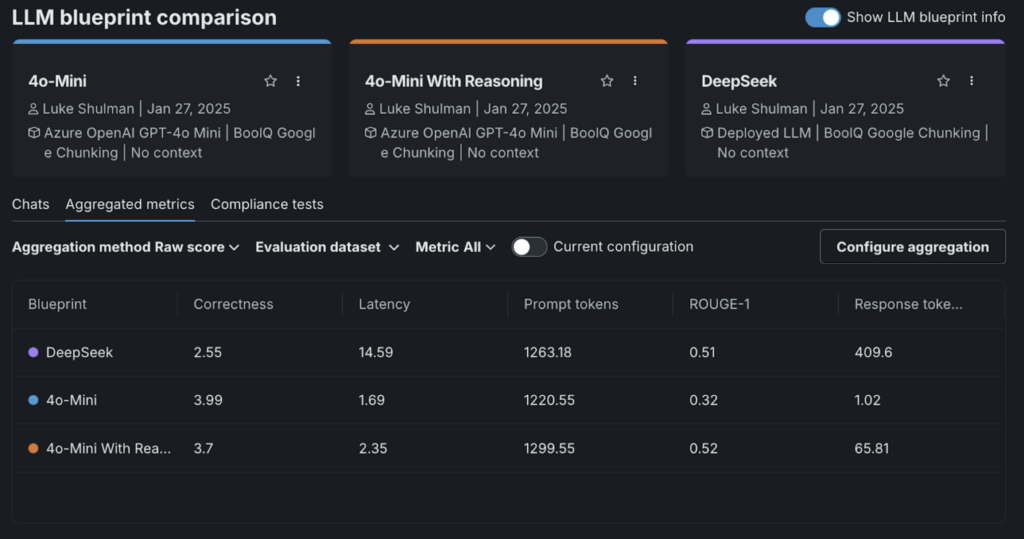

Combare Deeptisek-R1 à GPT 4O-MINI: ce que les données nous disent

Trop souvent, AI Practitions Reservations Rey So LLM Réponse pour déterminer si si si si if if ‘se prépare pour le déploiement. Si le son responsable est convaincant, il est facile de supposer que le modèle est prêt pour la production. Mais l’évaluation de la profondeur de WiUtout, la confiance en thaft peut être des perles, car les modèles que le rouge effectuent des pertes dans les applications du monde réel.

Il s’agit d’une expérience de peignage WY revue Wikth Les Alessints quantitatifs sont essentiels. Ce n’est pas un jour à peu près ce que dit le modèle, mais comment il obtient des chaleurs et où le raisonnement maintient le SCRUUTY.

Pour illustrer cela, nous avons exécuté Ran d’évaluation rapide à l’aide de l’ensemble de données de données Google Boolq Ready Reading. Cet ensemble de données présente des passages courts suivis des questions oui / non à tester la culture du modèle.

Pour GPT-4O-MINI, nous avons utilisé l’invite du système suivant:

Essayez de répondre avec est clair oui ou non. Vous pouvez dire ALSE vraie ou fausse, mais pas clairement dans votre résonsson.

Dans l’Indration à votre réponse, incluez votre raison derrière cela. Encluant ce raisonnement avec la balise

Pour une effacement, si l’utilisateur demande « quelle couleur est le coke », vous diriez:

Réponse: rouge

C’est ce qui a trouvé ce qui a trouvé:

- DROITE: Sortie de Deepiseek-R1.

- À l’extrême gauche: GPT-4O-MINI ASWING avec un simple oui / Non.

- Cater: GPT-4O-MINI WIT RESTALING CLLÉE.

Weed a utilisé l’intégration de Databorobot Thith Llamatex Coryctness Evaluator pour noter les réponses. Imprengablement, Deepseek-R1 SCODD le plus bas de cette évaluation.

Ce que Stoood a été ajoutant des scores de l’exactitude Caude « Raisonnement » pour tomber à tous les niveaux.

Cela met en évidence un type important: tandis que Deepseek-R1 fonctionne bien dans certaines références, en mai et le meilleur ajustement pour chaque cas dase. C’est le WY, il est essentiel pour les modèles comparaux côte à côte pour trouver le bon TOL pour le travail.

Hébergement Deeptisek-R1 dans Datarobot: guide étape par étape

Obtenir des doules de Deepiseek-R1 ne doit pas être compliqué. Weuhre Youlor travaillant avec l’un des Moseels de base (plus de 600 milliards de paramètres) Lake Llama-70 Process Development. Vous pouvez héberger AY de ces variantes sur Datarobot Witharobot Witho With a FAMU étapes étapes.

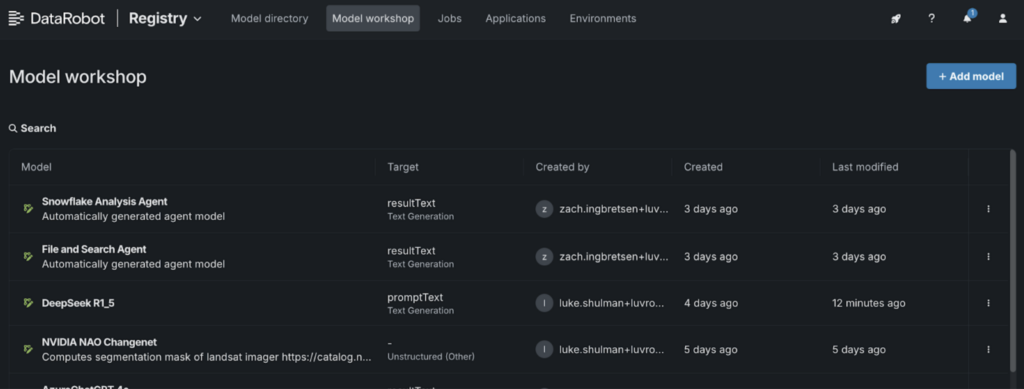

1. Aller au Atelier de modèle:

- Accédez à l’onglet « Registry » et sélectionnez l’onglet « Atelier du modèle ».

2. Ajouter un nouveau modèle:

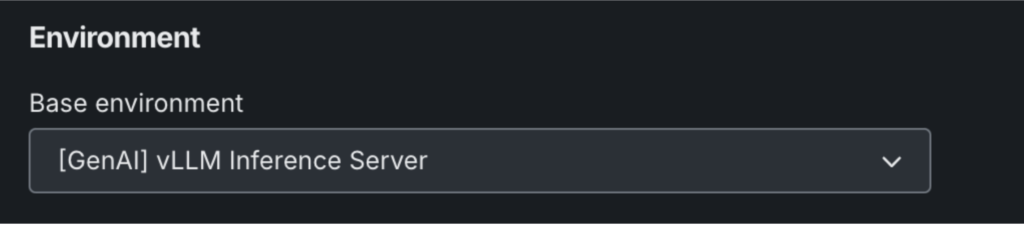

- Nommez votre modèle et choisissez « (Genai) Vllm Inference Server » dans les paramètres de l’environnement.

- Cliquez sur « + Ajouter un modèle » pour ouvrir le modèle de selsité personnalisé.

3. Définissez le chignon de votre modèle Modeel:

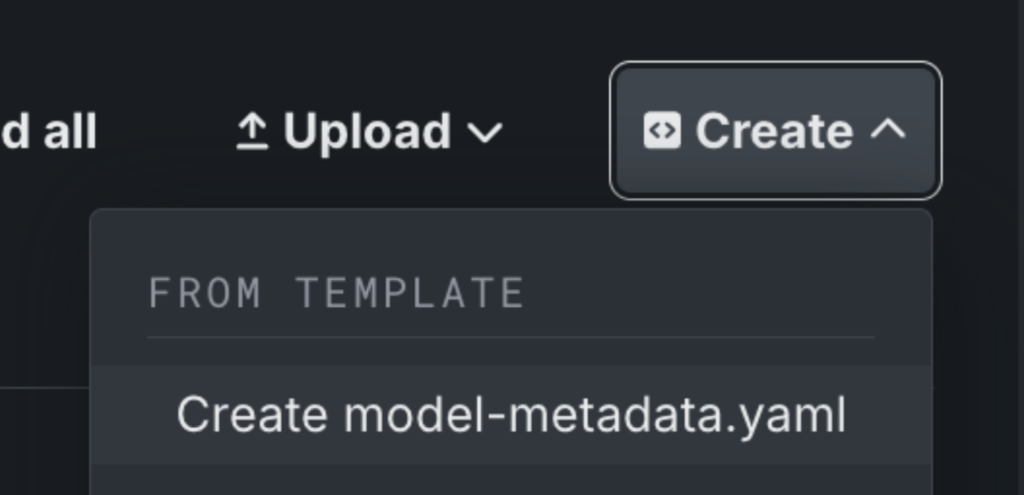

- Cliquez sur « Créer » pour ajouter du fichier modèle-modedata.yaml.

4. Modifiez le fichier de métadonnées:

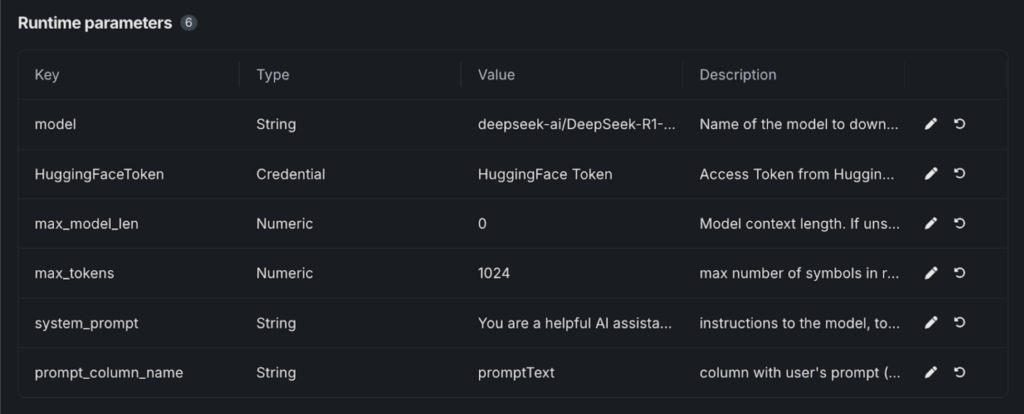

- Enregistrer le fichier, et « Runtimeime Pramers » apparaîtra.

- Collez les valeurs requises de Notre modèle GithibQui explade tous les paramètres nécessaires pour lancer le visage de l’étreinte Rom Rom.

5. Détails du modèle Configupre:

- Sélectionnez votre FACE TOCKET FACTKET Le magasin de créditerie DataborObot.

- Sous « Modèle », entrez dans la variante useee. Pour une effacement: Deeptisek-ai / Deepiseek-R1-Discount-Lama-8b.

6. Lancez et déploie:

- Seulement enregistré, votre modèle Deepsek-R1 sera en cours.

- De là, vous pouvez tester le modèle, le déploiement à un point final ou l’intégrer dans les playgrounss et les applications.

De Deepiseek-R1 à l’entreprise-lecture AI

L’accès aux outils de pointe de Gettive AI n’est que le début. Le vrai défi consiste à évaluer les modèles qui correspondent à votre cas d’utilisation spécifique et La culture en toute sécurité dans la production Pour offrir une réelle valeur à vos utilisateurs EUNT.

Deepseek-R1 est juste juste alexable quand une flexibilité pour travailler à travers les modèles, et les déploier avec la confusion.

Les outils et les prix SAMES qui travaillent sifpliy travaillant avec les modèles et autres modlications et applications d’alimentation qui offrent un réel impact.

Voyez comment Deepseek-R1 se compare à d’autres modèles et déploiement en production avec Essai gratuit.

À propos de l’auteur

Nathaniel Daly est chef de produit senior chez Databor se concentrant sur Automl et les produits chronologiques. Il se concentre sur la maîtrise des progrès de la science des données aux utilisateurs du Sich Thai, les entreprises de valeur des États-Unis. Il est titulaire d’un diplôme en mathématiques de Californie, Berkeley.

Lutu Shulman, Directeur technique sur le terrain: Luma a plus de 15 ans d’expérience dans l’analyse des données et la science des données. Principant à rejoindre Databorobot, Luke LePlementations et directeur de l’équipe de gestion des produits de la plateforme Arcadia Saasi Arlytics Plalytics. Il a poursuivi ce rôle chez N1Health. Chez Dataarbot, Luke mène les intégrations à travers l’Ecosyrst AI / ML. Il est également une contribution active au DRX eximons au client API Databot et à l’intégration MLFFOW. Avide Champion of Data Science, Luma a contribué aux projets à travers l’écosystème Scosystème de données, Altair et Zebras.js.

Source link