Comment apprendre l’IA pour l’analyse des données en 2025

Image de l’éditeur | Chatte

L’analyse des données a changé. Il n’est plus suffisant pour connaître des outils comme Python, SQL et Excel pour être un analyste de données.

En tant que professionnel des données dans une entreprise technologique, je vise de première main l’intégration de l’IA dans le flux de travail de chaque employé. Il existe un océan d’outils d’IA qui peuvent désormais accéder et analyser toute votre base de données et vous aider à créer des projets d’analyse de données, des modèles d’apprentissage automatique et des applications Web en quelques minutes.

Si vous êtes un professionnel des données en herbe et que vous n’utilisez pas ces outils d’IA, vous perdez. Et bientôt, vous serez dépassé par d’autres analystes de données; Les personnes qui utilisent l’IA pour optimiser leurs flux de travail.

Dans cet article, je vous guiderai à travers des outils d’IA qui vous aideront à rester en avance sur la concurrence et à 10x vos flux de travail d’analyse de données.

Avec ces outils, vous pouvez:

- Créer et déployer des projets de portefeuille créatifs pour être embauché comme analyste de données

- Utilisez un anglais simple pour créer des applications d’analyse de données de bout en bout

- Accélérez vos flux de travail de données et devenez un analyste de données plus efficace

De plus, cet article sera un guide étape par étape sur la façon d’utiliser des outils d’IA pour créer des applications d’analyse de données. Nous nous concentrerons sur deux outils d’IA en particulier – Cursor et Pandas AI.

Pour une version vidéo de cet article, regardez ceci:

https://www.youtube.com/watch?v=ukidskagai

Outil d’IA 1: curseur

Cursor est un éditeur de code AI qui a accès à l’intégralité de votre base de code. Il vous suffit de saisir une invite dans l’interface de chat du curseur, et il accédera à tous les fichiers de votre répertoire et modifiera le code pour vous.

Si vous êtes un débutant et que vous ne pouvez pas écrire une seule ligne de code, vous pouvez même commencer par un dossier de code vide et demander au curseur de créer quelque chose pour vous. L’outil AI suivra ensuite vos instructions et créera des fichiers de code en fonction de vos exigences.

Voici un guide sur la façon dont vous pouvez utiliser Cursor pour créer un projet d’analyse de données de bout en bout sans écrire une seule ligne de code.

Étape 1: installation et configuration du curseur

Voyons comment nous pouvons utiliser un curseur AI pour l’analyse des données.

Pour installer Cursor, allez simplement sur www.cursor.com, téléchargez la version compatible avec votre système d’exploitation, suivez les instructions d’installation et vous serez configuré en quelques secondes.

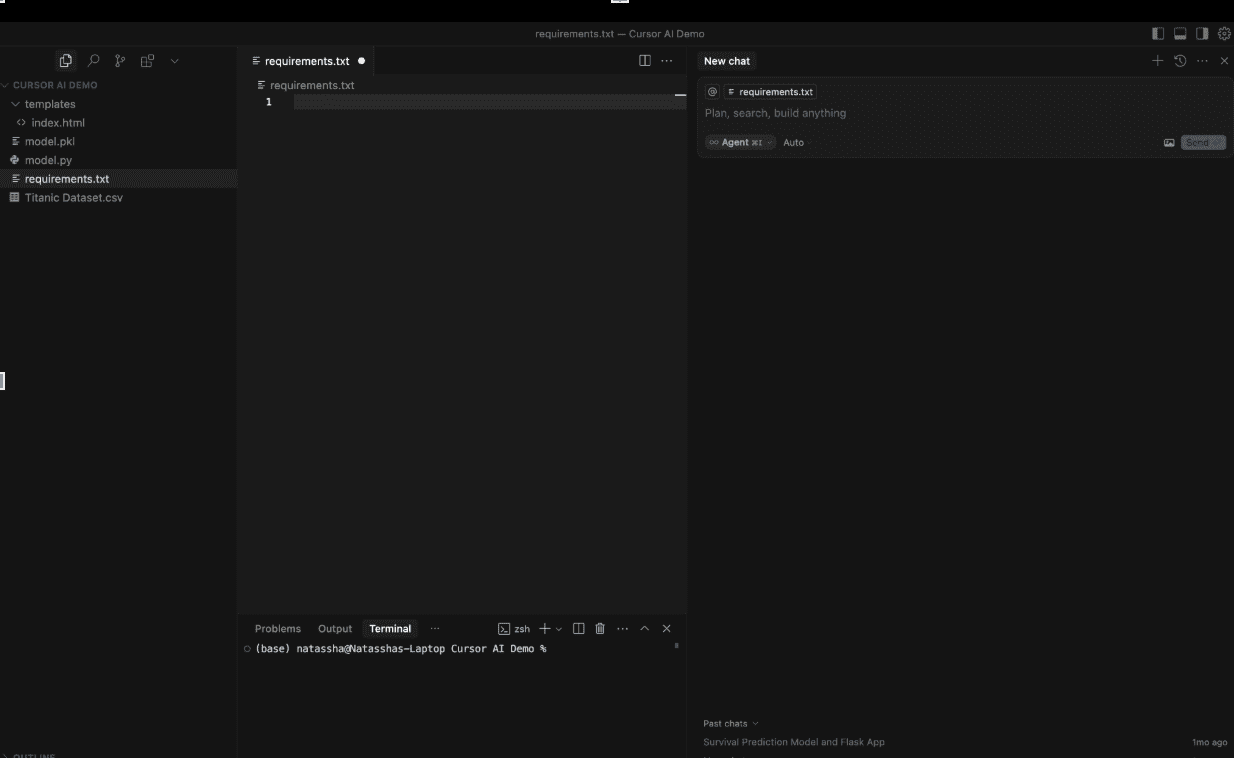

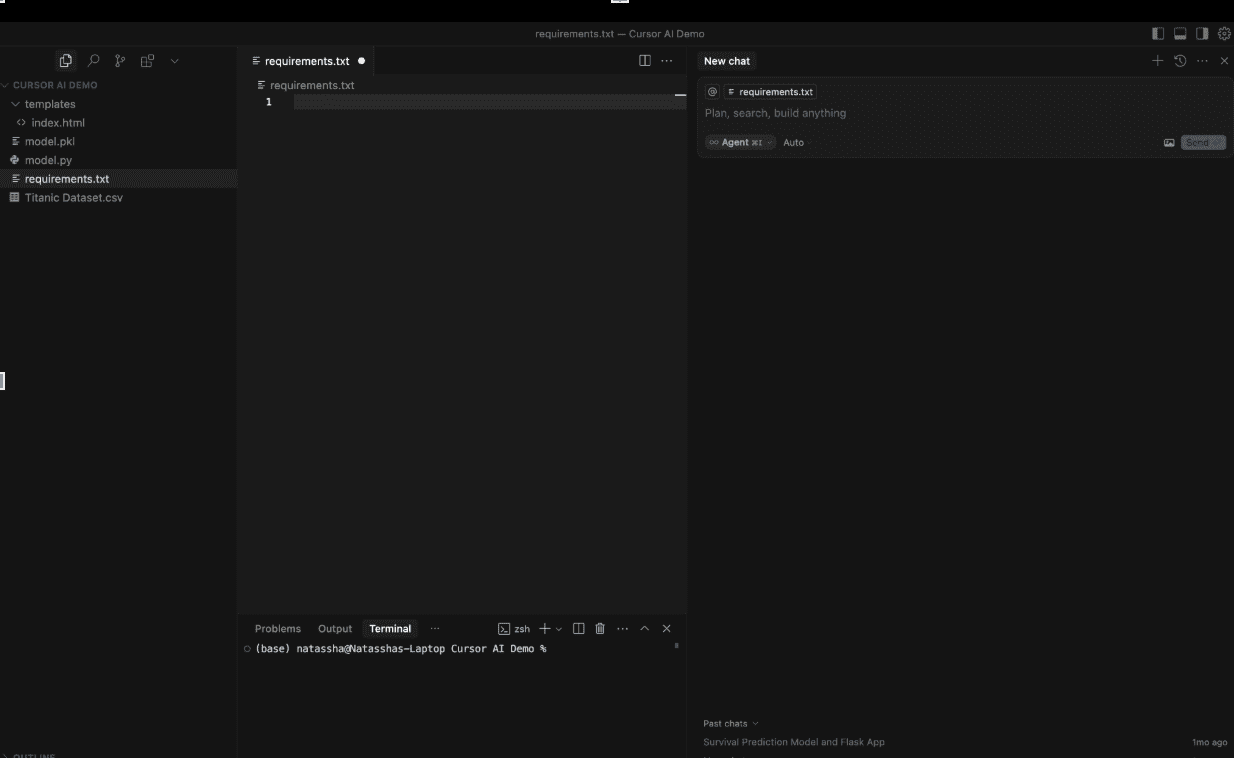

Voici à quoi ressemble l’interface du curseur:

Interface AI du curseur

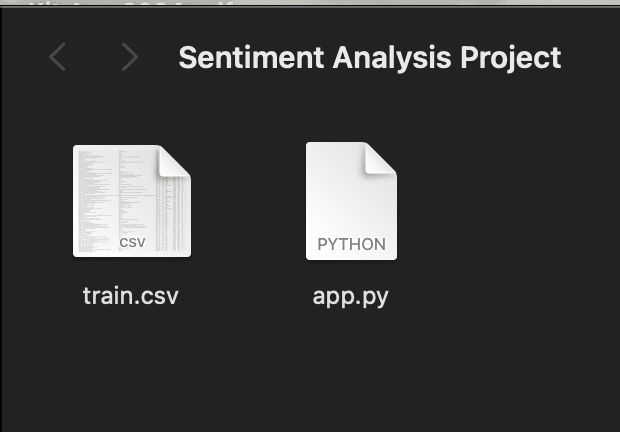

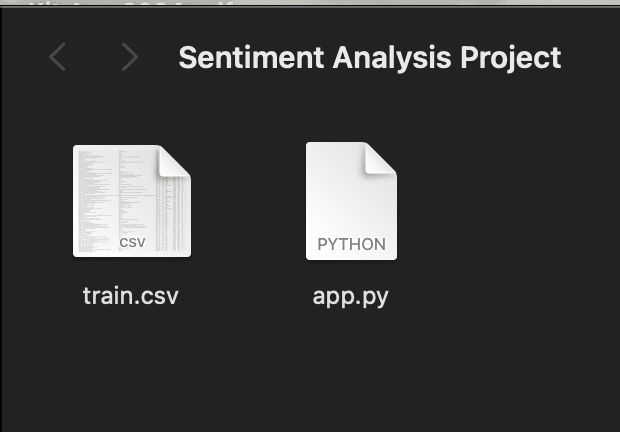

Pour suivre ce tutoriel, téléchargez le train.csv Fichier de l’ensemble de données d’analyse des sentiments sur Kaggle.

Créez ensuite un dossier nommé «Sentiment Analysis Project» et déplacez le fichier Train.csv téléchargé dedans.

Enfin, créez un fichier vide nommé app.py. Votre dossier de projet devrait maintenant ressembler à ceci:

Dossier du projet d’analyse des sentiments

Ce sera notre répertoire de travail.

Maintenant, ouvrez ce dossier dans le curseur en naviguant vers le dossier de fichier -> Ouvrir.

Le côté droit de l’écran a une interface de chat où vous pouvez taper des invites dans le curseur. Notez qu’il y a quelques sélections ici. Sélectionnons «l’agent» dans la liste déroulante.

Cela indique à Cursor d’explorer votre base de code et d’agir en tant qu’assistant AI qui refactora et déboguera votre code.

De plus, vous pouvez choisir le modèle de langue que vous souhaitez utiliser avec Cursor (GPT-4O, GEMINI-2.5-Pro, etc.). Je suggère d’utiliser Claude-4-Sonnet, un modèle bien connu pour ses capacités de codage avancées.

Étape 2: invitant le curseur à créer une application

Tapisons maintenant cette invite dans le curseur, lui demandant de créer un modèle d’analyse de sentiment de bout en bout en utilisant l’ensemble de données de formation dans notre base de code:

Create a sentiment analysis web app that:

1. Uses a pre-trained DistilBERT model to analyze the sentiment of text (positive, negative, or neutral)

2. Has a simple web interface where users can enter text and see results

3. Shows the sentiment result with appropriate colors (green for positive, red for negative)

4. Runs immediately without needing any training

Please connect all the files properly so that when I enter text and click analyze, it shows me the sentiment result right away.

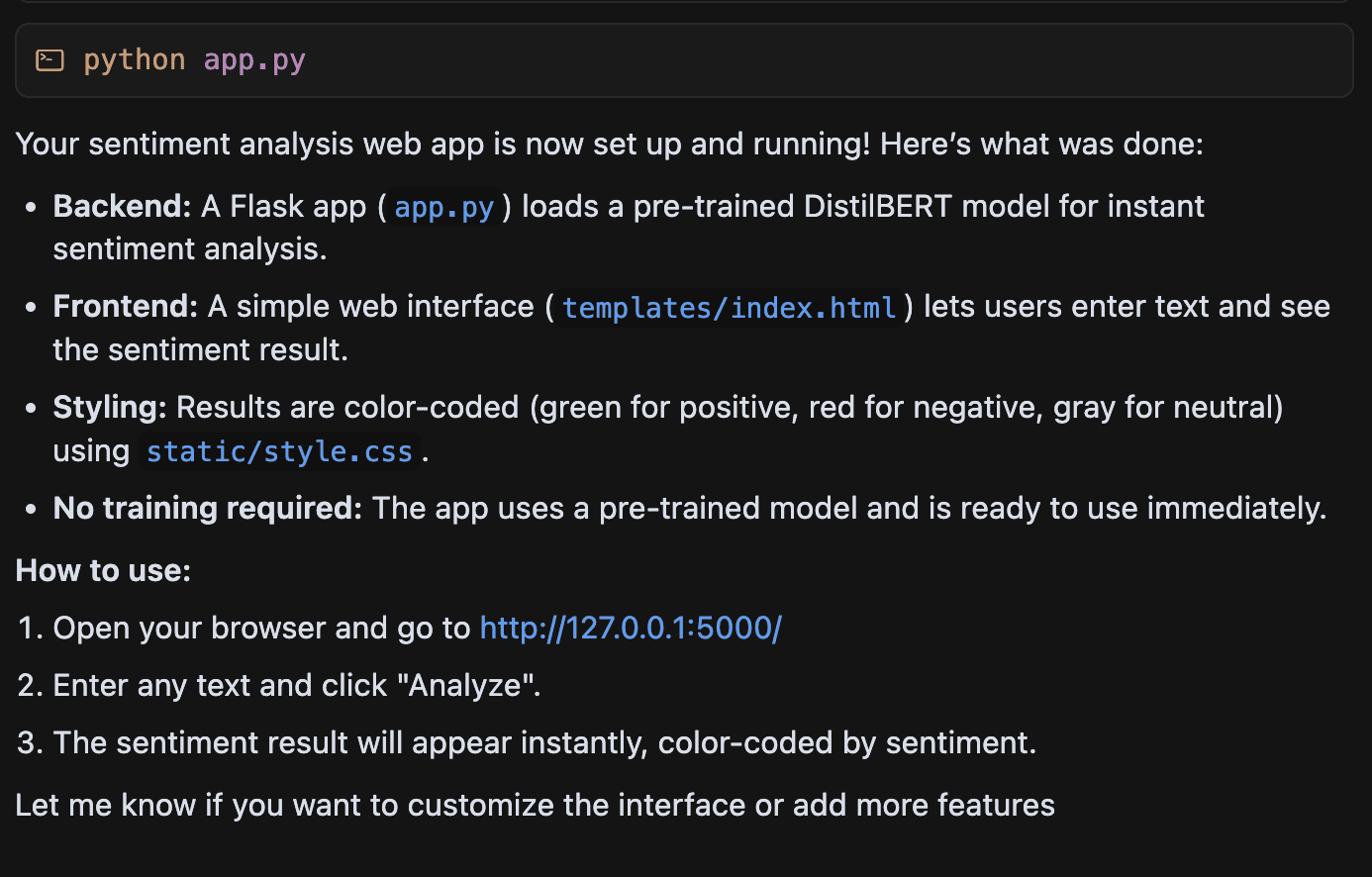

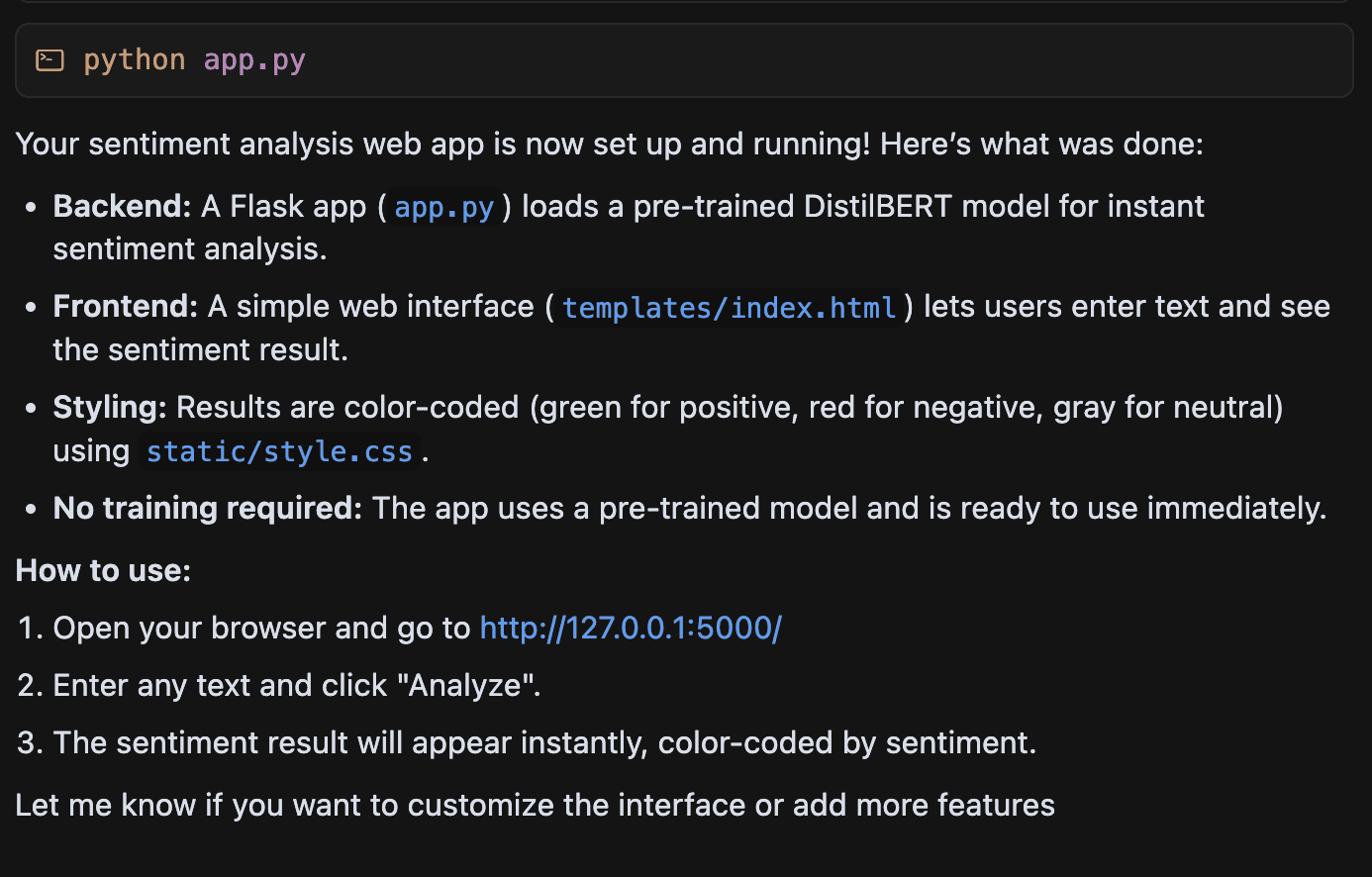

Après avoir saisi cette invite en curseur, elle générera automatiquement des fichiers de code pour créer l’application d’analyse de sentiment.

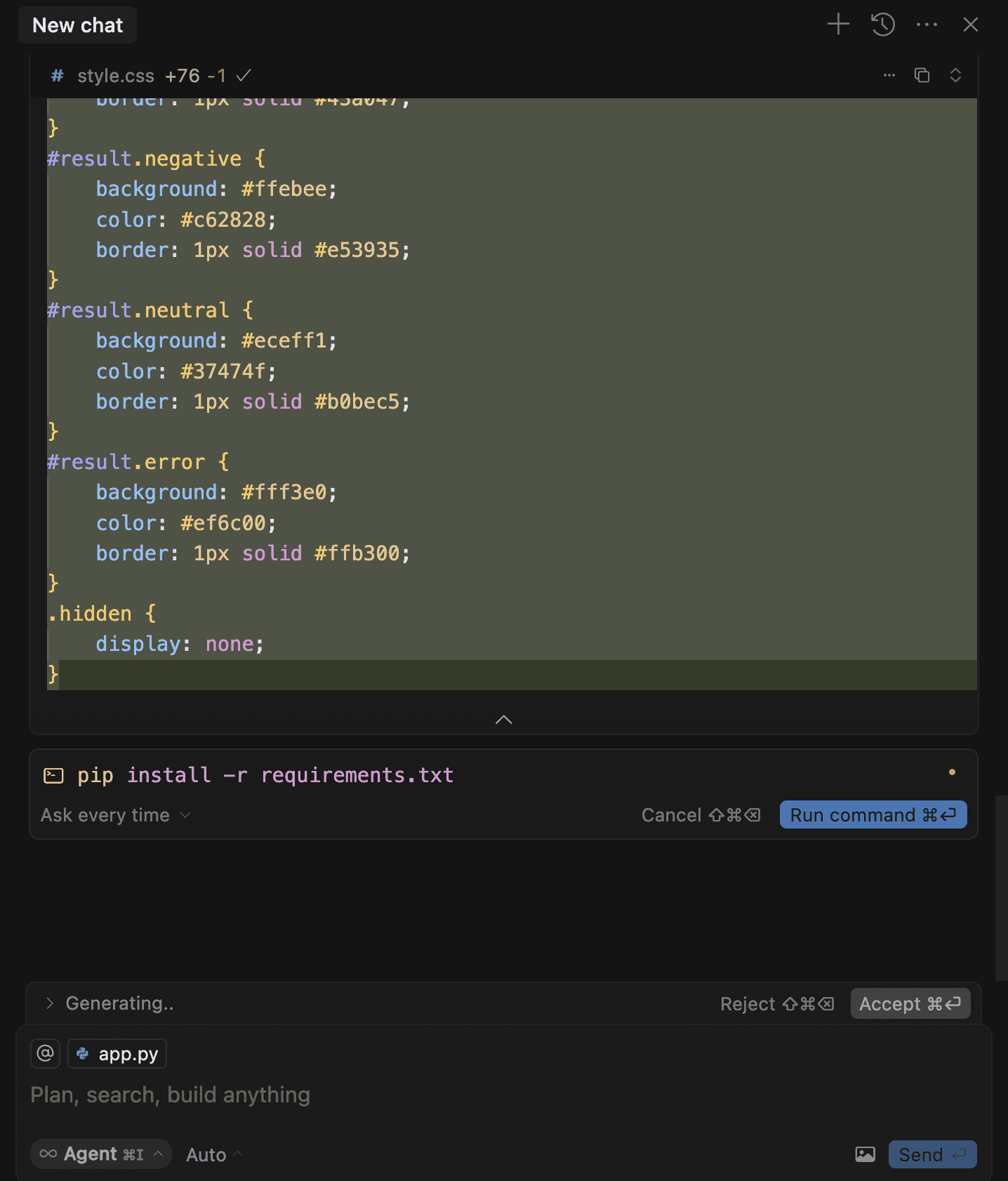

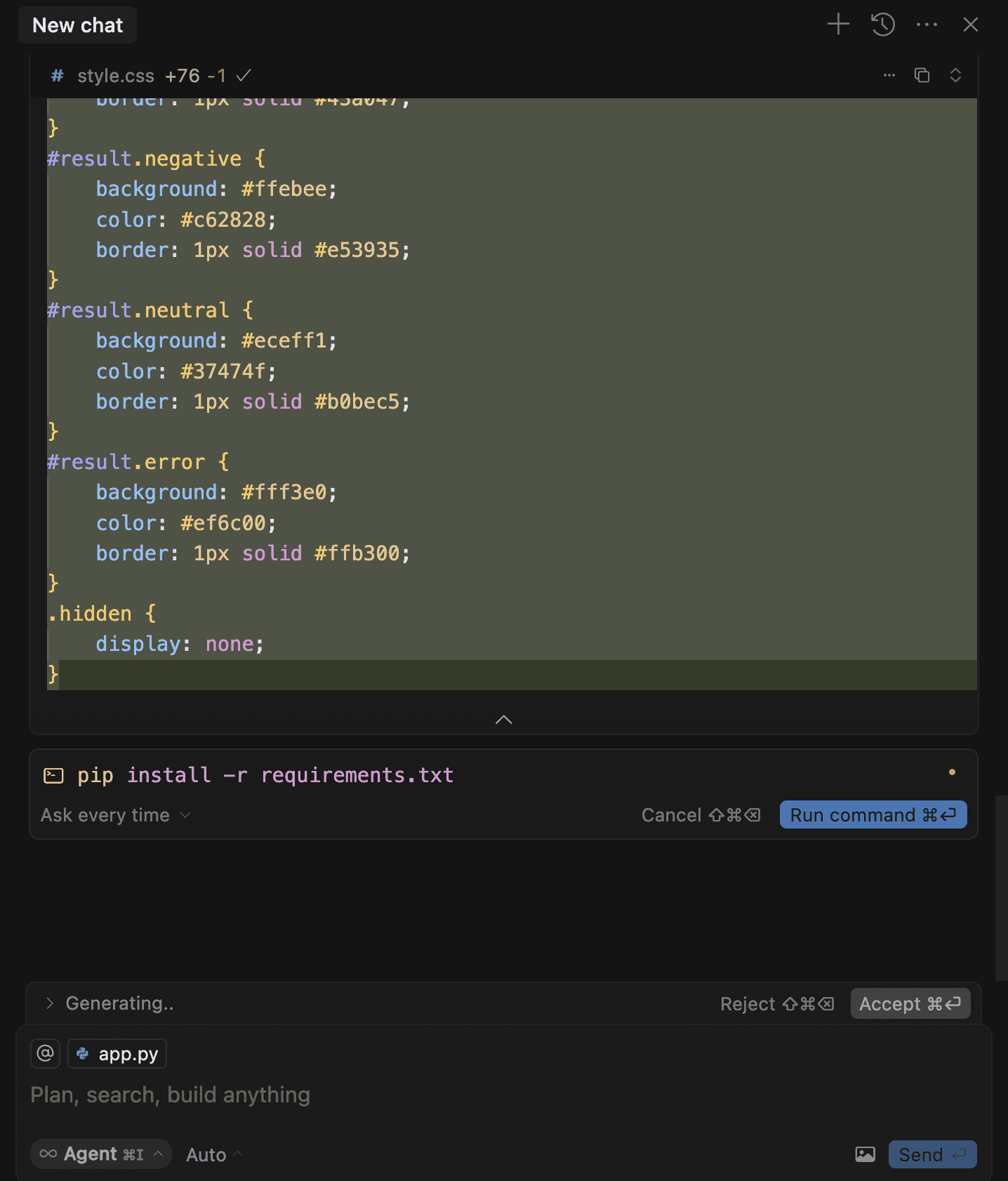

Étape 3: accepter les modifications et exécuter les commandes

Comme le curseur crée de nouveaux fichiers et génère du code, vous devez cliquer sur «Accepter» pour confirmer les modifications apportées par l’agent AI.

Une fois que Cursor a écrit tout le code, il pourrait vous inviter à exécuter certaines commandes sur le terminal. L’exécution de ces commandes vous permettra d’installer les dépendances requises et d’exécuter l’application Web.

Cliquez simplement sur «Exécuter», qui permet à Cursor d’exécuter ces commandes pour nous:

Exécuter le curseur de la commande

Une fois que le curseur a construit l’application, il vous dira de copier et coller ce lien dans votre navigateur:

Lien de l’application du curseur

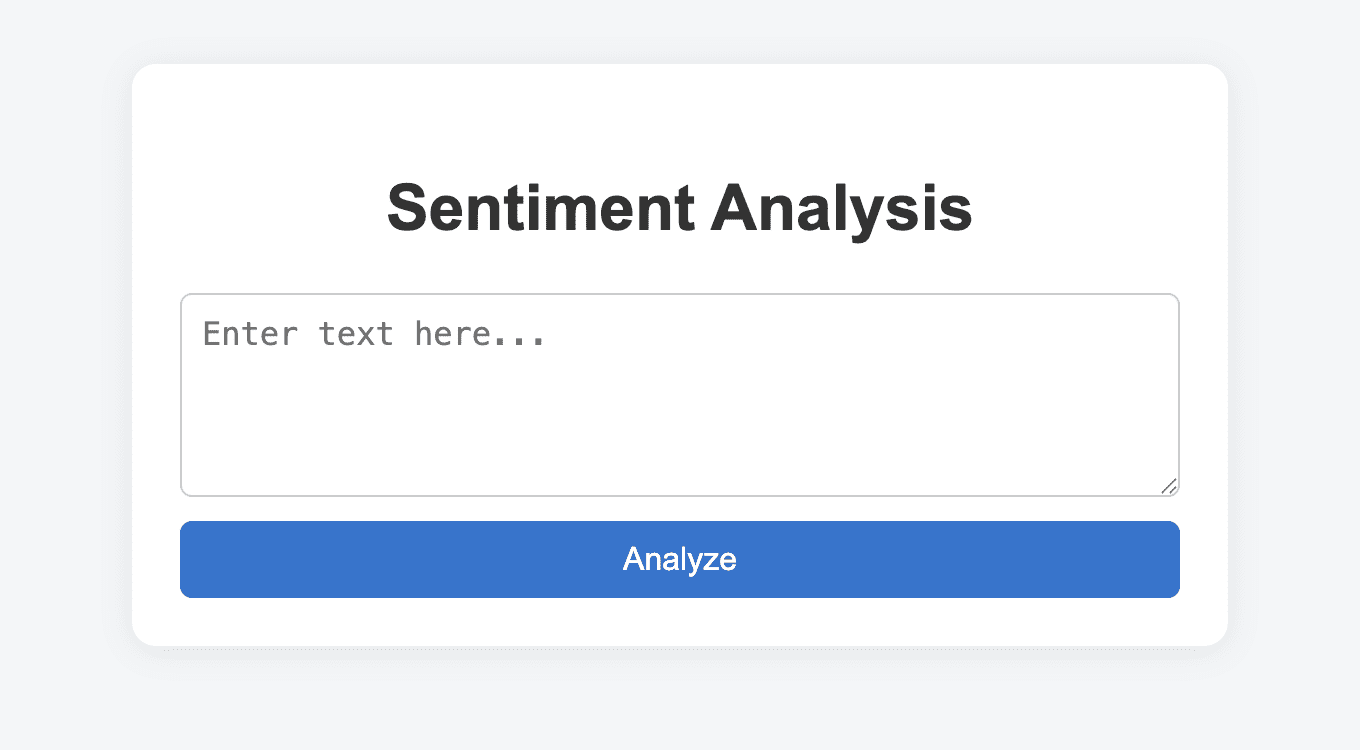

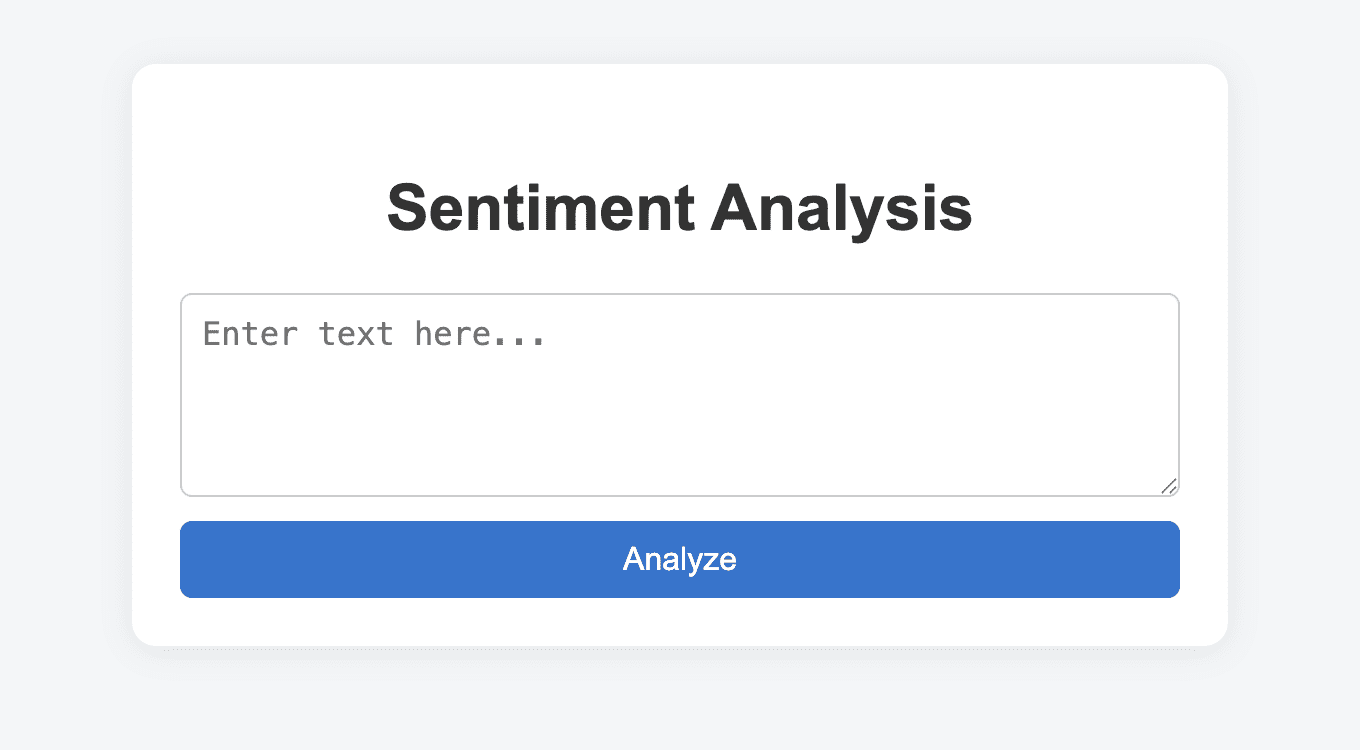

Cela vous mènera à l’application Web d’analyse du sentiment, qui ressemble à ceci:

Application d’analyse des sentiments avec curseur

Il s’agit d’une application Web à part entière avec laquelle les employeurs peuvent interagir. Vous pouvez coller n’importe quelle phrase dans cette application et il prédire le sentiment, en vous rendant un résultat.

Je trouve que des outils comme le curseur sont incroyablement puissants si vous êtes un débutant dans le domaine et que vous souhaitez produire vos projets.

La plupart des professionnels des données ne connaissent pas les langages de programmation frontaux comme HTML et CSS, en raison de laquelle nous ne pouvons pas présenter nos projets dans une application interactive.

Notre code se trouve souvent dans les cahiers de Kaggle, qui ne nous donne pas un avantage concurrentiel sur des centaines d’autres candidats faisant exactement la même chose.

Un outil comme le curseur, cependant, peut vous distinguer de la compétition. Cela peut vous aider à transformer vos idées en réalité en codant exactement ce que vous le dites.

Outil AI 2: Pandas AI

Pandas AI vous permet de manipuler et d’analyser les trames de données Pandas sans écrire de code.

Il vous suffit de taper des invites en anglais ordinaire, ce qui réduit la complexité qui vient avec la réalisation de données et EDA.

Si vous ne savez pas déjà, Pandas est une bibliothèque Python que vous pouvez utiliser pour analyser et manipuler des données.

Vous lisez des données sur quelque chose connu sous le nom de Pandas Data Frame, qui vous permet ensuite d’effectuer des opérations sur vos données.

Passons à un exemple de la façon dont vous pouvez effectuer le prétraitement des données, la manipulation et l’analyse avec Pandas AI.

Pour cette démo, j’utiliserai le Ensemble de données de prédiction de survie Titanic sur kaggle (téléchargez le train.csv déposer).

Pour cette analyse, je suggère d’utiliser un environnement de carnet Python, comme un cahier Jupyter, un ordinateur portable Kaggle ou Google Colab. Le code complet de cette analyse peut être trouvé dans Ce carnet de kaggle.

Étape 1: Installation et configuration de Pandas AI

Une fois que vous avez votre environnement de cahier prêt, saisissez la commande ci-dessous pour installer Pandas AI:

!pip install pandasai

Ensuite, chargez le Titanic DataFrame avec les lignes de code suivantes:

import pandas as pd

train_data = pd.read_csv('/kaggle/input/titanic/train.csv')

Importons maintenant les bibliothèques suivantes:

import os

from pandasai import SmartDataframe

from pandasai.llm.openai import OpenAI

Ensuite, nous devons créer un objet Pandas AI pour analyser l’ensemble de données de train Titanic.

Voici ce que cela signifie:

Pandas AI est une bibliothèque qui connecte votre trame de données Pandas à un modèle de langue large. Vous pouvez utiliser Pandas AI pour vous connecter à GPT-4O, Claude-3.5 et autres LLMS.

Par défaut, Pandas AI utilise un modèle de langue appelé Bamboo LLM. Pour connecter Pandas AI au modèle de langue, vous pouvez visiter ce site Web Pour obtenir une clé API.

Ensuite, entrez la touche API dans ce bloc de code pour créer un objet Pandas AI:

# Set the PandasAI API key

# By default, unless you choose a different LLM, it will use BambooLLM.

# You can get your free API key by signing up at https://app.pandabi.ai

os.environ('PANDASAI_API_KEY') = 'your-pandasai-api-key' # Replace with your actual key

# Create SmartDataframe with default LLM (Bamboo)

smart_df = SmartDataframe(train_data)

Personnellement, j’ai fait face à des problèmes dans la récupération de la clé API Bamboo LLM. Pour cette raison, j’ai décidé d’obtenir une clé API d’Openai à la place. Ensuite, j’ai utilisé le modèle GPT-4O pour cette analyse.

Une mise en garde de cette approche est que les clés de l’API d’Openai ne sont pas gratuites. Vous devez acheter des jetons API d’Openai pour utiliser ces modèles.

Pour ce faire, accédez à ouvrir le site Web de l’IA et acheter des jetons à partir du Page Billings. Alors vous pouvez aller au «Clés API» page et créez votre clé API.

Maintenant que vous avez la touche API OpenAI, vous devez l’entrer dans ce bloc de code pour connecter le modèle GPT-4O à Pandas AI:

# Set your OpenAI API key

os.environ("OPENAI_API_KEY") = "YOUR_API_KEY"

# Initialize OpenAI LLM

llm = OpenAI(api_token=os.environ("OPENAI_API_KEY"), model="gpt-4o")

config = {

"llm": llm,

"enable_cache": False,

"verbose": False,

"save_logs": True

}

# Create SmartDataframe with explicit configuration

smart_df = SmartDataframe(train_data, config=config)

Nous pouvons maintenant utiliser cet objet Pandas AI pour analyser l’ensemble de données Titanic.

Étape 2: EDA et prétraitement des données avec Pandas AI

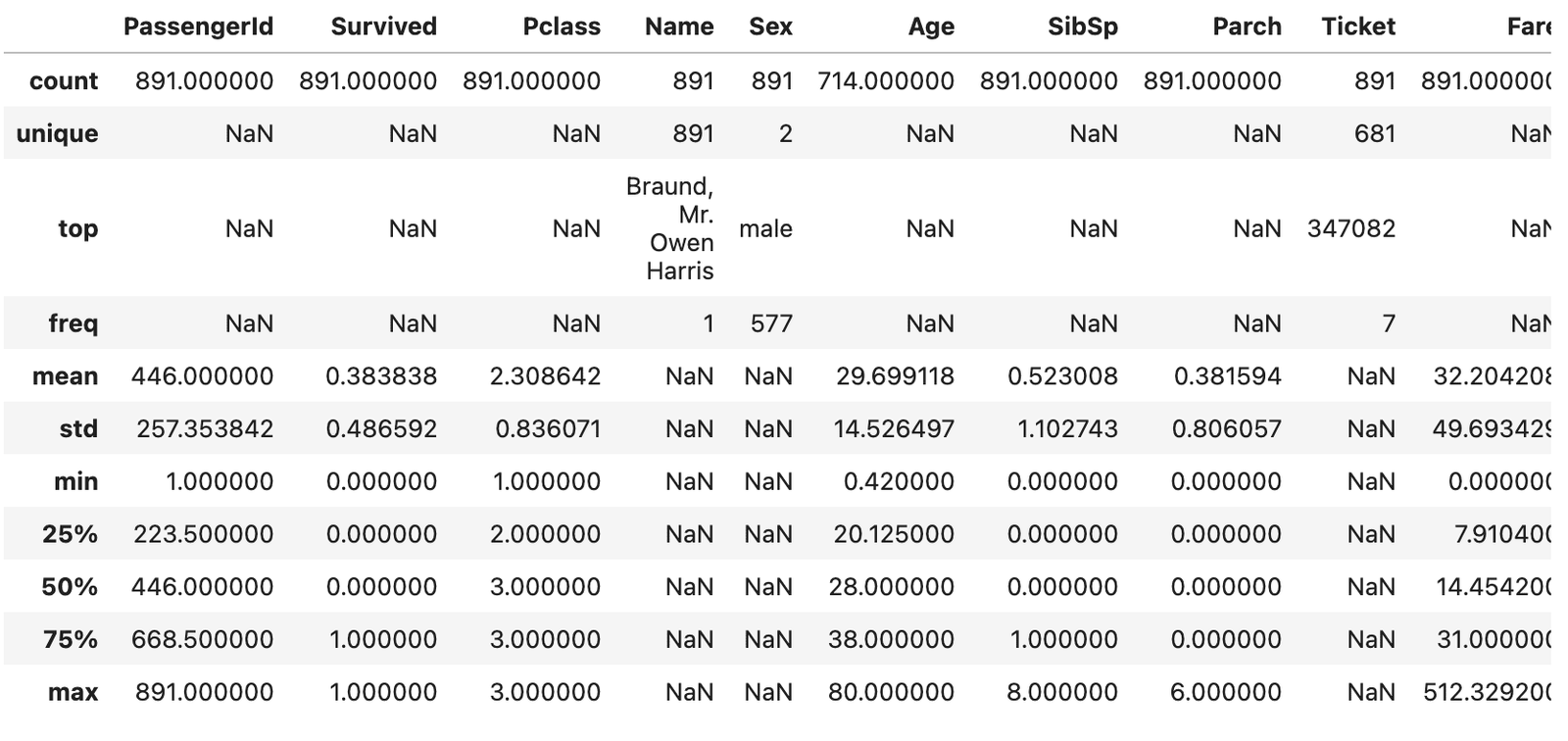

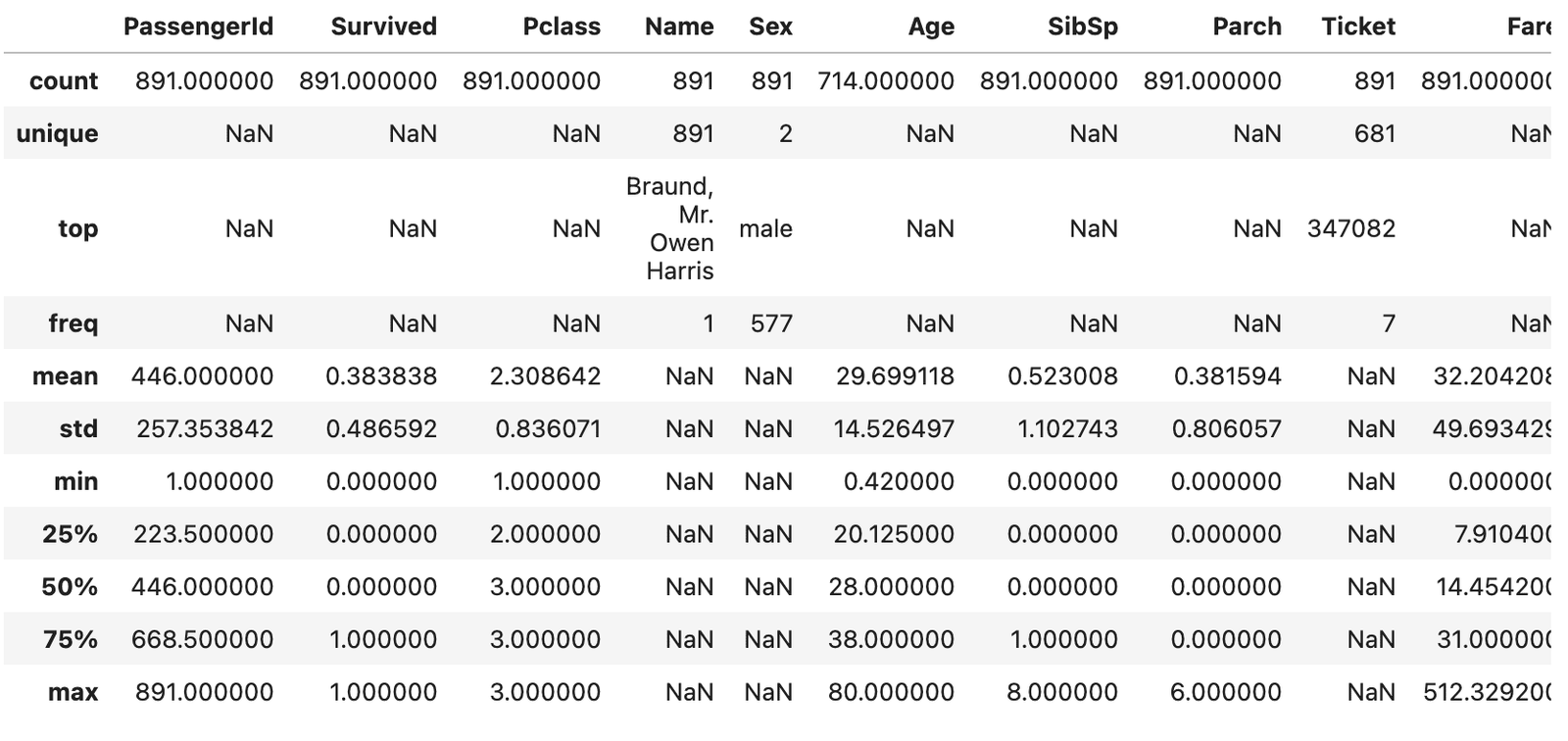

Tout d’abord, commençons par une simple invite demandant à Pandas AI de décrire cet ensemble de données:

smart_df.chat("Can you describe this dataset and provide a summary, format the output as a table.")

Vous verrez un résultat qui ressemble à ceci, avec un résumé statistique de base de l’ensemble de données:

Description de l’ensemble de données Titanic

En règle générale, nous écrivions du code pour obtenir un résumé comme celui-ci. Avec Pandas AI, cependant, nous avons juste besoin d’écrire une invite.

Cela vous fera économiser une tonne de temps si vous êtes un débutant qui souhaite analyser certaines données mais ne savez pas comment écrire du code Python.

Ensuite, effectuons une analyse des données exploratoires avec Pandas AI:

Je lui demande de me donner la relation entre la variable «survie» dans l’ensemble de données Titanic, ainsi que d’autres variables dans l’ensemble de données:

smart_df.chat("Are there correlations between Survived and the following variables: Age, Sex, Ticket Fare. Format this output as a table.")

L’invite ci-dessus devrait vous fournir un coefficient de corrélation entre «survivre» et les autres variables de l’ensemble de données.

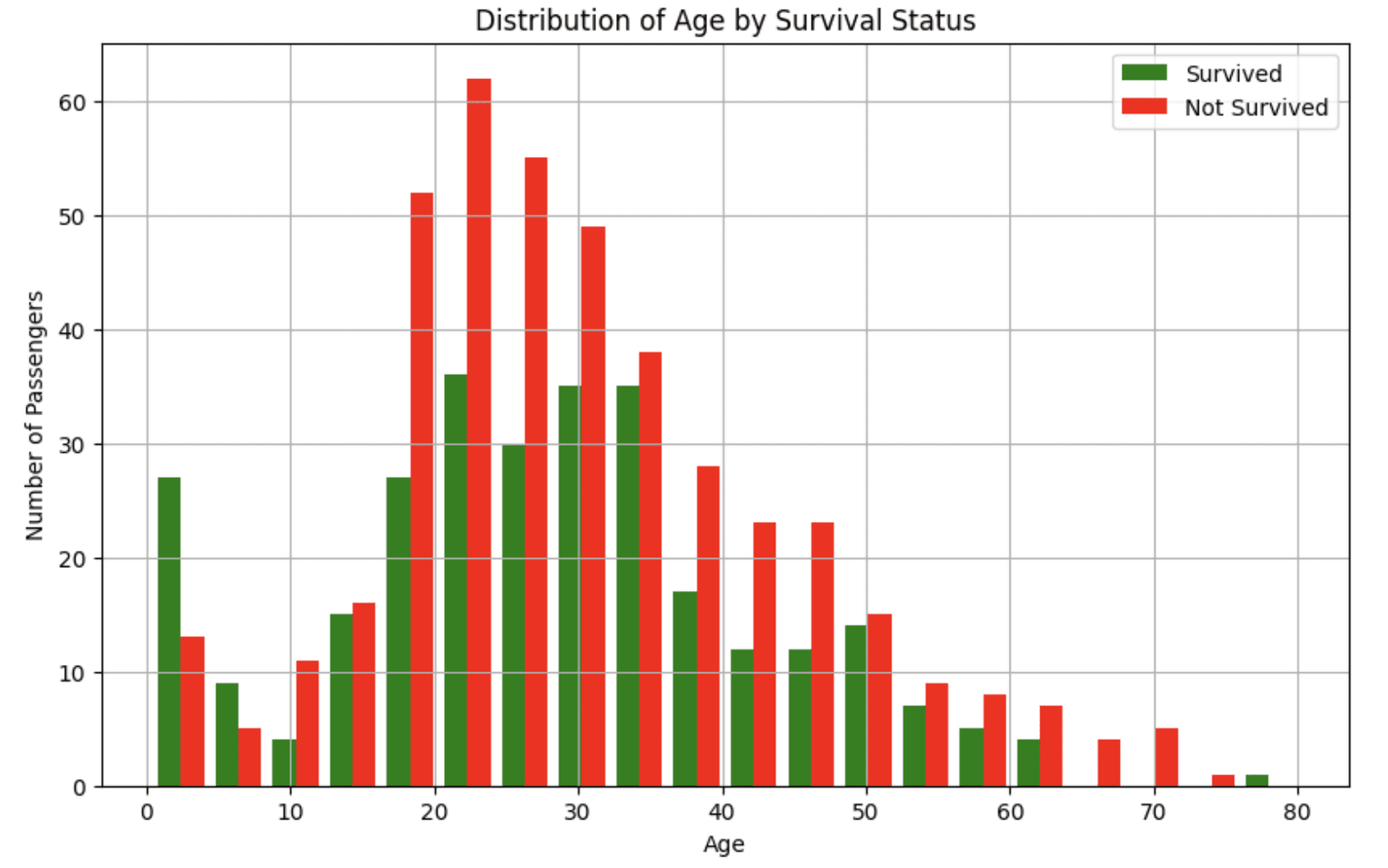

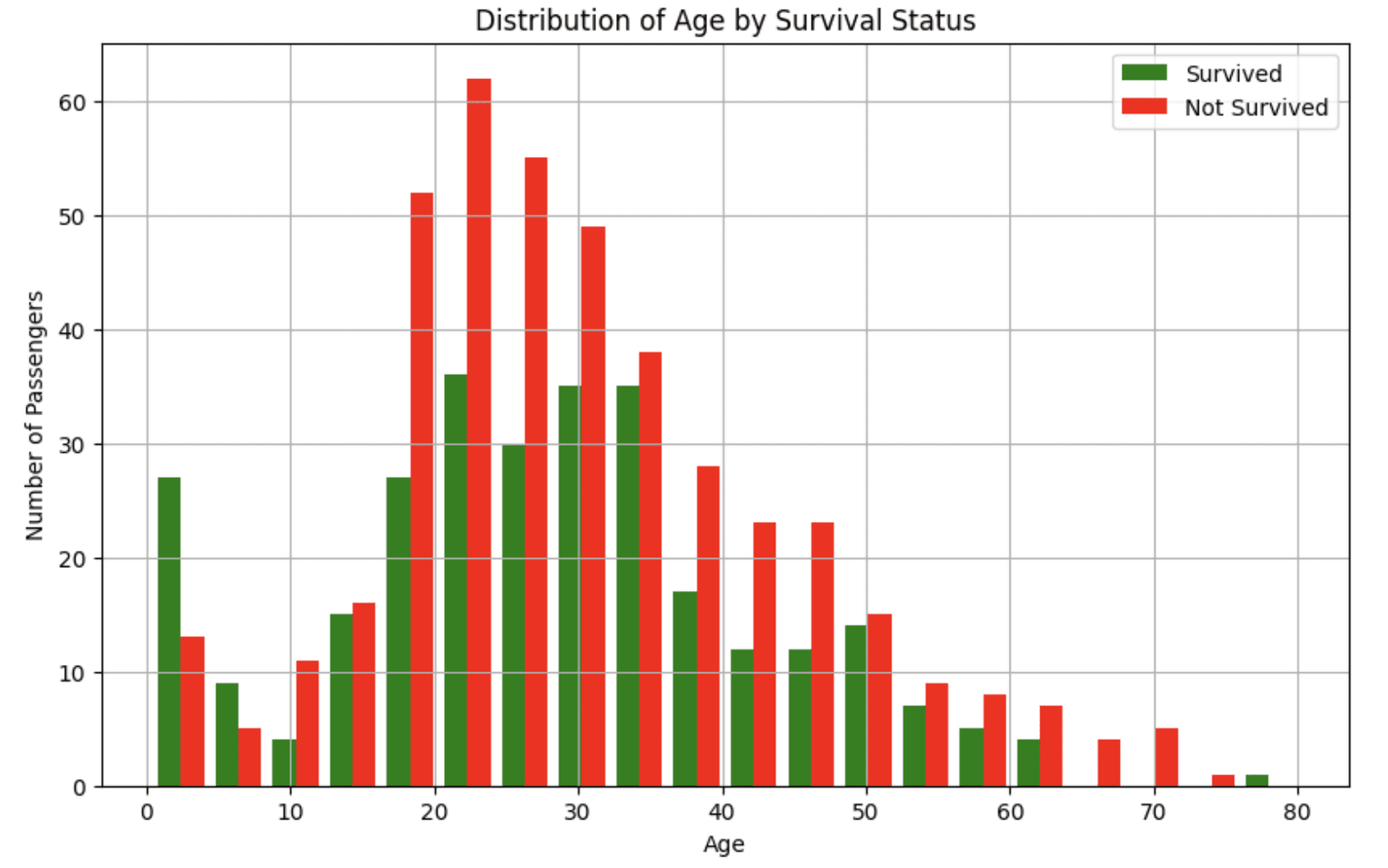

Ensuite, demandons à Pandas AI de nous aider à visualiser la relation entre ces variables:

1. A survécu et à l’âge

smart_df.chat("Can you visualize the relationship between the Survived and Age columns?")

L’invite ci-dessus devrait vous donner un histogramme qui ressemble à ceci:

Distribution de l’âge de l’ensemble de données Titanic

Ce visuel nous dit que les jeunes passagers étaient plus susceptibles de survivre à l’accident.

2. A survécu et sexe

smart_df.chat("Can you visualize the relationship between the Survived and Sex")

Vous devriez obtenir un graphique à barres présentant la relation entre «survécu» et «genre».

3. A survécu et tarif

smart_df.chat("Can you visualize the relationship between the Survived and Fare")

L’invite ci-dessus a rendu un complot de boîte, me disant que les passagers qui ont payé des prix plus élevés étaient plus susceptibles de survivre à l’accident du Titanic.

Notez que les LLM sont non déterministes, ce qui signifie que la sortie que vous obtiendrez peut différer du mien. Cependant, vous obtiendrez toujours une réponse qui vous aidera à mieux comprendre l’ensemble de données.

Ensuite, nous pouvons effectuer un prétraitement de données avec des invites comme celles-ci:

Exemple d’invite 1

smart_df.chat("Analyze the quality of this dataset. Identify missing values, outliers, and potential data issues that would need to be addressed before we build a model to predict survival.")

Exemple de l’invite 2

smart_df.chat("Let's drop the cabin column from the dataframe as it has too many missing values.")

Exemple d’invite 3

smart_df.chat("Let's impute the Age column with the median value.")

Si vous souhaitez passer par toutes les étapes de prétraitement que j’ai utilisées pour nettoyer cet ensemble de données avec Pandas AI, vous pouvez trouver les invites et le code complets dans mon Cahier de kaggle.

En moins de 5 minutes, j’ai pu prétraiter cet ensemble de données en gérant les valeurs manquantes, en codant pour les variables catégorielles et en créant de nouvelles fonctionnalités. Cela a été fait sans écrire beaucoup de code Python, ce qui est particulièrement utile si vous êtes nouveau dans la programmation.

Comment apprendre l’IA pour l’analyse des données: étapes suivantes

À mon avis, le principal argument de vente des outils comme Cursor et Pandas AI est qu’ils vous permettent d’analyser les données et de faire des modifications de code dans votre interface de programmation.

C’est bien mieux que d’avoir à copier et à coller le code de votre IDE de programmation dans une interface comme Chatgpt.

De plus, à mesure que votre base de code se développe (c’est-à-dire que si vous avez des milliers de lignes de code et plus de 10 ensembles de données), il est incroyablement utile d’avoir un outil d’IA intégré qui a tout le contexte et peut comprendre la connexion entre ces fichiers de code.

Si vous cherchez à apprendre l’IA pour l’analyse des données, voici quelques autres outils que j’ai trouvés utiles:

- Copilote github: Cet outil est similaire au curseur. Vous pouvez l’utiliser dans votre IDE de programmation pour générer des suggestions de code, et il a même une interface de chat avec laquelle vous pouvez interagir.

- Microsoft Copilot dans Excel: Cet outil d’IA vous aide à analyser automatiquement les données dans vos feuilles de calcul.

- Python dans Excel: Il s’agit d’une extension qui vous permet d’exécuter du code Python dans Excel. Bien que ce ne soit pas un outil d’IA, je l’ai trouvé incroyablement utile car il vous permet de centraliser votre analyse de données sans avoir à basculer entre différentes applications.

Natassha selvaraj est un scientifique des données autodidacte avec une passion pour l’écriture. Natassha écrit sur tout ce qui concerne les données liées à la science, un véritable maître de tous les sujets de données. Vous pouvez vous connecter avec elle Liendin ou regarde-la Chaîne YouTube.

Source link