Apprentissage automatique à l’échelle: Pourquoi Pyspark Mllib gagne toujours en 2025

Auteur (s): Yuval mehta

Publié à l’origine sur Vers l’IA.

Apprentissage automatique Peut être glamour lorsque vous réglez des modèles sur Kaggle ensembles de données ou faire des emballages GPT. Mais en production? C’est une mouture.

Vous ne construisez pas seulement un modèle. Vous construisez un système, celui qui prend des données non filtrées d’utilisateurs réels, les transforme à travers des nœuds distribués, forme un modèle qui ne s’écrase pas à mi-parcours et pousse les prédictions sur une base quotidienne ou même horaire. Et c’est là que Pyspark Mllib brille, non pas comme un outil de modélisation, mais comme une infrastructure.

Mllib en 2025: pas seulement survivre, toujours à l’échelle

Pyspark Mllib n’est pas flashy. Il ne vous donnera pas toutes les astuces d’architecture ou d’ensemble de pointe moderne. Mais il gère toujours ce que 90% de l’entreprise apprentissage automatique On dirait réellement: ensembles de données massifs, formation reproductible emploispipelines cohérents et échelle sans excuses.

Construit directement sur le moteur de Spark, le levier des pipelines Mllib:

- Dataframe Apis (pas plus de RDD),

- Transformations déclaratives à travers les nœuds,

- Gestion automatique de la mémoire et des partitionset

- Outils de réglage et d’évaluation du modèle intégré.

Tout cela fonctionne nativement sur des grappes distribuées. Pas d’emballages. Pas de hacks. Juste une infrastructure qui a été testée au combat depuis une décennie.

Les pipelines sont le produit

Oubliez le modèle pendant une seconde.

Ce que vous voulez vraiment en production est un pipeline. Quelque chose de fiable:

- Ingère 100 m et plus de lignes de données brutes,

- Featuries, Encodes, Scales et les rejoint,

- Entraîne des modèles de manière distribuée, et

- Sorte les prédictions sans se décomposer sur la dérive, l’échelle ou le temps.

C’est le produit. Pas les poids du modèle. Pas le Validation AUC. Le pipeline de bout en bout.

Les pipelines Mllib vous permettent de déclarer tout ce flux. Chaque étape, de StringIndexer à LogisticRegressiondevient une étape. Ces étapes s’adaptent, se transforment et évaluent à grande échelle, sans vous forcer à coiffer la main sur chaque pièce. Plus important encore, ils sont réutilisable, sauvage et déployable. Aucune copie de copie des cahiers aux planificateurs de travail.

Pourquoi l’échelle exige un état d’esprit différent

Voici la chose que la plupart des équipes se trompent lors du passage de Scikit-Learn à Mllib:

Ils traitent l’échelle comme un problème matériel, pas comme un problème système.

Mais lorsque vous passez de 100 000 enregistrements à 100 millions, tout change:

- Les jointures en mémoire se décomposent.

collect()appelle les chauffeurs de crash.- Vous ne pouvez pas suivre la lignée sur les fonctions artisanales.

- Les incohérences de dérive de caractéristiques, de biais et de pipeline détruisent la reproductibilité.

Mllib vous oblige à penser différemment. Il récompense pipelines déclaratifs, Définitions cohérentes du schémaet Linion des fonctionnalités propres. Non pas parce qu’il est opiniâtre, mais parce qu’il sait ce qui se passe lorsque les systèmes deviennent grands.

2025 Mises à niveau qui comptent réellement

Spark a évolué tranquillement et intelligemment. Si vous n’avez pas touché Mllib depuis quelques années, voici ce qui est nouveau et mérite d’être noté:

API Unified Dataframe uniquement

L’ancien MLLIB basé sur RDD est déconseillé depuis longtemps. Tout est maintenant construit sur l’optimiseur de catalyseur de Spark SQL, ce qui signifie que les transformations sont plus rapide, plus sûr et conscient de la mémoire.

Exécution de la requête adaptative (AQE)

Spark 3.5+ optimise votre pipeline au moment de l’exécution. Il peut changer les stratégies de jonction, rééquilibrer les partitions et s’adapter à Sckew en fonction des caractéristiques réelles des données, pas seulement de ce que vous avez supposé.

Support Pandas UDF

Oui, vous pouvez maintenant écrire Pandas UDFS dans votre pipeline. Cela signifie que vous pouvez brancher la logique personnalisée sans abandonner l’exécution distribuée. Un terrain d’entente rare et bienvenu entre facilité et échelle.

Accélération du GPU

Avec DeepspeedTorchDistributor et l’intégration unifiée de l’exécuteur GPUS distribués. Cela amène Pytorch dans Spark Workflows, sans réécrire des pipelines.

Un cas d’utilisation qui frappe dur: la prédiction de désabonnement pour 50 mètres

Soyons concrets, pas de code, juste un contexte.

Vous travaillez dans une opération de télécommunications. Tu as:

- Journaux d’utilisation quotidiens (1 To +),

- Résumé des résumés de chat (semi-structurés),

- Informations sur l’abonnement et la facturation (relationnelle),

- Et un modèle pour prédire le désabonnement du client avant qu’il ne se produise.

Ce que Mllib vous donne:

- Structure de pipeline Pour encoder toutes vos variables catégorielles auprès de millions d’utilisateurs,

- Assembleurs vectoriels Pour suivre les fonctionnalités proprement,

- Intervalidateur pour tester plusieurs

regParametelasticNetParamvaleurs, de manière distribuée, - Et une finale

.fit()Cela ne se termine pas seulement, mais le fait sans faire exploser la mémoire.

Votre pipeline fonctionne quotidiennement. Il remet en charge automatiquement. Il enregistre à chaque étape. Et parce qu’il est enregistré comme un seul objet MLIB, il peut être chargé demain, recyclé la semaine prochaine et servi via des travaux de lot MLFlow ou personnalisés.

Ce n’est pas de la science-fiction. C’est ce que les entreprises font tous les jours, avec Mllib sous le capot.

Ce que Mllib n’est pas (et ça va)

Pour être clair, Mllib n’est pas parfait.

- Il n’a pas Catboost ou LightGBM.

- Vous ne trouverez pas de filets neuronaux de pointe.

- Les boucles de formation personnalisées sont plus difficiles à écrire.

- Sa verbosité peut être ennuyeuse pour le prototypage.

Mais c’est le prix que vous payez pour l’échelle. Mllib n’est pas une question de brillant. Il s’agit de stabilité. Si vous avez besoin de transformateurs, d’incorporation affinée ou de généralisation de zéro, utilisez la face étreinte.

Mais si votre système ML doit gérer des milliards de lignes, s’exécuter sans faute et s’intégrer directement à votre lac de données, MLLIB est toujours inégalé.

Le réglage n’est pas un bon à have – c’est requis

La plupart des équipes qui se plaignent de MLIB sont «sous-performantes» ont sauté cette partie.

Mllib est livré avec natif CrossValidator et TrainValidationSplit. Utilisez-les.

Configurez les grilles de paramètre. Laissez paralléliser et évaluez plusieurs modèles. Bien sûr, cela prend du temps, mais cela vous évite l’expédition d’un modèle fragile qui fonctionne très bien dans votre cahier et échoue dans la nature.

MLIB soutient également l’évaluation du modèle avec:

BinaryClassificationEvaluatorMulticlassClassificationEvaluatorRegressionEvaluator

Ces évaluateurs calculent les mesures en distributionsans avoir besoin de tirer des prédictions sur un seul nœud.

À grande échelle, c’est la survie.

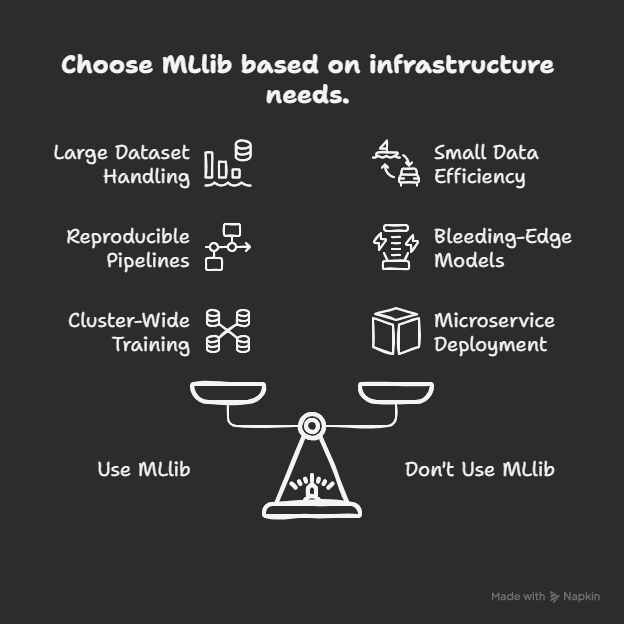

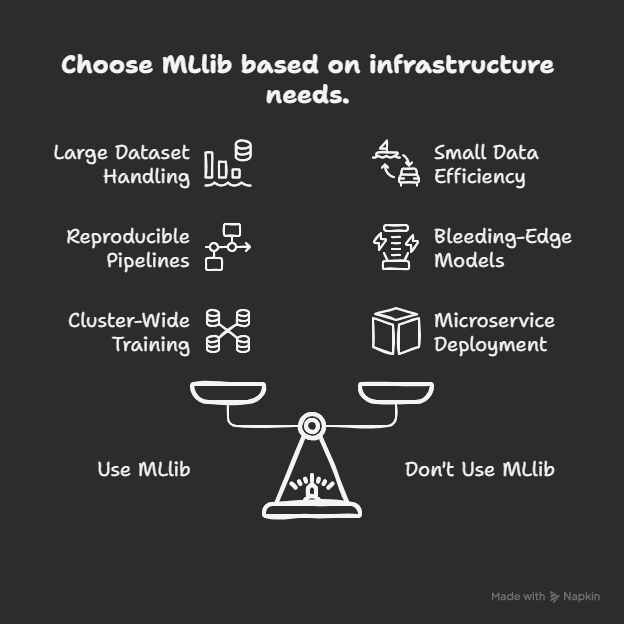

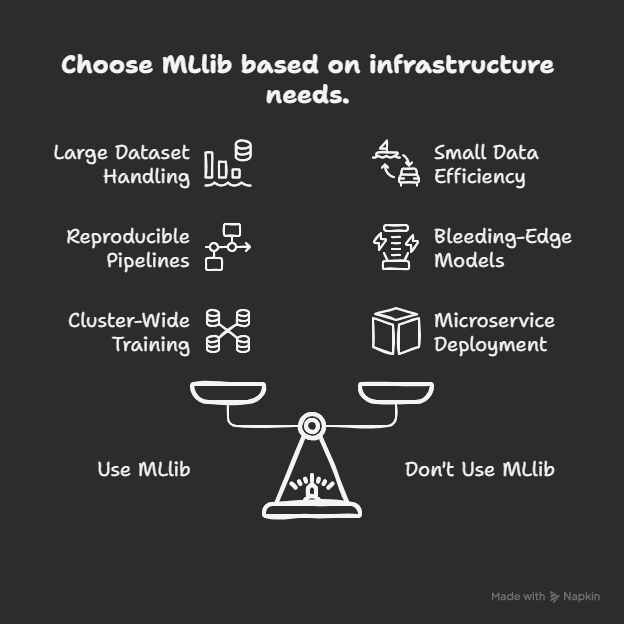

Quand utiliser mllib (et quand ne pas)

📈 Utilisez Mllib lorsque:

- Votre ensemble de données ne tient pas dans la mémoire

- Vous voulez une reproductibilité complète du pipeline

- Vous travaillez avec Spark de toute façon (ETL + Modélisation)

- Vous avez besoin d’une formation et d’une validation à l’échelle des grappes

- Tolérance aux pannes et orchestration de l’emploi

🧪 N’utilisez pas de mllib lorsque:

- Vous avez besoin d’architecture de saignement

- Vos données sont petites et en mouvement rapide

- Vous déployez des microservices ou des modèles affinés avec une logique d’inférence personnalisée

Mllib n’est pas toujours le meilleur ajustement. Mais quand il s’adapte, il s’adapte comme des infrastructures.

Mllib n’est pas l’avenir de ML – c’est la fondation

Les outils vont et viennent. Les API du modèle évoluent. Mais des pipelines? Les pipelines restent.

Et Pyspark Mllib vous donne une structure de pipeline construite pour durer à travers les versions, à travers les transferts d’équipe, à travers les dérives de données et les pannes de production.

Ce n’est pas glamour. Ce n’est pas excité. Mais lorsque vous êtes sur appel à 2 heures du matin, essayez de comprendre pourquoi votre modèle de désabonnement s’est cassé après un changement de schéma, le flux déclaratif, testable et traçable de Mllib ressemblera à la décision la plus intelligente que vous ayez prise toute l’année.

📚 Ressources pour l’ingénieur MLLIB moderne

Publié via Vers l’IA

Source link