Applications du marché financier des LLM

La révolution de l’IA a conduit des investissements frénétiques dans des entreprises privées et publiques et a capturé l’imagination du public en 2023. Les produits de consommation transformationnels comme Chatgpt sont alimentés par des modèles de grande langue (LLM) qui excellent dans la modélisation des séquences de jetons qui représentent des mots ou des parties de mots (2). Étonnamment, la compréhension structurelle émerge de l’apprentissage de la prédiction à côté, et les agents sont capables de terminer des tâches telles que la traduction, la réponse aux questions et la génération de prose humaine à partir de simples invites d’utilisateurs.

Sans surprise, les commerçants quantitatifs ont demandé: Pouvons-nous transformer ces modèles en prédiction de prix ou commercial suivant (1,9,10)? Autrement dit, plutôt que de modéliser des séquences de mots, pouvons-nous modéliser des séquences de prix ou de métiers. Cela s’avère être une ligne d’enquête intéressante qui révèle beaucoup sur la modélisation générative des séries temporelles de l’IA et de la finance. Soyez averti que cela deviendra bancal.

Les LLM sont connues sous le nom d’apprenants autorégressifs – ceux qui utilisent des jetons ou des éléments précédents dans une séquence pour prédire l’élément ou jeton suivant. Dans le commerce quantitatif, par exemple dans des stratégies telles que l’arbitrage statistique dans les actions, la plupart des recherches concernent l’identification de la structure autorégressive. Cela signifie trouver des séquences de nouvelles ou de commandes ou des changements fondamentaux qui prédisent le mieux les prix futurs.

Où les choses se décomposent se trouvent dans la quantité et le contenu de l’information des données disponibles pour former les modèles. At the 2023 NeurIPS conference, Hudson River Trading, a high frequency trading firm, presented a comparison of the number of input tokens used to train GPT-3 with the amount of trainable tokens available in the stock market data per year HRT estimated that, with 3,000 tradable stocks, 10 data points per stock per day, 252 trading days per year, and 23400 seconds in a trading day, there are 177 billion stock market tokens per year Disponible en tant que données de marché. GPT-3 a été formé sur 500 milliards de jetons, donc pas loin (6).

Mais, dans le contexte de trading, les jetons seront des prix, des rendements ou des métiers plutôt que des syllabes ou des mots; Le premier est beaucoup plus difficile à prévoir. La langue a une structure linguistique sous-jacente (par exemple, grammaire) (7). Il n’est pas difficile d’imaginer un humain prédisant le mot suivant d’une phrase, mais ce même humain trouverait extrêmement difficile de prédire le prochain retour compte tenu d’une séquence de métiers précédents, d’où le manque de commerçants de jour milliardaires. Le défi est qu’il y a des gens très intelligents qui rivalisent tout signal sur le marché, ce qui en fait presque Efficace («efficacement inefficace», selon les mots de l’économiste Lasse Pedersen) et donc imprévisible. Aucun adversaire n’essaie activement de rendre les peines plus difficiles à prévoir – si quoi que ce soit, les auteurs cherchent généralement à rendre leurs phrases faciles à comprendre et donc à plus prévisible.

Regardé sous un autre angle, il y a beaucoup plus de bruit que de signal dans les données financières. Les individus et les institutions négocient pour des raisons qui pourraient ne pas être rationnelles ou liées à un changement fondamental dans une entreprise. L’épisode GameStop en 2021 en est un exemple. Les séries chronologiques financières changent également constamment avec de nouvelles informations fondamentales, des changements réglementaires et des changements macroéconomiques occasionnels tels que les dévaluations de la monnaie. La langue évolue à un rythme beaucoup plus lent et plus de plus longs horizons de temps.

D’un autre côté, il y a des raisons de croire que les idées de l’IA fonctionneront bien sur les marchés financiers. Un domaine émergent de la recherche sur l’IA avec des applications prometteuses à la finance est l’apprentissage multimodal (5), qui vise à utiliser différentes modalités de données, par exemple les images et les entrées textuelles pour créer un modèle unifié. Avec le modèle DALL-E 2 d’OpenAI, un utilisateur peut entrer du texte et le modèle générera une image. En finance, les efforts multimodaux pourraient être utiles pour combiner des informations classiques d’informations telles que les données techniques de séries chronologiques (prix, métiers, volumes, etc.) avec des données alternatives dans différents modes tels que le sentiment ou les interactions graphiques sur Twitter, les articles de presse du langage naturel et les rapports d’entreprise, ou les images de satellite d’activité de livraison dans un port central en matière de marchandise. Ici, en tirant parti de l’IA multimodale, on pourrait potentiellement intégrer tous ces types d’informations non prix pour bien prédire.

Une autre stratégie appelée «résidalisation» soutient une importance dans la finance et l’IA, bien qu’elle assume des rôles différents dans les deux domaines. En finance, les modèles de «facteurs» structurels décomposent les observations contemporaines des rendements à travers différents actifs en une composante partagée (le rendement du marché, ou plus généralement des rendements de facteurs communs et à l’échelle du marché) et un composant idiosyncrasique unique à chaque atout sous-jacent. Les rendements du marché et des facteurs sont difficiles à prévoir et à créer l’interdépendance, il est donc souvent utile de supprimer l’élément commun lors de la prédiction au niveau de l’actif individuel et de maximiser le nombre d’observations indépendantes dans les données.

Dans les architectures de réseau résiduelles telles que les transformateurs, il y a une idée similaire que nous voulons apprendre une fonction h (x) d’une entrée x, mais il pourrait être plus facile d’apprendre le résidu de H (x) à la carte d’identité, c’est-à-dire H (x) – X. Ici, si la fonction H (x) sera proche et que l’apprentissage sera fait plus efficace. Dans les deux cas, l’objectif est d’exploiter la structure pour affiner les prédictions: dans le cas des finances, l’idée est de se concentrer sur la prédiction des innovations au-delà de ce qui est impliqué par le marché global, pour les réseaux résiduels que l’accent est mis sur la prédiction des innovations sur la carte d’identité.

Un ingrédient clé pour les performances impressionnantes du travail LLMS est leur capacité à discerner les affinités ou les forces entre les jetons sur de longs horizons appelés fenêtres de contexte. Sur les marchés financiers, la capacité de concentrer l’attention sur de longs horizons permet une analyse des phénomènes à plusieurs échelles, avec certains aspects des changements de marché expliqués à travers des horizons temporels très différents. Par exemple, à un extrême, des informations fondamentales (par exemple, le bénéfice) peuvent être intégrées à des prix au cours des mois, les phénomènes techniques (par exemple, l’élan) peuvent être réalisés au fil des jours et, à l’autre, les phénomènes de microstructure extrêmes (par exemple, déséquilibre du livre de commande) peuvent avoir un horizon temporel de secondes à quelques minutes.

La capture de tous ces phénomènes implique une analyse de plusieurs horizons temporels à travers la fenêtre de contexte. Cependant, en finance, la prédiction sur plusieurs avenir Les horizons temporels sont également importants. Par exemple, un système quantitatif peut chercher à échanger pour profiter de plusieurs anomalies différentes qui sont réalisées sur plusieurs horizons de temps (par exemple, en pariant simultanément sur un événement de microstructure et un événement de bénéfices). Cela nécessite de prédire non seulement le rendement de la période suivante du stock, mais la structure entière du terme ou la trajectoire des rendements attendus, tandis que les modèles prédictifs de style transformateur actuel ne recherchent qu’une seule période à l’avenir.

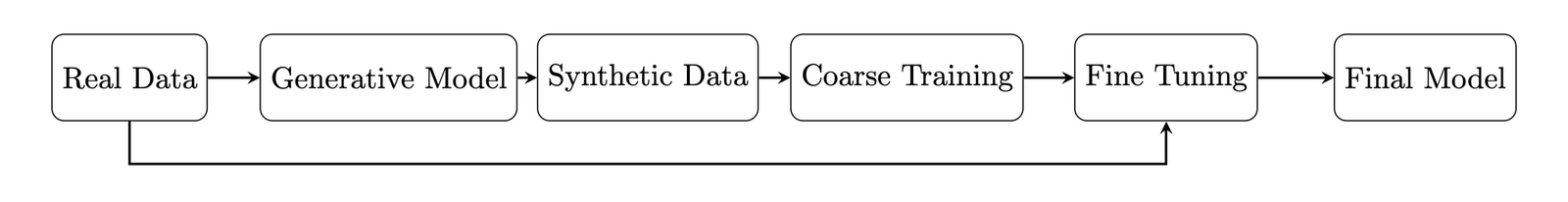

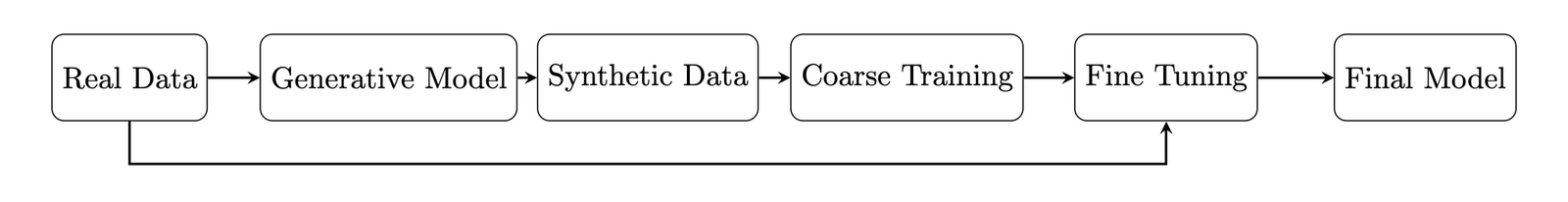

Une autre application du marché financier des LLM pourrait être la création de données synthétiques (4,8). Cela pourrait prendre quelques instructions. Des trajectoires simulées des cours des actions peuvent être générées qui imitent les caractéristiques observées sur le marché et peuvent être extrêmement bénéfiques étant donné que les données du marché financier sont rares par rapport à d’autres sources, comme le souligne ci-dessus dans le nombre de jetons disponibles. Les données artificielles pourraient ouvrir la porte aux techniques de méta-apprentissage qui ont été appliquées avec succès, par exemple en robotique. Dans le cadre robotique, les contrôleurs sont d’abord formés en utilisant des simulateurs de physique bon marché mais pas nécessairement précis, avant d’être mieux calibrés à l’aide d’expériences réelles coûteuses avec des robots. En finance, les simulateurs pourraient être utilisés pour former et optimiser grossièrement les stratégies de trading. Le modèle apprendrait des concepts de haut niveau comme l’aversion au risque et la diversification et les concepts tactiques tels que le commerce lentement pour minimiser l’impact des prix d’un métier. Ensuite, des données précieuses sur le marché réel pourraient être utilisées pour affiner les prédictions et déterminer précisément la vitesse optimale de commerce.

Les praticiens du marché financier s’intéressent souvent aux événements extrêmes, les moments où les stratégies de trading sont plus susceptibles de subir des gains ou des pertes importants. Des modèles génératifs où il est possible d’échantillonner à partir de scénarios extrêmes pourraient trouver une utilisation. Cependant, les événements extrêmes se produisent par définition rarement et donc la détermination des bons paramètres et l’échantillonnage des données de la distribution correspondante sont lourds.

Malgré le scepticisme selon lequel les LLM trouveront l’utilisation dans le commerce quantitatif, ils pourraient stimuler l’analyse fondamentale. À mesure que les modèles d’IA s’améliorent, il est facile de les imaginer aider les analystes à affiner une thèse d’investissement, à découvrir des incohérences dans les commentaires de la gestion ou à trouver des relations latentes entre les industries tangentielles et les entreprises (3). Essentiellement, ces modèles pourraient fournir un Charlie Munger à chaque investisseur.

Ce qui est surprenant à propos de la révolution générative de l’IA actuelle, c’est qu’il a fallu presque tout le monde – des chercheurs universitaires, des entreprises technologiques de pointe et des observateurs de longue date – par surprise. L’idée que la construction de modèles de plus en plus grands conduirait à des capacités émergentes comme nous le voyons aujourd’hui était totalement inattendue et ne comprenait toujours pas complètement.

Le succès de ces modèles d’IA a suralimenté le flux de capitaux humains et financiers dans l’IA, ce qui devrait à son tour conduire à des modèles encore meilleurs et plus capables. Ainsi, bien que le cas pour les modèles de GPT-4 qui prennent le contrôle de trading quantitatif soit actuellement peu probable, nous préconisons de garder l’esprit ouvert. S’attendre à ce que l’inattendu a été un thème rentable dans l’entreprise d’IA.

Références

- «Appliquer des réseaux de neurones profonds aux prévisions de séries chronologiques financières» Allison Koenecke. 2022

- « L’attention est tout ce dont vous avez besoin. » A Vaswani, N Shazeer, N Parmar, J Uszkoreit, L Jones… Advances in Neural Information Processing Systems, 2017

- «Les mouvements des cours des actions peuvent-ils prévoir les mouvements des cours? Retour prévisibilité et modèles de langue importants ». Lopez-Lira, Alejandro et Tang, Yuehua, (6 avril 2023) disponible chez SSRN

- « Générer des données synthétiques en finance: opportunités, défis et pièges. » SA Assefa, D Dervic, M Mahfouz, Re Tillman… – Actes de la première conférence internationale ACM…, 2020

- « Carte système GPT-4V (ISION). » Openai. Septembre 2023

- « Les modèles de langue sont des apprenants à quelques tirs. » T Brown, B Mann, N Ryder, M Subbiah, JD Kaplan… – Advances in Neural Information Processing Systems, 2020

- «La séquence à l’apprentissage des séquences avec les réseaux de neurones.» I.Sutskever, O.Vinyals et QVLE dans Advances in Neural Information Processing Systems, 2014, pp. 3104–3112.

- «Génération de données synthétiques pour les économistes». A Koenecke, H Varian – Arxiv Preprint Arxiv: 2011.01374, 2020

- CC Moallemi, M. Wang. Une approche d’apprentissage de renforcement de l’exécution optimale. Finance quantitative, 22 (6): 1051–1069, mars 2022.

- C. Maglaras, CC Moallemi, M. Wang. Une approche d’apprentissage en profondeur pour estimer les probabilités de remplissage dans un carnet de commandes de limite. Finance quantitative, 22 (11): 1989-2003, octobre 2022.

Citation

Pour l’attribution dans des contextes ou des livres académiques, veuillez citer ce travail comme

Richard Dewey and Ciamac Moallemi, "Financial Market Applications of LLMs," The Gradient, 2024@article{dewey2024financial,

author = {Richard Dewey and Ciamac Moallemi},

title = {Financial Market Applications of LLMs},

journal = {The Gradient},

year = {2024},

howpublished = {\url{https://thegradient.pub/financial-market-applications-of-llms},

}Source link