Anthropic explore comment Claude « pense »

Il peut être difficile de déterminer à quel point l’IA génératrice arrive à sa sortie.

Le 27 mars, Anthropic a publié un article de blog présentant un outil à rechercher dans un modèle de langue large pour suivre son comportement, cherchant à répondre à des questions telles que dans quelle langue son modèle «pense», que le modèle prévoit ou prédit un mot à la fois, et que les propres explications de l’IA de son raisonnement reflètent réellement ce qui se passe sous la capuche.

Dans de nombreux cas, l’explication ne correspond pas au traitement réel. Claude génère ses propres explications pour son raisonnement, de sorte que ces explications peuvent également présenter des hallucinations.

Un «microscope» pour la «biologie de l’IA»

Anthropic a publié un article sur «Mapping» Structures internes de Claude en mai 2024, et son nouvel article sur la description des «fonctionnalités» qu’un modèle utilise pour relier les concepts ensemble suit ce travail. Anthropic appelle sa recherche partie du développement d’un «microscope» en «biologie de l’IA».

Dans le premier article, les chercheurs anthropiques ont identifié des «caractéristiques» connectées par des «circuits», qui sont des chemins de l’entrée de Claude à la sortie. Le Deuxième article axé sur Claude 3.5 haïkuexaminant 10 comportements à schémas sur la façon dont l’IA arrive à son résultat. Anthropic trouvé:

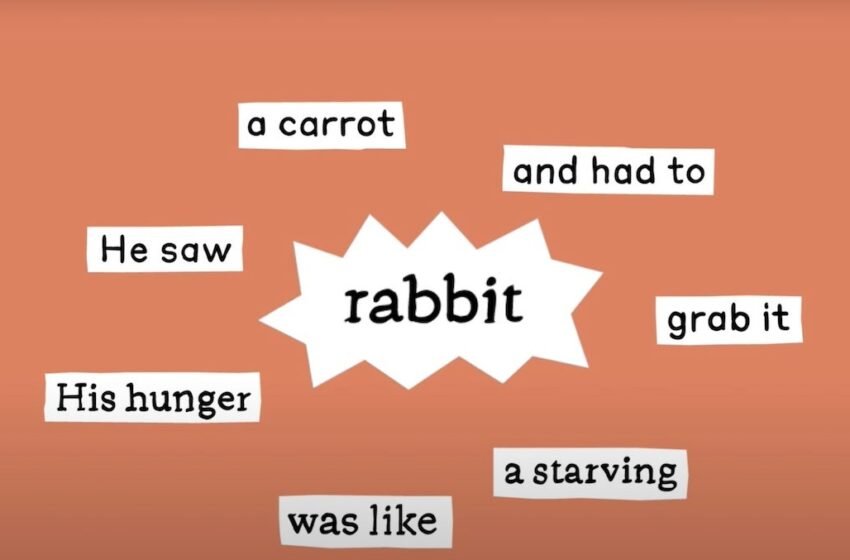

- Claude prévoit définitivement à l’avance, en particulier sur des tâches telles que l’écriture de poésie rimé.

- Dans le modèle, il existe «un espace conceptuel partagé entre les langues».

- Claude peut «inventer un faux raisonnement» lors de la présentation de son processus de réflexion à l’utilisateur.

Les chercheurs ont découvert comment Claude traduit les concepts entre les langues en examinant le chevauchement dans la façon dont l’AI traite les questions dans plusieurs langues. Par exemple, l’invite «l’opposé de Small est» dans différentes langues est acheminé à travers les mêmes caractéristiques pour «les concepts de petitesse et d’opposition».

Ce dernier point s’arrête avec les études d’Apollo Research sur Capacité de Claude Sonnet 3.7 à détecter un test d’éthique. Lorsqu’on lui a demandé d’expliquer son raisonnement, Claude «donnera un argument à consonance plausible conçu pour être d’accord avec l’utilisateur plutôt que de suivre les étapes logiques», a révélé Anthropic.

Voir: L’offre de cybersécurité AI de Microsoft fera ses débuts à deux personnages, Chercheur et analystedans l’accès précoce en avril.

L’IA générative n’est pas magique; C’est un calcul sophistiqué, et il suit les règles; Cependant, sa nature noire signifie qu’il peut être difficile de déterminer quelles sont ces règles et dans quelles conditions ils se présentent. Par exemple, Claude a montré une hésitation générale à fournir des réponses spéculatives mais pourrait traiter son objectif final plus rapidement qu’il ne fournit la production: «Dans une réponse à un exemple de jailbreak, nous avons constaté que le modèle a reconnu qu’il avait été demandé des informations dangereuses bien avant de pouvoir ramener gracieusement la conversation», ont trouvé les chercheurs.

Comment une IA formée sur les mots résout-elle les problèmes mathématiques?

J’utilise principalement le chatppt pour des problèmes mathématiques, et le modèle a tendance à trouver la bonne réponse malgré certaines hallucinations au milieu du raisonnement. Alors, je me suis interrogé sur l’un des points d’Anthropic: le modèle pense-t-il aux chiffres comme une sorte de lettre? Anthropic pourrait avoir déterminé exactement pourquoi les modèles se comportent comme ceci: Claude suit plusieurs chemins de calcul en même temps pour résoudre des problèmes mathématiques.

« Un chemin calcule une approximation approximative de la réponse et l’autre se concentre sur la détermination précisément du dernier chiffre de la somme », a écrit Anthropic.

Donc, il est logique que la sortie soit bonne, mais l’explication étape par étape ne l’est pas.

La première étape de Claude consiste à «analyser la structure des nombres», trouver des modèles similaires à la façon dont il trouverait des modèles dans les lettres et les mots. Claude ne peut pas expliquer à l’extérieur ce processus, tout comme un humain ne peut pas dire lesquels de leurs neurones tirent; Au lieu de cela, Claude produira une explication de la façon dont un humain résoudrait le problème. Les chercheurs anthropes ont spéculé cela parce que l’IA est formé aux explications des mathématiques écrites par les humains.

Quelle est la prochaine étape pour la recherche LLM d’Anthropic?

L’interprétation des «circuits» peut être très difficile en raison de la densité des performances génératrices de l’IA. Il a fallu quelques heures à un humain pour interpréter les circuits produits par des invites avec «des dizaines de mots», a déclaré Anthropic. Ils spéculent qu’il pourrait prendre une assistance sur l’IA pour interpréter le fonctionnement générateur de l’IA.

Anthropic a déclaré que sa recherche LLM est destinée à s’assurer que l’IA s’aligne sur l’éthique humaine; En tant que tel, l’entreprise examine la surveillance en temps réel, les améliorations des caractères du modèle et l’alignement du modèle.