Progrès en formation privée pour la production sur les modèles de langue sur l’appareil

Les modèles linguistiques (LMS) formés pour prédire le mot suivant donné le texte d’entrée sont la technologie clé pour de nombreuses applications (1, 2). Dans GoardLes LM sont utilisés pour améliorer l’expérience de frappe des utilisateurs en prenant en charge les fonctionnalités comme Prédiction des mots suivants (NWP), Compose intelligente, Achèvement intelligent et suggestion, glissement pour taper, et relire. Le déploiement de modèles sur les appareils des utilisateurs plutôt que sur les serveurs d’entreprise présente des avantages tels que une latence plus faible et une meilleure confidentialité pour l’utilisation du modèle. Alors que la formation sur les modèles à disque directement à partir des données utilisateur améliore efficacement les performances de l’utilité pour les applications telles que NWP et Sélection de texte intelligentIl est important de protéger la confidentialité des données des utilisateurs pour la formation des modèles.

|

| Les fonctionnalités GBoard alimentées par des modèles de langage sur périphérique. |

Dans ce blog, nous discutons de la façon dont des années de progrès de la recherche alimentent désormais la formation privée de GBoard LMS, depuis le développement de la preuve de concept de apprentissage fédéré (FL) en 2017 et formel confidentialité différentielle (DP) Garantie en 2022. FL permet aux téléphones mobiles d’apprendre en collaboration un modèle tout en conservant toutes les données de formation sur l’appareil, et DP Fournit une mesure quantifiable de l’anonymisation des données. Formellement, le DP est souvent caractérisé par (ε, δ) avec des valeurs plus petites représentant des garanties plus fortes. Les modèles d’apprentissage automatique (ML) sont considérés comme ayant Garanties DP raisonnables pour ε = 10 et fortes garanties de DP pour ε = 1 quand δ est petit.

À ce jour, tous les LMS de réseau neuronal NWP dans GBORD sont formés avec FL avec des garanties DP formelles, et tous les lancements futurs de GBboard LMS formés sur les données utilisateur nécessitent DP. Ces 30+ GB sur les LMS sont lancés dans plus de 7 langues et plus de 15 pays et satisfont (satisfaire (ɛ, δ) -Dp garanties de petits δ de 10-10 et ɛ entre 0,994 et 13,69. À notre connaissance, il s’agit du plus grand déploiement connu de DP au niveau de l’utilisateur en production chez Google ou n’importe où, et la première fois une forte garantie DP de ɛ <1 est annoncé pour les modèles formés directement sur les données des utilisateurs.

Principes et pratiques de confidentialité dans GBORD

Dans « Apprentissage fédéré privé à GBORD», Nous avons discuté de la différence principes de confidentialité se reflètent actuellement dans les modèles de production, notamment:

- Transparence et contrôle des utilisateurs: Nous fournissons la divulgation des données utilisées, à quel point il est utilisé, comment il est traité dans divers canaux et comment les utilisateurs de GBORD peuvent facilement configurer L’utilisation des données dans les modèles d’apprentissage.

- Minimisation des données: FL agréga immédiatement uniquement les mises à jour ciblées qui améliorent un modèle spécifique. Agrégation sécurisée (SECAGG) est une méthode de cryptage pour garantir davantage que seuls les résultats agrégés des mises à jour éphémères sont accessibles.

- Anonymisation des données: DP est appliqué par le serveur pour empêcher les modèles de mémoriser les informations uniques dans les données de formation de l’utilisateur individuel.

- Auditabilité et vérifiabilité: Nous avons rendu public les principales approches algorithmiques et la comptabilité de confidentialité en code open source (Agrégateur TFF, TFP DPQuery, Comptabilité DPet Système FL).

Une brève histoire

Ces dernières années, FL est devenu la méthode par défaut pour la formation GBOARD SUR DES LMS à partir des données de l’utilisateur. En 2020, un mécanisme DP qui clips et ajoute du bruit Pour modéliser les mises à jour ont été utilisées pour Empêcher la mémorisation pour la formation du LM espagnol en Espagne, qui satisfait les garanties DP finies (Niveau 3 décrit dans «Comment dp-fy ml « guide). En 2022, avec l’aide du Algorithme DP-suive-leader-régularisé (DP-FTRL)le LM espagnol est devenu le premier réseau de neurones de production formé directement sur les données des utilisateurs annoncés avec Une garantie DP formelle de (ε = 8,9, Δ = 10-10) -Dp (équivalent à la ρ = 0,81 Privative-diffférentielle concentrée zéro), et donc satisfait Garanties de confidentialité raisonnables (Niveau 2).

Confidentialité différentielle par défaut dans l’apprentissage fédéré

Dans « Apprentissage fédéré des modèles de langage GBORD avec une confidentialité différentielle», Nous avons annoncé que tous les LMS de réseau neuronal NWP dans GBORD ont des garanties DP, et que tous les lancements futurs de Gboard LMS formés sur les données utilisateur nécessitent des garanties DP. DP est activé en FL en appliquant les pratiques suivantes:

- Pré-entraîner le modèle avec le multilingue C4 ensemble de données.

- Via des expériences de simulation sur des ensembles de données publiques, trouvez un grand rapport DP-nie / signal qui permet un utilitaire élevé. L’augmentation du nombre de clients contribuant à un cycle de mise à jour du modèle améliore la confidentialité tout en gardant le rapport de bruit fixé pour une bonne utilité, jusqu’au point que la cible DP est atteinte, ou le maximum autorisé par le système et la taille de la population.

- Configurer le paramètre pour restreindre la fréquence que chaque client peut contribuer (par exemple, une fois tous les quelques jours) en fonction du budget de calcul et de la population estimée dans le système FL.

- Courir Dp-ftrl Formation avec des limites sur l’ampleur des mises à jour par périphérique choisies soit via coupure adaptativeou fixe en fonction de l’expérience.

Secagg peut également être appliqué en adoptant le Progrès dans l’amélioration du calcul et de la communication pour les échelles et la sensibilité.

|

| Apprentissage fédéré avec confidentialité différentielle et (Secagg). |

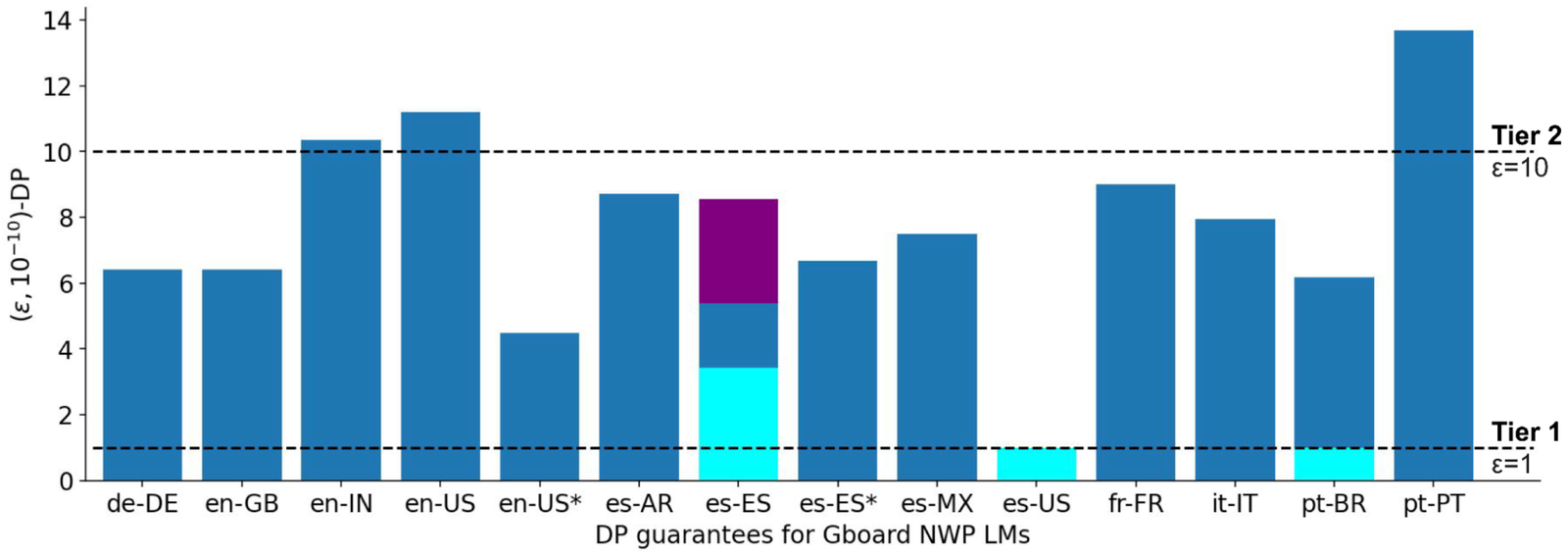

Rapport des garanties DP

Les garanties DP de LMS GNBBoard LMS sont visualisées dans le Barplot ci-dessous. Le x-Axis montre LMS étiqueté par Language-Locale et formé sur les populations correspondantes; le y-Axis montre le ε valeur quand δ est fixé à une petite valeur de 10-10 pour (ε, Δ) -dp (plus bas est meilleur). L’utilité de ces modèles est soit significativement meilleure que les modèles non neuronaux précédents en production, soit comparables à la LMS précédente sans DP, mesurée sur la base des mesures d’interactions utilisateur lors des tests A / B. Par exemple, en appliquant les meilleures pratiques, la garantie DP du modèle espagnol en Espagne est améliorée de ε = 8,9 à ε= 5,37. Secagg est également utilisé pour former le modèle espagnol en Espagne et le modèle anglais aux États-Unis. Plus de détails sur les garanties DP sont signalés dans L’appendice suivant le Lignes directrices décrites dans « Comment DP-Fy ML».

Vers des garanties DP plus fortes

Le ε~ 10 dp garanties de nombreux LM lancés sont déjà considérés raisonnable Pour les modèles ML dans la pratique, tandis que le parcours de DP FL à GBoard se poursuit pour améliorer l’expérience de saisie des utilisateurs tout en protégeant la confidentialité des données. Nous sommes ravis d’annoncer que, pour la première fois, la production LMS de Portugais au Brésil et en espagnol en Amérique latine est formée et lancée avec une garantie DP de ε ≤ 1, qui satisfait Garanties de confidentialité solides de niveau 1. Plus précisément, le (ε= 0,994, δ= 10-10) -DP La garantie est obtenue en exécutant le avancé Factorisation matricielle dp-ftrl (MF-DP-FTRL) Algorithme, avec plus de 12 000 appareils participant à chaque cycle de formation de la mise à jour du modèle de serveur plus grand que le Réglage commun de 6500+ appareilset une politique soigneusement configurée pour restreindre chaque client à la plupart participer au plus deux fois au total des 2000 cycles de formation en 14 jours dans la grande population portugaise des utilisateurs du Brésil. En utilisant un cadre similaire, le LM Es-Us espagnol a été formé dans une grande population combinant plusieurs pays en Amérique latine pour réaliser (ε= 0,994, δ= 10-10) -Dp. Le ε ≤ 1 modèle ES-US a considérablement amélioré l’utilité dans de nombreux pays et lancé en Colombie, en Équateur, au Guatemala, au Mexique et au Venezuela. Pour la population plus petite en Espagne, la garantie DP de l’ES-ES LM est améliorée de ε = 5,37 à ε= 3,42 en remplaçant uniquement Dp-ftrl avec Mf-dp-ftrl sans augmenter le nombre d’appareils participant à chaque tour. Plus de détails techniques sont divulgués dans le colab pour la comptabilité de confidentialité.

|

| DP Garanties pour Gboard NWP LMS (la barre violette représente le premier lancement ES-ES de ε = 8,9; les barres cyan représentent des améliorations de confidentialité pour les modèles formés avec Mf-dp-ftrl; niveaux sont de «Comment DP-Fy ML » guide; En-us * et es-es * sont en outre formés avec SecAgg). |

Discussion et étapes suivantes

Notre expérience suggère que DP peut être réalisé dans la pratique grâce à la co-conception de l’algorithme système sur la participation du client, et que la confidentialité et l’utilité peuvent être fortes lorsque les populations sont importantes et Un grand nombre de contributions de dispositifs sont agrégées. Les compromis de la computation de confidentialité-utilité peuvent être améliorés par Utilisation de données publiquesle nouvel algorithme MF-DP-FTRL, et resserrer la comptabilité. Avec ces techniques, une forte garantie DP de ε ≤ 1 est possible mais toujours difficile. Recherche active sur l’audit empirique de la vie privée (1, 2) suggère que les modèles DP sont potentiellement plus privés que les garanties de DP les pires cas. Alors que nous continuons à pousser la frontière des algorithmes, quelle dimension de la computation de la confidentialité-utilité devrait être priorisée?

Nous travaillons activement sur tous DP distribué et améliorer Auditabilité et vérifiabilité. Environnement d’exécution de confiance Ouvre la possibilité d’augmenter considérablement la taille du modèle avec une confidentialité vérifiable. Le récent percée dans les grands LM (LLMS) nous motive à repenser L’utilisation de publique Informations sur la formation privée et plus d’interactions futures entre les LLM, les LMS sur les appareils et la production de GB.

Remerciements

Les auteurs tiennent à remercier Peter Kairouz, Brendan McMahan et Daniel Ramage pour leurs premiers commentaires sur le billet de blog lui-même, Shaofeng Li et Tom Small pour avoir aidé avec les personnages animés et les équipes de Google qui ont aidé à la conception de l’algorithme, à la mise en œuvre des infrastructures et à la maintenance de la production. Les collaborateurs ci-dessous contribuent directement aux résultats présentés:

Recherche et développement d’algorithmes: Galen Andrew, Stanislav Chiknavaryan, Christopher A. Choquette-Choo, Arun Ganesh, Peter Kairouz, Ryan McKenna, H. Brendan McMahan, Jesse Rosenstock, Timon Van Overveld, Keith Rush, Shuang Song, Thomas Steinke, Abhradeep Guha Guha, Omorta, Omas, Thomas Steinke, Abhradeep Guha Guha, Omraf Yuanbo Zhang.

Infrastructure, production de production et de leadership: Mingqing Chen, Stefan Dierauf, Billy Dou, Hubert Eichner, Zachary Garrett, Jeremy Gillula, Jianpeng Hou, Hui Li, Xu Liu, Wenzhi Mao, Brett McLarnon, Mengchen Pei, Daniel Ramage, Swaroop Yun Wang, Shanshan Wu, Yu Xiao et Shumin Zhai.

Source link