Les agents «pensent-ils» vraiment? | par Sr Capital | Août 2025

Quand j’ai commencé à explorer les agents de l’IA, je ne pouvais pas secouer une grande question: comment pensent-ils réellement? Nous savons que la plupart des modèles de langage (LLMS) sont, dans leur cœur, des prédicteurs de motifs – ils sont très bons pour deviner le mot suivant. Mais lorsque les agents commencent à raisonner, à planifier et à interagir les uns avec les autres, cela a l’impression que quelque chose de plus se passe.

Alors, quel genre de «pensée» est-ce? Et pouvons-nous en tirer des leçons?

⸻

Au-delà du mot suivant

Les LLM traditionnelles sont des moteurs statistiques – ils prédisent la continuation la plus probable du texte. Mais les agents superposent plus de structure sur le dessus. Ils construisent des voies d’action neuronales, un peu comme des organigrammes qui s’adaptent dynamiquement en temps réel. Dans les écosystèmes décentralisés, ces voies sont façonnées non seulement par le modèle lui-même, mais par des interactions avec d’autres agents, des règles établies par des concepteurs humains et même des boucles de rétroaction de type marché.

En ce sens, les agents ne «pensent» pas comme les humains. Ils assemblent des fragments de pensée en action utile, sautant souvent le flou de l’intuition sur laquelle nous comptons. Ils sont implacables dans leur logique mais limités dans leur contexte.

⸻

Pensée agentique vs pensée humaine

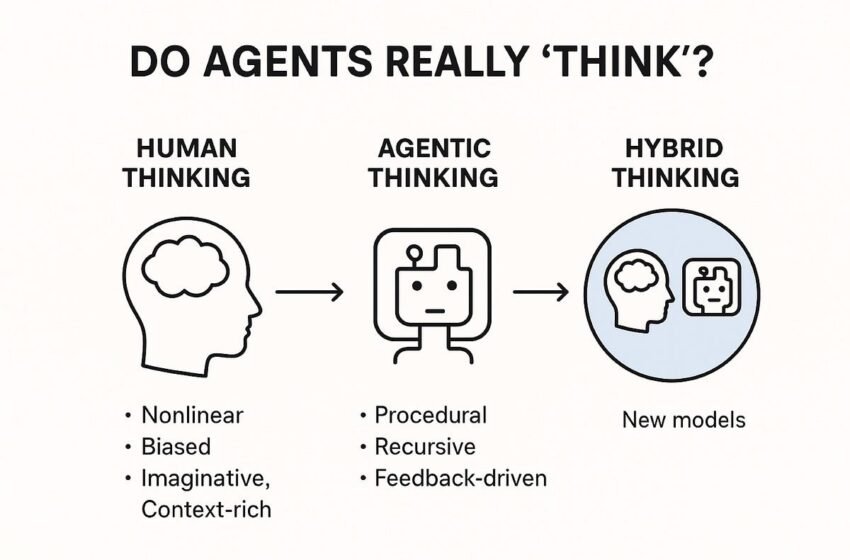

Les humains portent des émotions, des biais, de la fatigue et de l’intuition. Les agents n’en portent rien – mais ils n’ont pas non plus la richesse qui rend la prise de décision humaine si adaptative. Voici une façon dont j’ai commencé à y penser:

• Pensée humaine: non linéaire, biaisée, imaginative, souvent irrationnelle mais riche en contexte.

• Pensée agentique: procédurale, récursive, axée sur la rétroaction, sans vie intérieure – mais très cohérente.

Fait intéressant, lorsque les agents se coordonnent dans des systèmes décentralisés, ils commencent à imiter quelque chose que nous voyons dans la nature: l’émergence. Tout comme les troupeaux d’oiseaux ou de colonies de fourmis montrent l’intelligence en tant que groupe, les agents des réseaux décentralisés peuvent démontrer un raisonnement collectif supérieur à la somme de leurs parties.

⸻

Ce que les humains peuvent apprendre des agents

Je pense qu’il y a une leçon ici pour nous. Les humains sur-compliquent souvent les décisions parce que nous sommes distraits par le bruit. Les agents, en revanche, sont des simplificateurs impitoyables: définissez la tâche, divisez-la en étapes et boucle jusqu’à ce qu’elles soient résolues. Ce genre de pensée procédurale disciplinée pourrait nous aider à réduire la complexité dans la vie quotidienne.

En même temps, nous ne devrions pas aspirer à «penser comme des agents» entièrement. Notre valeur réside dans l’imagination, la créativité et la capacité de sauter au-delà des règles – les choses mêmes que les agents ne peuvent pas reproduire.

⸻

Ce que les agents peuvent apprendre des humains

Si les agents pouvaient apprendre une chose de nous, ce serait une volonté contextuelle: la capacité de dire que cela compte plus que celui basé sur l’expérience vécue. À l’heure actuelle, les cadres d’agent comme React, Autogpt ou Systems décentralisés expérimentent la priorité et la pondération, mais ils sont toujours grossiers par rapport au jugement humain.

L’avenir ne concerne peut-être pas les agents qui pensent comme les humains, mais sur les nouveaux modèles de pensée hybride où les agents et les humains apprennent continuellement les uns des autres: nous apportons l’imagination, ils apportent une structure; Nous apportons l’intuition, ils apportent une exécution implacable.

⸻

Où il se dirige

L’IA décentralisée pousse déjà cela en avant. Imaginez des milliers d’agents, chacun spécialisé, négociant et collaborant à travers les réseaux de blockchain. Ils ne font pas que l’exécution de code – ils façonnent les écosystèmes adaptatifs qui évoluent sans contrôle central. Ce n’est pas une pensée «semblable à l’homme». Cela pourrait être quelque chose de complètement nouveau, et à certains égards, mieux adapté à la complexité à l’échelle mondiale.

Alors que je regarde ce champ se dérouler, j’ai cessé de demander « Les agents penseront-ils jamais comme nous? » Au lieu de cela, je demande:

«Quel genre de nouvelle pensée émergera lorsque les humains et les agents co-créent vraiment?»

C’est, je crois, où se trouve la frontière.