(D) GSPO: Méthode RLHF au niveau de QWEN3 Vs. GRPO – Analyse de stabilité et de mise à l’échelle

|

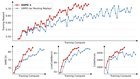

L’équipe Qwen a récemment proposé Optimisation de la politique de séquence de groupe (GSPO)une approche d’apprentissage de renforcement pour le réglage fin de la formation LLM. Ils le positionnent comme une alternative à Optimisation de la politique relative du groupe (GRPO) – Utilisé dans Deepseek – et revendiquez l’échantillonnage de l’importance au niveau du jeton de Grpo est «mal posé» pour une formation stable. Arrière-plan:

Préoccupations clés avec GRPO:

Proposition de GSPO:

Résultats des expériences:

Si vous êtes intéressé, lisez-en plus ici: L’équipe Qwen propose le GSPO pour Qwen3, affirme que le Grpo de Deepseek est mal posé. L’article de blog comprend des formulations mathématiques des deux méthodes et des comparaisons de performances. Je suis intéressé à savoir:

soumis par / u / marketingnetmind |