Tirer le meilleur parti de l’écosystème de Langchain

Image par auteur

Image par auteur# Introduction

La construction de systèmes d’IA complexes n’est pas une mince affaire, en particulier lors de la viser des solutions prêtes pour la production, évolutives et maintenables. Grâce à ma récente participation à des compétitions d’IA agentiques, j’ai réalisé que même avec un large éventail de cadres disponibles, la construction de workflows d’agent AI robustes reste un défi.

Malgré certaines critiques dans la communauté, j’ai constaté que l’écosystème de Langchain se démarque de son aspect pratique, de sa modularité et de ses capacités de développement rapides.

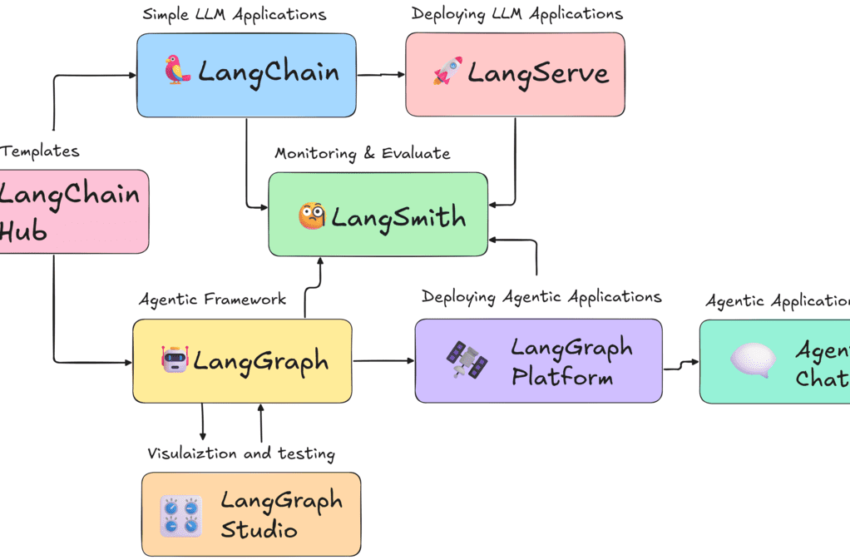

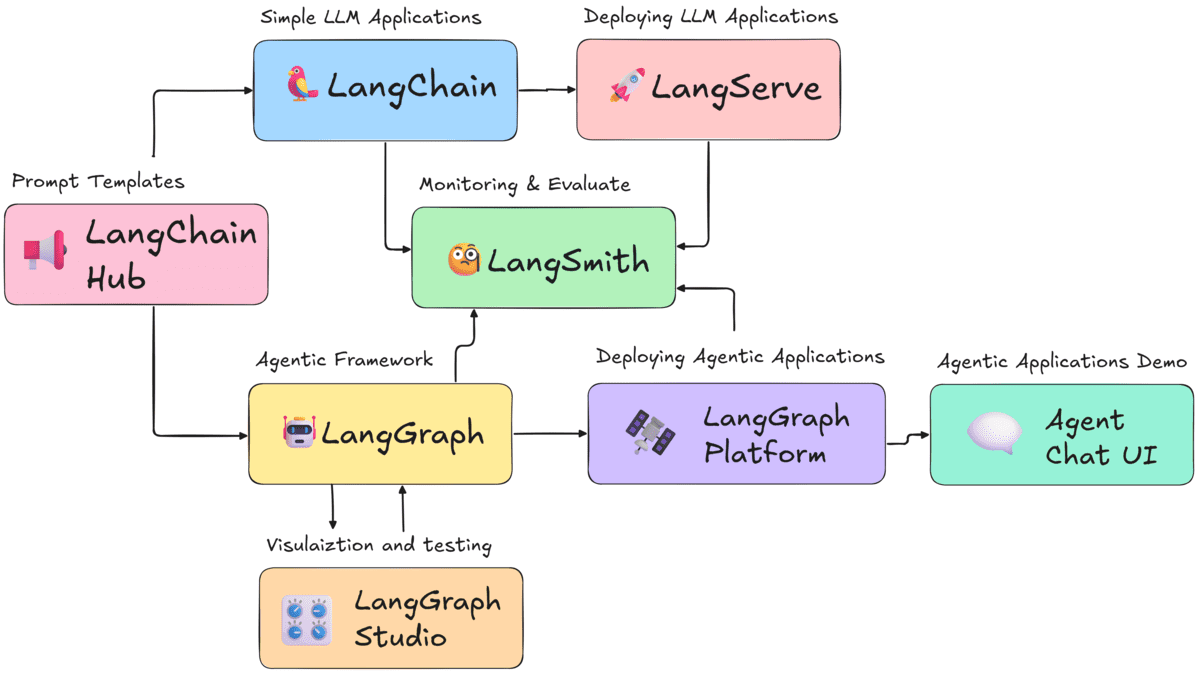

Dans cet article, je vous guiderai à travers la façon de tirer parti de l’écosystème de Langchain pour construire, tester, déployer, surveiller et visualiser les systèmes d’IA, montrant comment chaque composant joue son rôle dans le pipeline d’IA moderne.

# 1. La fondation: les packages Python de base

Lubriole est l’un des frameworks LLM les plus populaires de GitHub. Il se compose de nombreuses intégrations avec des modèles d’IA, des outils, des bases de données, etc. Le package Langchain comprend des chaînes, des agents et des systèmes de récupération qui vous aideront à créer des applications d’IA intelligentes en quelques minutes.

Il comprend deux composants centraux:

- Langchain-Core: La fondation, fournissant des abstractions essentielles et le langage d’expression de Langchain (LCEL) pour la composition et la connexion des composants.

- Langchain-Community: Une vaste collection d’intégrations tierces, des magasins vectoriels aux nouveaux fournisseurs de modèles, ce qui facilite la prolongation de votre application sans gonfler la bibliothèque de base.

Cette conception modulaire maintient Langchain léger, flexible et prêt pour le développement rapide d’applications d’IA intelligentes.

# 2. Le centre de commande: Langsmith

Langsmith Vous permet de retracer et de comprendre le comportement étape par étape de votre application, même pour les systèmes agentiques non déterministes. C’est la plate-forme unifiée qui vous donne la vision des rayons X dont vous avez besoin pour le débogage, les tests et la surveillance.

Caractéristiques clés:

- Traçage et débogage: Voir les entrées, sorties, appels d’outils, latence et les dénombrements de jetons pour chaque étape de votre chaîne ou agent.

- Tests et évaluation: Collectez les commentaires des utilisateurs et annotez les exécutions pour créer des ensembles de données de test de haute qualité. Exécutez des évaluations automatisées pour mesurer les performances et prévenir les régressions.

- Surveillance et alertes: En production, vous pouvez configurer des alertes en temps réel sur les taux d’erreur, la latence ou les scores de rétroaction des utilisateurs pour capter les échecs avant que vos clients ne le fassent.

# 3. L’architecte de la logique complexe: Langgraph & Langgraph Studio

Languette est populaire pour créer des applications d’IA agentiques où plusieurs agents avec divers outils travaillent ensemble pour résoudre des problèmes complexes. Lorsqu’une approche linéaire (Langchain) n’est pas suffisante, le langgraphe devient essentiel.

- Langgraph: Créez des applications multi-acteurs avec état en les représentant comme des graphiques. Au lieu d’une simple chaîne d’entrée à sortie, vous définissez les nœuds (acteurs ou outils) et les bords (la logique qui dirige le flux), permettant des boucles et une logique conditionnelle essentielles pour construire des agents contrôlables.

- Studio Langgraph: Ceci est le compagnon visuel de Langgraph. Il vous permet de visualiser, de prototyper et de déboguer les interactions de votre agent dans une interface graphique.

- Plateforme Langgraph: Après la conception de votre agent, utilisez la plate-forme Langgraph pour déployer, gérer et mettre à l’échelle des workflows de longue durée. Il s’intègre parfaitement à Langsmith et Langgraph Studio.

# 4. Le dépôt partagé: Langchain Hub

Le Hub de Langchain est un référentiel central contrôlé par version pour découvrir et partager des invites de haute qualité et des objets exécutables. Cela découple votre logique d’application à partir du contenu de l’invite, ce qui facilite la recherche d’invites conçues pour des tâches courantes et la gestion de la cohérence de votre propre équipe.

# 5. Du code à la production: Langserve, les modèles et les interdictions

Une fois que votre application Langchain est prête et testée, le déployer est simple avec les bons outils:

- Langserve: Transformez instantanément vos couleurs et chaînes Langchain en une API de repos prêt pour la production, avec des documents générés automatiquement, du streaming, du lot et de la surveillance intégrée.

- Plateforme Langgraph: Pour des workflows et une orchestration d’agent plus complexes, utilisez la plate-forme Langgraph pour déployer et gérer des systèmes avancés en plusieurs étapes ou multi-agents.

- Modèles et UIS: Accélérez le développement avec des modèles prêts à l’emploi et des interfaces utilisateur, telles que l’agent-chat-UI, ce qui facilite la construction et l’interaction avec vos agents immédiatement.

# Mettre tout cela ensemble: un flux de travail moderne

Voici comment l’écosystème de Langchain prend en charge chaque étape de votre cycle de vie de votre application AI, de l’idée à la production:

- Ideate et prototype: Utilisez Langchain-Core et Langchain-Community pour attirer les bons modèles et sources de données. Prenez une invite testée au combat du Hub de Langchain.

- Débogage et affiner: Dès le début, faites fonctionner Langsmith. Tracez chaque exécution pour comprendre exactement ce qui se passe sous le capot.

- Ajouter la complexité: Lorsque votre logique a besoin de boucles et d’état, refactorisez-la à l’aide de Langgraph. Visualisez et déboguez le flux complexe avec Langgraph Studio.

- Tester et évaluer: Utilisez Langsmith pour collecter des cas de bord intéressants et créer des ensembles de données de test. Configurez des évaluations automatisées pour garantir que la qualité de votre application s’améliore régulièrement.

- Déploier et surveiller: Déployez votre agent à l’aide de la plate-forme Langgraph pour un flux de travail évolutif et avec état. Pour des chaînes plus simples, utilisez Langserve pour créer une API REST. Configurez les alertes Langsmith pour surveiller votre application en production.

# Réflexions finales

De nombreux cadres populaires comme Crewai sont en fait construits sur l’écosystème de Langchain. Au lieu d’ajouter des couches supplémentaires, vous pouvez rationaliser votre flux de travail en utilisant Langchain, Langgraph et leurs outils natifs pour créer, tester, déployer et surveiller les applications AI complexes.

Après avoir construit et déployé plusieurs projets, j’ai appris que s’en tenir à la pile Core Langchain garde les choses simples, flexibles et prêtes pour la production.

Pourquoi compliquer les choses avec des dépendances supplémentaires lorsque l’écosystème de Langchain fournit déjà tout ce dont vous avez besoin pour le développement de l’IA moderne?

Abid Ali Awan (@ 1abidaliawan) est un professionnel certifié des data scientifiques qui aime construire des modèles d’apprentissage automatique. Actuellement, il se concentre sur la création de contenu et la rédaction de blogs techniques sur l’apprentissage automatique et les technologies de science des données. Abid est titulaire d’une maîtrise en gestion technologique et d’un baccalauréat en génie des télécommunications. Sa vision est de construire un produit d’IA en utilisant un réseau de neurones graphiques pour les étudiants aux prises avec une maladie mentale.