Génération de code pour la première fois: meilleures pratiques détaillées pour les équipes de développement assistées par l’IA

Auteur (s): Mishtert t

Publié à l’origine sur Vers l’IA.

Comme Quelqu’un qui a passé d’innombrables heures à déboguer du code qui semblait parfait à première vue, j’ai appris que les outils de codage de l’IA peuvent être à la fois une bénédiction et une malédiction.

La question n’est pas de savoir si ces outils nous rendent plus rapidement; ils le font.

La vraie question est de savoir s’ils nous rendent meilleurs.

Le curseur et le copilote GitHub sont deux exemples d’aides contemporaines de codage AI qui peuvent réduire considérablement les cycles de développement. Cependant, des études empiriques montrent que 25 à 50% des suggestions d’IA initiales contiennent des défauts fonctionnels ou de sécurité.

La réalisation du code pour la première fois (FTR), le code qui compile, passe des tests, répond aux normes et est prêt pour la production sur le premier engagement, nécessite des pratiques disciplinées qui vont au-delà de l’acceptation de la production d’IA.

Ce manuel technique, écrit de mon point de vue, traduit les résultats de la recherche et l’expérience en habitudes, garde-corps et modèles d’automatisation. Ces éléments garantissent que chaque ingénieur expédie systématiquement le code FTR tout en maintenant la productivité.

Pourquoi la première fois est importante

La première heure est sortie de la fabrication des sols, où la découverte de défauts après la production a signifié la suppression des lots entiers ou des rappels coûteux. Mais attendez, le logiciel est-il vraiment le même? Je pense que les logiciels pourraient être pires.

D’après mon expérience, j’ai vu comment une seule vulnérabilité négligée peut persister pendant des années. Les défauts de fabrication affectent les produits individuels, mais les défauts de code peuvent avoir un impact sur chaque utilisateur, chaque transaction, indéfiniment.

Permettez-moi de décomposer pourquoi cela compte tant dans la pratique:

- Les cycles de débogage détruisent l’élan: J’y suis allé – Vous êtes à l’état de flux, puis en boom, vous êtes retiré au code que vous avez écrit la semaine dernière. La recherche montre que ces interruptions consomment de 30 à 45 minutes par correctif, mais Honnêtement, cela semble conservateur Lorsque vous tenez compte du contexte mental.

- Les trous de sécurité aggravés au fil du temps: C’est ce qui me tient vraiment debout la nuit. Les défauts de fabrication sont contenus, mais les vulnérabilités du code? Des études révèlent que près de la moitié des extraits de code générés par l’IA contiennent des faiblesses cotées au CWE

- La confiance de l’érosion crée une friction de l’équipe: J’ai regardé cela se produire de première main. Lorsque les suggestions de l’IA échouent régulièrement, les développeurs commencent à tout de plus. La congestion du pipeline ajoute l’insulte à la blessure; Chaque Round Ci échoué vole encore 12 minutes du flux de l’équipe

J’ai besoin de clarifier quelque chose d’important. Le FTR ne consiste pas à atteindre la perfection lors du premier essai. Ce serait impossible et franchement paralysant. Il s’agit d’établir des processus qui pèsent des problèmes avant de s’échapper dans la production.

Le coût caché du code «assez bon»

Un membre de l’équipe a utilisé GitHub Copilot pour générer une fonction d’authentification. Le code compilé, semblait professionnel et réussit les tests de base. Deux semaines plus tard, il a été découvert qu’il avait une vulnérabilité qui pourrait exposer les données des utilisateurs. Les 15 minutes économisées lors du codage ont été étendues à 6 heures de correctif d’urgence.

Ce modèle se répète dans l’industrie. Ce n’est pas un problème mineur; C’est un problème systématique nécessitant des solutions systématiques.

Anatomie de la première droite dans les workflows améliorés en AI

Mon expérience avec les outils de codage de l’IA m’a appris que le succès nécessite une discipline, pas seulement de meilleures invites. Ce n’est que partiellement vrai. Mieux invite énormément, mais ce n’est qu’une pièce du puzzle.

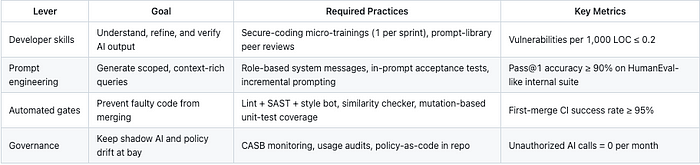

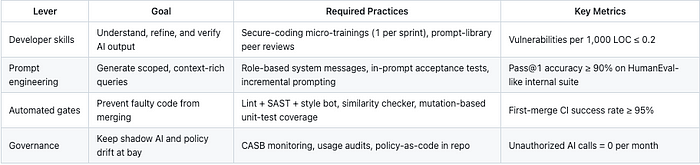

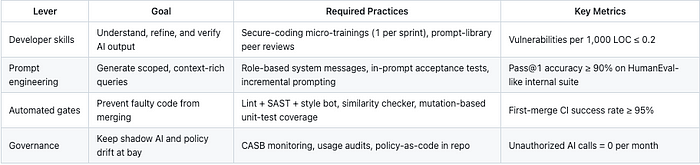

L’approche la plus efficace que j’ai trouvée combine quatre éléments:

- Incitation granulaire: Briser les fonctionnalités complexes en incréments de ligne 15 à 20 plutôt que de demander des fonctions complètes

- Explication obligatoire: Ne jamais commettre de code généré par AI jusqu’à ce que vous puissiez expliquer sa logique et ses cas de bord

- Vérification automatisée: Utilisez des outils d’analyse statique et des tests de mutation pour prendre des problèmes avant l’examen humain

- Raffinement itératif: Demandez à l’IA d’expliquer son code, puis optimisez en fonction de cette explication

Les équipes qui réussissent avec des outils de codage de l’IA les traitent comme des développeurs juniors qui ont besoin de supervision, et non comme des générateurs de code.

1. Ingénierie rapide de précision 🎯

1.1 Adopter les messages système ancrés au rôle

Commencez chaque séance de chat ou de curseur de copilote avec une invite de système réutilisable qui applique les conventions organisationnelles:

You are a Senior <LANG> engineer in <ORG>.

Generate secure, idiomatic, unit-tested code that follows <STYLE_GUIDE_URL>.

Never expose secrets; prefer dependency injection; include docstring and

pytest-style tests.

Une étude interne de Microsoft montre que le cadrage explicite des rôles augmente le taux de réponses correct de 18 à 24 points.

1.2 Décomposer le travail dans les invites atomiques

Les grandes fonctionnalités «à un seul coup» donnent des hallucinations et une dérive de style. L’enquête en 2025 de Qodo a révélé que 65% des réponses de faible qualité découlent des contextes manquants.

Brisez les fonctionnalités en incréments de ligne de 15 à 20:

- Invite de talon de signature: Définissez API de fonction, types, squelette docstring.

- Invite d’implémentation: Signature de fourniture, commentaires de logique de branche complexes.

- Invite de test: Demandez des tests unitaires paramétrés qui appliquent les cas de bord.

1.3 Incorporer des astuces de test d’acceptation

Attachez des scénarios ou des exemples de style gherkin directement à l’intérieur de l’invite:

# Examples

# add(2,3) -> 5

# add(-4,4) -> 0

LLMS Conditionné avec des invites axées sur l’exemple atteint jusqu’à 1,9% de première passe de première passe (pass @ 1) et 74,8% de jetons en moins que le COT sur Humaneval

1.4 Boucle de raffinement itérative

Après la génération initiale:

- Expliquer: Demandez au modèle de paraphraser son code pour faire surface des défauts cachés.

- Contraindre: Demandez des optimisations («o (n) pas o (n²)») ou resserrement de la sécurité.

- Régénérer: Limitez les itérations à ≤3 pour éviter les rendements décroissants et les déchets de jetons.

2. Discipline de vérification du développeur 🔍

2.1 Règle «expliquer auparavant»

Aucune suggestion ne doit être engagée tant que le développeur peut expliquer verbalement ses cas d’écoulement et de bord pendant la description des relations publiques.

Cela améliore les écarts de compréhension mis en évidence dans les études empiriques, où 44% du code d’IA rejeté a échoué en raison de l’intention peu claire.

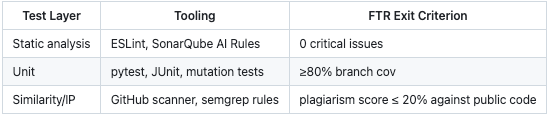

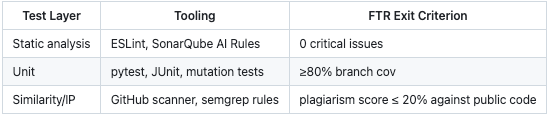

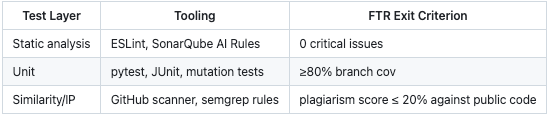

2.2 Triade de triple test obligatoire

Les blocs CI fusionnent sur toute défaillance, garantissant la surface des défauts avant l’examen.

2.3 bibliothèque d’extraits

Maintenir un référentiel interne et vérifié (modèles pour l’authentique, accès DB, gestion des erreurs). Les développeurs peuvent les référer dans des invites.

Use company::auth::jwt.verify_token() for user validation.

Réutilisation de l’extrait réduit de la densité de vulnérabilité de 38% chez un pilote Jet-Brains de 6 mois

3. Gates de qualité automatisées 🚪

3.1 Crochet pré-engagé par Ai-Tagging

Git Hook Tags Lignes générées par copilote (`# AI-GEN`) via l’heuristique Diff. Le pipeline SAST applique ensuite des seuils plus stricts aux régions marquées (par exemple, bloqueurs CWE à haute sévérité).

3.2 Policy-as-Code

Stockez les règles YAML dans `/ AI-polices /`.

ai:

allow_public_code_match: false

require_tests: true

secret_scans: true

Les pipelines échouent rapidement sur les violations des politiques, appliquant une gouvernance uniforme entre les références.

3.3 Parallélisme SMART CI

Pour économiser les minutes CI, commencez avec des liners légers et arrêtez en aval emplois S’ils ne fonctionnent pas. Cela permet aux grandes entreprises de récupérer jusqu’à 19% du temps de pipeline.

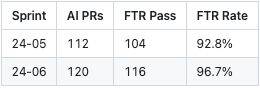

4. Retour et apprentissage continu 🔄

4.1 Métriques PR-LABEL

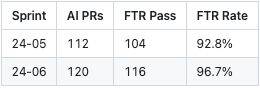

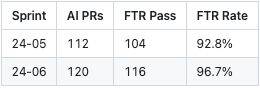

Tag a fusionné PRS avec `AI-FTR-PASS` ou `Ai-Ftr-Fail`. Aggrégats de scripts hebdomadaires:

Les équipes de tableau de bord tendance mettent en avant des équipes de coaching.

4.2 Revue de télémétrie Chatbot

Pour améliorer les modèles rapides, agréger les paires de complétion rapide, les anonymiser et les évaluer une fois par mois. Google Cloud Research montre que la conservation des bibliothèques rapides réduit l’utilisation des jetons futurs de 31%

4.3 Champion Tables rondes

En nommer un « Champion de l’IA»Par escouade. Les sessions mensuelles partagent les échecs et les correctifs (par exemple, les hacks de taille de contexte, de meilleures invites de test). L’apprentissage par les pairs a amélioré la qualité du code perçue de 81% lors de l’adoption.

5. Liste de contrôle des références rapides pour les ingénieurs ✅

- Utiliser / se référer à l’invite du système basée sur les rôles approuvé.

- Limiter la portée de l’invite à un objectif LOC ≤ 20.

- Inclure des exemples et des cas de bord.

- Demandez au modèle d’expliquer et d’optimiser l’invite.

- Ajouter ou accepter uniquement lorsque l’explication est claire.

- Assurez-vous que les tests unitaires sont générés et passez localement.

- Pousser; Permettez à CI de valider le sast, la couverture et la similitude.

- Revoir PR Diff; Revue de balises sur les blocs générés par AI.

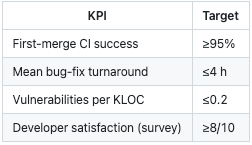

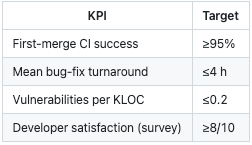

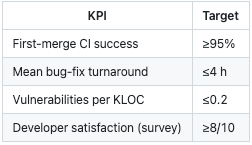

6. Mesurer le succès 📏

Réflexions finales

Laissez-moi être complètement honnête à ce sujet. La mise en œuvre des pratiques FTR nécessite un investissement initial. Les équipes doivent établir de nouveaux flux de travail, former des développeurs sur l’ingénierie rapide et mettre en place des portes de qualité automatisées.

Certaines organisations pourraient résister à ces frais généraux supplémentaires. Mais l’alternative de continuer à traiter le code généré par l’IA comme étant immédiatement prêt pour la production est finalement plus coûteuse et plus risquée.

Les outils d’IA devenant plus sophistiqués et largement adoptés, le volume de code potentiellement problématique augmente de façon exponentielle.

La solution n’est pas d’abandonner les outils de codage de l’IA. C’est pour les utiliser plus intelligemment. Les pratiques à droite pour la première fois fournissent le cadre pour faire exactement cela, exploitant la vitesse de l’IA tout en maintenant la surveillance humaine et les normes de qualité.

L’objectif n’est pas de remplacer le jugement humain par l’efficacité de l’IA. Il s’agit d’augmenter les capacités humaines avec l’aide de l’IA, créant un processus de développement à la fois plus rapide et plus fiable que l’un ou l’autre approche.

À propos de l’auteur:

Transformation et architecte AI | Advocat de gouvernance | Médiateur et arbitre

Un leader des analyses et de la transformation avec plus de 24 ans d’expérience, conseillant le changement, la gestion des risques et l’adoption de la technologie tout en mettant l’accent sur la gouvernance d’entreprise. En tant que mentor, Mishtert aide les organisations à exceller au milieu des paysages en évolution.

Publié via Vers l’IA

Source link