(D) Les nouveaux modèles Gemma 3 de Google de Google lors de notre fonctionnement d’inférence – sous-seconde commence

|

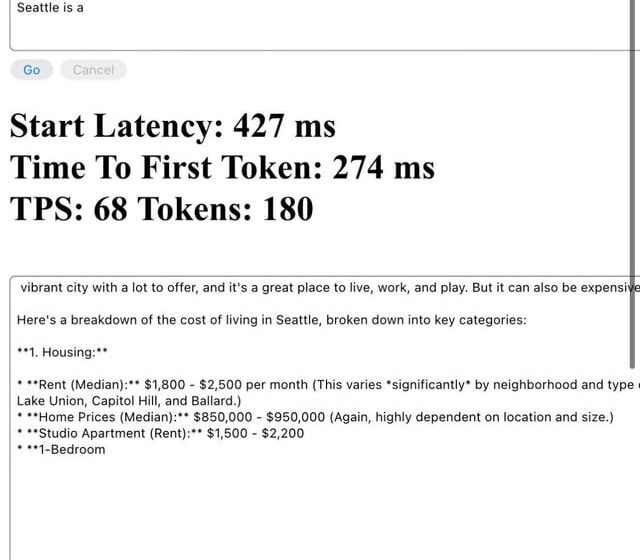

Nous avons récemment exécuté des repères à froid pour les nouveaux modèles GEMMA-3 4B (Text + Vision Variants) en utilisant un runtime de conteneur basé sur un instantané sur A6000 (40 Go VRAM). Alors que la plupart des discussions se concentrent sur le débit, le début de la latence de démarrage reste un gros goulot d’étranglement dans les environnements dynamiques ou multi-locataires. Voici ce que nous avons testé:

Quelques observations:

Curieux si d’autres ont essayé des techniques similaires (par exemple, Vllm, Deeppeed Zero, Torchserve Tricks) pour réduire la latence froide. Comment manipulez-vous tous les démarrages à froid dans des environnements de production ou sans serveur? J’adorerais entendre ce qui fonctionne (ou non). (Également heureux de partager plus sur la configuration si utile.) soumis par / u / pmv143 |