(R) le Gamechanger du mécanisme d’attention de l’interprète

|

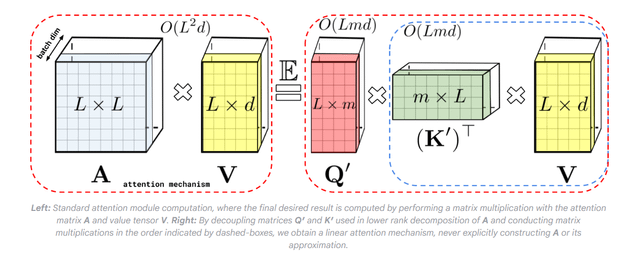

Je viens de savoir que les modèles SOTA AI comme Bigbird, Linformer et Reformer utilisent l’architecture de l’interprète La somme du préfixe effectue essentiellement des calculs à la volée en réduisant l’espace mémoire, ceci est très efficace par rapport à l’original "L’attention est tout ce dont vous avez besoin" Le mécanisme d’attention de Softmax de Paper où le masquage est utilisé pour obtenir une matrice triangulaire inférieure et cette matrice triangulaire inférieure est stockée, ce qui entraîne une complexité de mémoire quadratique … C’est Sacrément bien Un organisme sait-il ce que les modèles SOTA actuels tels que Chatgpt 4O, Gemini 2.5 Pro utilisent comme mécanisme de base (comme le mécanisme d’attention) bien qu’ils ne soient pas open source, afin que n’importe qui puisse faire une supposition soumis par / u / thenonarch776 |