12 serveurs MCP que vous pouvez utiliser en 2025

Auteur (s): Kalash Vasaniya

Publié à l’origine sur Vers l’IA.

Pontage LLMS aux données, aux outils et aux services

Si vous n’êtes pas membre mais que vous souhaitez lire cet article, consultez ce lien d’ami ici.

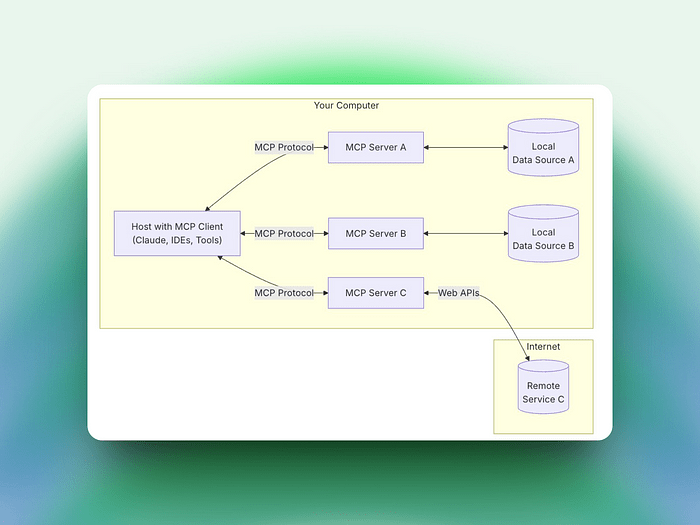

MCP (Model Context Protocol) devient rapidement la norme de facto pour la connexion Modèles de grande langue (LLMS) à l’écosystème riche des données, des outils et des services dont ils ont besoin pour être vraiment utiles. Au lieu d’appeler des API du codage dur dans chaque invite ou de fabrication de «pads à gratter» élaborés, les serveurs MCP exposent une interface uniforme qui permet à votre LLM de découvrir dynamiquement des capacités, de négocier des paramètres et d’exécuter des actions, tout en maintenant la sécurité, l’auditabilité et la continuité du contexte.

Ce qu’il fait: il fournit à votre modèle des droits de lecture / écriture / création sur un système de fichiers de bac à sable afin qu’il puisse ingérer des vidages locaux, des rapports de sortie ou un modèle de nouvelles structures de projet.

L’application de sandbox limite le modèle pour accéder uniquement à certains dossiers. bien conçu, il peut y avoir des retards.

Ce qu’il fait: connecte votre LLM aux référentiels GitHub – fournissant un navigateur, des recherches, des mises à jour basées sur le diff, la génération de demande de traction et la fusion.

Code de recherche en utilisant langage naturel requêtes.pr écriture, comme différents aperçus. Lisez le blog complet gratuitement sur Medium.

Publié via Vers l’IA