Ce que les modèles préfèrent apprendre: un cadrage géométrique de l’architecture et de la régularisation

Auteur (s): Sinbord Sorlberg

Publié à l’origine sur Vers l’IA.

Introduction

Qu’est-ce qu’un réseau neuronal vraiment apprendre?

Chaque apprentissage automatique Modèle, profond ou superficiel, apprend en recherchant dans un «espace d’hypothèse» – l’ensemble des fonctions qu’il peut, en principe, représenter. Mais cet espace n’est pas un territoire neutre. Il est sculpté et pondéré par deux forces: architecture et régularisation.

- Le architecture définir quoi peut être exprimé.

- Régularisation définir comment Les différentes régions de cet espace sont probablement à explorer ou à faire confiance.

Ce n’est pas une nouvelle observation. Mais à mesure que les modèles deviennent plus expressifs et spécifiques à l’application, compréhension comment Ces deux éléments interagissent non seulement académiques – mais fondamentaux à la conception de modèles intelligents.

Notre objectif dans ce post est de prendre cette question au sérieux. Nous explorerons comment différentes architectures neuronales sculptent la géométrie et topologie des espaces d’hypothèse, et comment la régularisation peut être considérée non seulement comme une contrainte mais comme un schéma de priorisation – une façon de souligner certaines «régions» de l’espace d’hypothèse sur d’autres. En recadrant le problème géométriquement, nous visons à construire l’intuition pour quels modèles préférer pour apprendre et pourquoi.

Exploration

1. Une histoire de deux apprenants

Imaginez deux réseaux de neurones formés sur les mêmes données. L’un est un MLP peu profond; L’autre est un réseau neuronal convolutionnel. Les deux convergent vers une faible erreur de formation. Pourtant leur comportement de généralisation diffère considérablement.

Pourquoi?

Parce que même si les deux architectures sous-jacentes sont des «approximateurs universels», le forme de leurs espaces d’hypothèse est différent. Le MLP n’a pas de notion intégrée de localité ou d’invariance de traduction. Il doit apprendre de tels biais inductifs à partir de zéro. Le CNNen revanche, commence par une géométrie: la localité spatiale est cuite.

Cette différence ne reflète pas seulement un changement dans quoi Les fonctions sont représentables, mais dans Comme c’est facile pour que l’optimiseur trouve et préfère certaines solutions. L’architecture définit non seulement une frontière autour de l’espace, mais un paysage pondéré au-dessus.

2. Des fonctions aux collecteurs

Pour rendre cela précis, pensez à l’espace d’hypothèse comme un variateur intégré dans un espace de fonction plus grand. Une architecture sculpte un sous-manifold des fonctions qu’il peut exprimer. Mais ce n’est pas une surface plate et uniforme. Il a:

- Courbure: Certaines fonctions sont plus faciles à atteindre (courbure inférieure), d’autres plus difficiles (raide gradientscompositions complexes).

- Volume: Certaines classes de fonction occupent plus «espace» – par exemple, les réseaux peu profonds modélisent plus facilement les fonctions linéaires ou basse fréquence.

- Topologie: Certaines architectures appliquent la continuité ou les symétries que d’autres ne le font pas.

Cela nous amène à un géométrique apprentissage en profondeur lentille: les priors architecturaux façonnent le métrique et topologie de l’espace d’hypothèse (2). CNNS favorise les fonctions équivariantes traductionnelles. GNNS favorise l’invariance de la permutation. Transformers? Interactions mondiales pondérées en gamme.

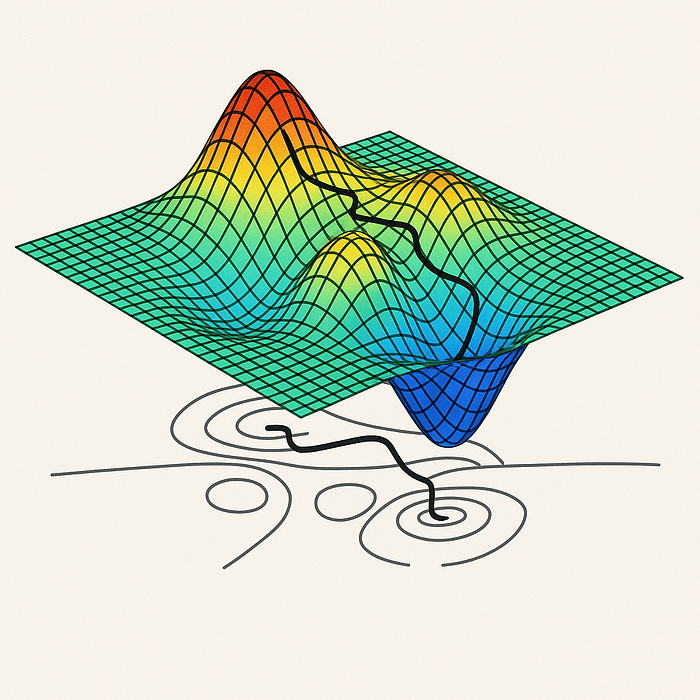

L’optimiseur n’explore pas tout l’espace des fonctions – il coule le long de ce collecteur courbe et structuré défini par l’architecture.

3. Régularisation comme mesure sur l’espace d’hypothèse

Entrez maintenant la régularisation. Dans sa forme classique (par exemple, norme L2), elle est souvent interprétée comme une complexité pénalisante. Mais cette vue est limitée. Plus profondément, la régularisation définit un mesure Sur l’espace d’hypothèse – une façon de dire: « Ces fonctions sont plus probables. Celles-ci sont suspectes. »

L’abandon, par exemple, s’appuie sur des unités spécifiques, favorisant des représentations plus distribuées. La régularisation de la norme spectrale limite la continuité de Lipschitz, biaisant vers des fonctions plus lisses. Les réseaux de neurones bayésiens rendent cette idée explicite: les poids antérieurs induisent des fonctions antérieures.

Vu de cette façon, la régularisation n’est pas une contrainte sur l’apprentissage – c’est un force de mise en forme. Il sculpte le paysage énergétique. Il modifie les vallées que l’optimiseur est le plus susceptible de s’installer.

Cela devient particulièrement intéressant lorsque nous réalisons que différents régulateurs et architectures peuvent interagir non linéaire. Un régulariseur qui améliore la généralisation dans une architecture peut le blesser dans un autre, simplement parce que l’espace d’hypothèse sous-jacent est incurvé ou composé différemment.

Résolution

Un cadrage géométrique du biais d’apprentissage

Affusons la revendication centrale:

L’apprentissage est un processus de déplacement le long d’un collecteur structuré, défini par l’architecture, suivant un champ d’écoulement façonné par la régularisation, à la recherche d’un état de faible énergie défini par la fonction de perte.

Dans ce cadrage:

- Architecture définit le collecteur des fonctions que le modèle peut exprimer – le terrain sur lequel l’apprentissage se produit.

- Régularisation impose un densité ou champ potentiel Sur ce terrain – certaines directions deviennent plus faciles, certaines plus difficiles.

- La fonction de perte définit le paysage énergétique – Il nous dit où se trouvent les vallées, où le modèle doit s’installer.

L’algorithme d’optimisation – généralement une descente de gradient – agit comme un navigateur. Mais il ne traverse pas tout l’espace des fonctions. Il coule le long de ce variateur, biaisé par la régularisation, vers des régions de faible perte.

Cette perspective recadre la généralisation non pas comme une simple convergence, mais comme un Descente de biais sur un collecteur incurvéoù la géométrie et la préférence façonnent le résultat final.

Conclusion

Concevoir avec la géométrie à l’esprit

Si nous acceptons que l’architecture et la régularisation façonnent conjointement l’espace d’hypothèse, alors plusieurs informations stratégiques suivent:

- Choix architecturaux doit être guidé non seulement par des performances empiriques, mais par la compréhension Quel genre de multiples ils induisent. La géométrie compte.

- Stratégies de régularisation devrait être réglé sur l’architecture – non seulement en termes hyperparamètres, mais en termes philosophiques: Quel type de fonctions favorisons-nous?

- Future Research Pourrait bénéficier de caractérisations explicites de ces variétés: pouvons-nous cartographier le biais implicite de différents modèles, voire interpoler entre les espaces d’hypothèse?

Peut-être le plus provocateur: nous voulons peut-être concevoir des architectures et des régulateurs en tandemcomme instruments complémentaires dans la sculpture du paysage fonctionnel du modèle.

Ce n’est pas un appel à abandonner les méthodes empiriques. Mais c’est un appel pour les infuser d’une conscience géométrique et probabiliste. Penser non seulement en termes de performance, mais de préférence – Ce que nos modèles sont prédisposés à apprendre et pourquoi.

Si géométrique apprentissage en profondeur nous a appris que les données vivent sur un collecteur, alors peut-être que la prochaine leçon est la suivante: Alors, faites nos modèles.

Références

- (1) Poggio et al., «Theory of Deep Learning III: Expliquer le puzzle non sur le standard»

- (2) Bronstein et al., «Géométrique Deep Learning: grilles, groupes, graphiques, géodésiques et jauges»

Publié via Vers l’IA

Source link