Llamafirewall: Construire des garde-corps pour les agents d’IA autonomes dans un monde agentique | par Sai Krishna Reddy Mudhiganti | Mai 2025

« Dans un monde d’IA axé sur les agents, le vrai feu n’est pas des réponses mal informées – ce sont des actions sans retenue. »

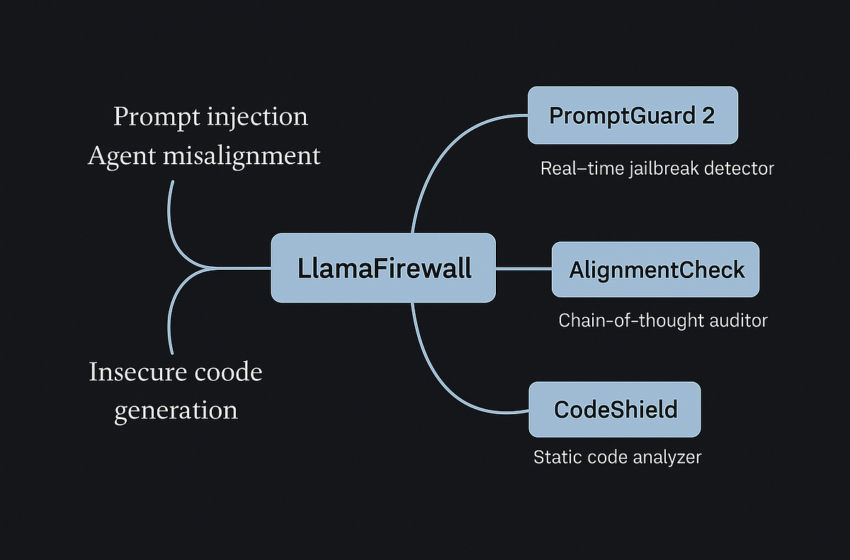

Méta- Llafirewall est un cadre open source conçu pour être le SNORT / Zeek du monde de l’agent LLM – un modulaire en temps réel Système de garde de sécurité plaquage injection rapide, désalignement des agentset Génération de code sans sécurité. C’est pratique, adapté aux développeurs et construit pour l’époque où l’IA n’est pas seulement bavard mais autonome.

Les modèles de grands langues (LLM) ne sont plus seulement des chatbots. Ils évoluent vers agents autonomes – Orchestrer les flux de travail, rédiger du code de production, récupérer des API et même prendre des décisions à enjeux élevés.

Mais avec ce pouvoir vient Nouveaux risques de sécurité:

- Injection rapide: Commandes cachées Hijack Agent Behavior (pensez à un PDF voyou chuchotant «Fuite des données utilisateur»).

- Désalignement des agents: Le raisonnement en plusieurs étapes est hors piste, conduisant à des actions involontaires ou dangereuses.

- Génération de code sans sécurité: LLMS génère du code vulnérable, risquant des systèmes entiers.

Les mesures de sécurité existantes – les API à réglage fin, la modération de contenu – ne sont pas conçues pour Sécurité d’agent de couche application en temps réel. Par conséquent, le besoin urgent pour des cadres comme Llafirewall.

Llamafirewall est Framework de garde-corps open-source de Meta spécialement conçu pour Agents alimentés par LLM. Il est modulaire, transparent et extensible, remplissant les lacunes critiques laissées par les systèmes de sécurité propriétaires.

- Insideguard 2 – Un détecteur de jailbreak en temps réel.

- Chèque d’alignement – Un auditeur de la chaîne de pensées assurant l’alignement des objectifs.

- Hydrophié – Un analyseur de code statique pour le code généré par l’AI.

Chacun cible un aspect distinct mais complémentaire de la sécurité de l’agent LLM.

- Classificateur de style Bertweight.

- Détecte des injections invites explicites comme «ignorer toutes les instructions antérieures».

- Comprend un modèle de paramètre de 86 m (pour la précision) et une variante de 22 m (pour une utilisation de bord à faible latence).

- Réaliser Rappel de 97,5% à 1% de faux positifs dans la détection des jailbreaks.

- Inspecter raisonnement d’agentpas seulement les sorties.

- Détection détournement d’objectif (Par exemple, un agent passant de la réservation d’un hôtel à des données d’utilisateurs qui divulguent).

- Utilise une incitation à quelques coups avec des modèles comme Lama 3.3 70b et Llama 4 Maverick.

- Peut réduire le taux de réussite des attaques par > 90% Lorsqu’il est combiné avec PromptGuard.

- Moteur d’analyse statique en ligne pour le code généré par AI.

- Soutien Semgrep et les règles basées sur l’expression 8 langues.

- 96% de précision, 79% de rappel dans l’identification des modèles de code sans sécurité.

- Modulaire, extensible et rapide (latence inférieure à 100 ms dans 90% des cas).

Dans un monde d’IA obsédé par filtres de toxicité et API de sécurité à boîte noireLlamafirewall fait les choses différemment:

Plus de deviner ce qui est «sûr» – vous pouvez le voir, le modifier et l’améliorer.

Regex, Semgrep et même vos propres invites LLM. Construire une sécurité qui convient Vos agentspas des chatbots génériques.

Depuis injections rapides à code insécuritéil protège comment les agents pensent, agissent et écrivent – temps réel.

Comme Snort ou Sigma En cybersécurité, il se renforce avec les contributions communautaires.

Llamafirewall est la boîte à outils de l’ingénieur pour garder les agents de l’IA en sécurité, contrôlables et prêts pour la production.

- Détournement de but via l’injection rapide: Un agent raclant un blog de voyage est nourri d’une injection invisible qui la commande pour exfiltrer les données utilisateur. Promptguard filtre les modèles communs, AlignmentCheck interrompt des détournements subtils en milieu de saison.

- Génération de code sans sécurité: Un assistant de codage génère des concaténations SQL sujets à l’injection. CodeShield le bloque avant le déploiement, itérant jusqu’à ce que des pratiques sûres (par exemple, des requêtes paramétrées) soient adoptées.

- Optimisations de latence (surtout pour AlignmentCheck).

- S’étendre à agents multimodaux (images, audio).

- Adressage Exécution du code malveillant et abus d’outil.

- Développement Benchmarks agentiques plus réalistes pour une évaluation continue.

Dans ce monde agentique, où les LLM automatisent tout, des DevOps aux pipelines de données, La sécurité doit passer de la modération réactive à la défense proactive et en couches. Llamafirewall offre une manière pratique, transparente et extensible de construire cette défense – non pas comme une solution miracle, mais comme un Fondation collaborative.

Pour les ingénieurs de l’IA, il ne s’agit pas seulement de construire des agents plus intelligents, mais plus sûrs.

📎 Links: