Échelle d’intelligence: surmonter les défis des infrastructures dans les opérations de modèle de grande langue

Auteur (s): Rajarshi Tarafdar

Publié à l’origine sur Vers l’IA.

Le scénario est assez éclaircissant pour l’intelligence artificielle (IA) et Modèles de grande langue (LLMS) – activer les fonctionnalités des chatbots aux systèmes de prise de décision avancés.

Cependant, rendre ces modèles compatibles avec les cas d’utilisation de l’entreprise est un grand défi, qui doit être abordé avec une infrastructure de pointe.

L’industrie change rapidement, mais plusieurs défis restent ouverts pour éventuellement créer des LLM à grande échelle opérationnelles. Cet article traite de ces défis des infrastructures et fournit des conseils aux entreprises sur le point de les surmonter pour capturer les riches avantages des LLM.

Croissance et investissement du marché dans les infrastructures LLM

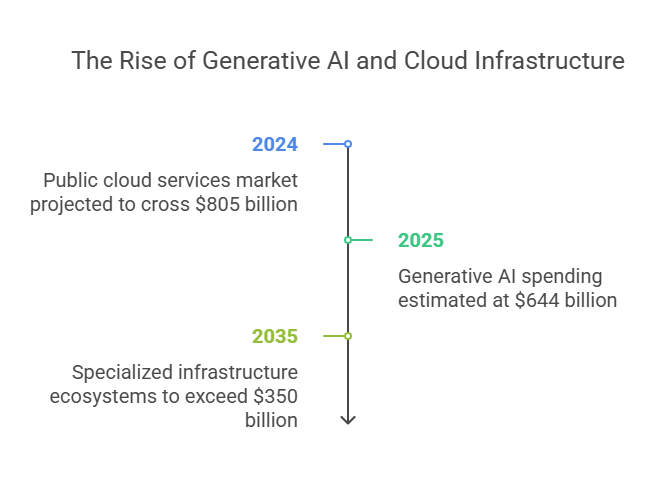

Le marché mondial de l’IA génératif se déroule comme jamais auparavant. À tel point qu’il est estimé que, dans l’année où la lune arrive en 2025, Les dépenses en IA générative seront de 644 milliards de dollars, dont 80% seront consommés sur le matériel tel que les serveurs et les appareils Ai-Adowed.

L’automatisation, l’efficacité et les idées ont été d’autres facteurs importants stimulant l’augmentation qui a des entreprises intégrant les LLM dans leurs flux de travail pour pouvoir utiliser encore plus d’applications alimentées par l’IA.

En outre, selon les projections, le marché des services de cloud public traversera 805 milliards de dollars en 2024 et augmentera à un taux de croissance annuel composé de 19,4% (TCAC) au cours de 2024.

L’infrastructure cloud est un catalyseur clé pour les LLM car les entreprises aident les entreprises à acquérir la puissance informatique requise pour exécuter de grands modèles sans dépenser fortement en équipement en interne ou physique. Ces approches basées sur le cloud ont également provoqué des développements dans les écosystèmes d’infrastructure spécialisés qui dépasseront 350 milliards de dollars d’ici 2035.

Défis de base de l’infrastructure dans la mise à l’échelle des LLM

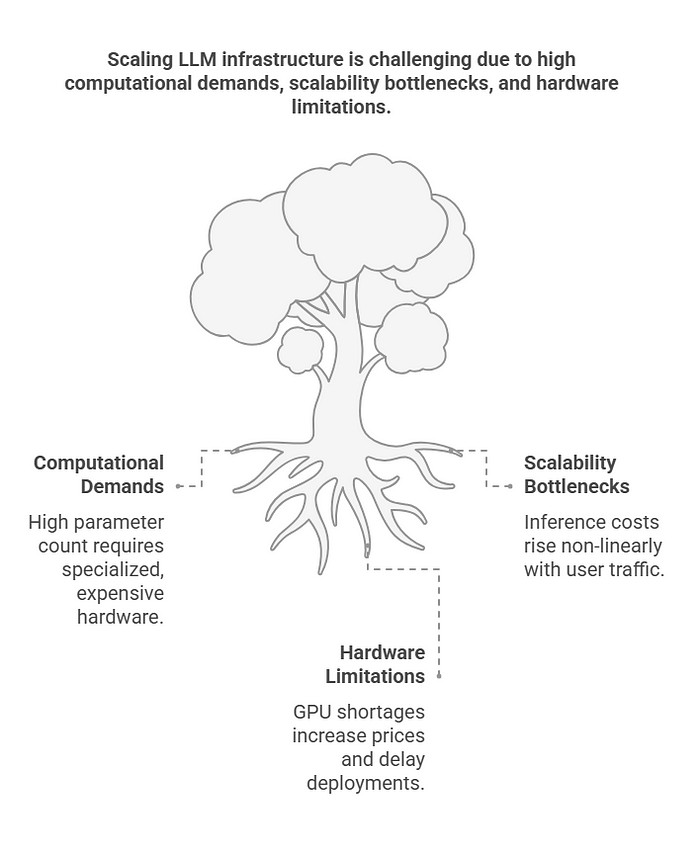

Malgré l’immense opportunité de marché, il existe plusieurs défis de base auxquels les organisations sont confrontées lors de la mise à l’échelle de l’infrastructure LLM à usage d’entreprise.

1. Demandes de calcul

Les exigences de calcul se classent parmi les défis les plus graves auxquels sont confrontés la mise à l’échelle des LLM. Par exemple, les LLM modernes comme GPT-4 ont environ 1,75 billion de paramètres et des exigences de calcul massives en conséquence pour les tâches de formation et d’inférence.

Pour répondre à ces exigences, les entreprises ont besoin de matériel spécialisé comme les GPU (unités de traitement des graphiques) ou les TPU (unités de traitement du tenseur). Mais l’achat et le maintien de ces processeurs à haute performance peuvent atteindre des niveaux exorbitants.

L’économie de la formation de ces LLM ajoute à la préoccupation. Peut-être que 10 millions de dollars ou plus seraient le coût de l’énergie et du matériel pour développer un modèle de pointe. De plus, comme les LLMS consomment de grandes quantités d’énergie pendant la formation et même lors du déploiement, il s’agit d’un fardeau environnemental et financier supplémentaire.

Une autre chose importante ici est les contraintes de latence. Les entreprises mondiales ont besoin de leurs LLM pour fournir des réponses à faible latence aux utilisateurs finaux dans de nombreuses régions; Cela peut souvent nécessiter le déploiement d’instances du modèle dans de nombreuses régions, ajoutant une autre couche de complication à la configuration de l’infrastructure. Un acte d’équilibrage consiste à gérer la latence et à assurer la cohérence dans les différentes régions.

2. Les goulots d’étranglement d’évolutivité

La mise à l’échelle des opérations LLM apporte un autre défi que le coût d’inférence augmente non linéaire avec une augmentation du trafic utilisateur. L’utilisation de LLMS pour desservir des milliers ou des millions d’utilisateurs peut être liée aux ressources et exiger que la solution de mise à l’échelle soit donc mise en place pour être en mesure de mettre à l’échelle des ressources dynamiquement en fonction de la demande des utilisateurs.

En d’autres termes, la mise à l’échelle des ressources affecterait l’infrastructure traditionnelle lourde pour pouvoir satisfaire des demandes croissantes des applications LLM de qualité d’entreprise, ce qui entraînera des retards évitables et une augmentation des coûts opérationnels.

L’autre défi avec les opérations de mise à l’échelle LLM est une augmentation des coûts d’inférence sur une échelle presque non linéaire le long de la courbe à mesure que le trafic utilisateur augmente. Il existe des tâches très lourdes de ressources impliquées dans l’utilisation de LLMS: le service de milliers, voire des millions d’utilisateurs, signifierait que des solutions de mise à l’échelle dynamiques sont nécessaires, ajustant automatiquement les ressources en fonction de la demande.

En bref, ces opérations de mise à l’échelle peuvent nuire à l’infrastructure traditionnelle des poids lourds qui est censée satisfaire à la demande continuellement importante des applications LLM au niveau de l’entreprise, ce qui entraîne de nombreux retards indésirables et des coûts opérationnels.

3. Limites matérielles

Les contraintes matérielles des LLMS de mise à l’échelle sont significatives. En 2024, le monde La pénurie de GPU a augmenté les prix de 40%mettre en attente des applications basées sur les LLM dans toutes les industries.

En raison d’un accès limité aux GPU, les organisations doivent souvent différer et attendre l’entrepôt car cela peut perturber beaucoup de délais.

De plus, les LLM de plus en plus complexes nécessitent plus de mémoire, donc un stress supplémentaire sur les ressources matérielles. L’une des techniques pour résoudre ce problème est la quantification, ce qui réduit la précision tout en calculant avec le modèle.

Cela mène à consommer entre 30 et 50 pour cent de la moindre mémoire Sans avoir un impact sur la précision du modèle, améliorant ainsi l’utilisation des ressources matérielles construites par les organisations.

Stratégies d’entreprise pour la mise à l’échelle des opérations LLM

Pour relever les défis de la mise à l’échelle de l’infrastructure LLM, les entreprises ont développé plusieurs stratégies innovantes qui combinent des correctifs à court terme et des investissements à long terme dans la technologie.

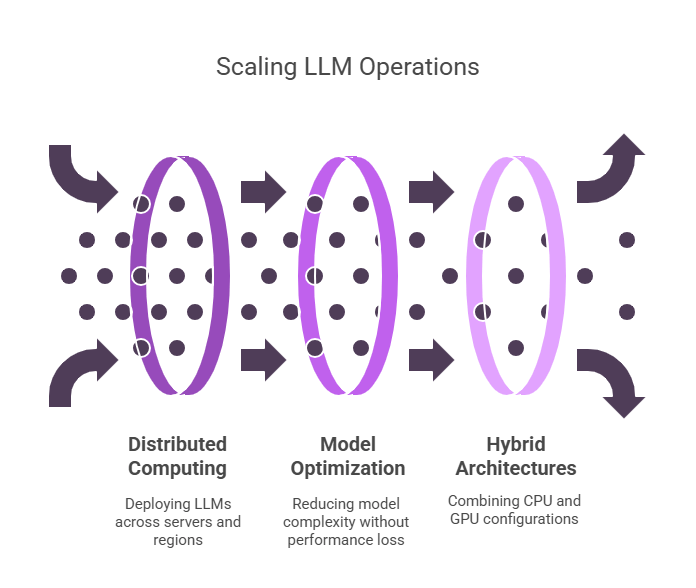

1. Informatique distribuée

La mise à l’échelle des LLM par l’informatique distribuée est un de ces moyens. Les organisations exploitent des clusters de Kubernetes avec des solutions de mise à l’échelle de cloud peuvent déployer et faire évoluer efficacement les LLM sur divers serveurs et régions.

Les différents emplacements géographiques aident réduire la latence de 35% Pour les utilisateurs mondiaux, maintenir les applications LLM réactives sous une charge lourde.

2. Optimisation du modèle

Une autre stratégie essentielle à considérer est l’optimisation du modèle. En éliminant les paramètres qui ne sont pas utiles, les organisations peuvent optimiser la complexité de leurs modèles en utilisant des techniques telles que la distillation des connaissances sans aucun impact sur les performances.

Ces optimisations peuvent fournir 25% de réduction des coûts d’inférenceaméliorant ainsi la faisabilité de l’échelle pour le déploiement de LLMS dans les applications d’entreprise.

3. Architectures hybrides

De nombreuses organisations se tournent vers des architectures hybrides, qui combinent le processeur et GPU Configurations pour optimiser les performances et le coût.

En utilisant des GPU pour des modèles plus grands et des processeurs pour les modèles plus petits ou les tâches auxiliaires, Les entreprises peuvent réduire les dépenses matérielles de 50% Tout en maintenant les performances nécessaires pour répondre aux demandes opérationnelles.

Données et personnalisation dans SCALING LLMS

La qualité des données et la personnalisation du modèle sont des conditions préalables pour obtenir les meilleures performances lors de la mise à l’échelle des LLM. Ici, couchez les LLM dans des applications spécifiques des domaines de réglage des affaires pour la meilleure précision.

Jusqu’à 60% de la précision des tâches peuvent être améliorés par le réglage fin applicable à un domaine spécifique dans des industries typiques comme la finance, devoir identifier la fraude avec précision et efficacement.

De plus, la génération (RAG) (RAG) de la récupération est une approche forte pour améliorer la capacité des LLM dans les applications d’entreprise. Le chiffon réduit les hallucinations de 45% dans des systèmes tels que les systèmes de réponse aux questions (QA) au niveau de l’entreprise.

De cette façon, il combine la puissance des LLM classiques et des mécanismes de récupération externes afin d’augmenter les performances. En plus d’améliorer la précision des modèles, les organisations feraient également un système d’IA plus fiable.

Un défi majeur aux projets d’IA a été la mauvaise qualité des données. Il a affecté Au moins 70% des projets d’IAles retarder en raison du besoin très réel de haute qualité et alignée sur la langue ensembles de données.

Pour une mise à l’échelle efficace au sein de l’infrastructure LLM d’une organisation, il devient essentiel d’investir dans une qualité robuste de haute qualité pipelines de données et les opérations de nettoyage.

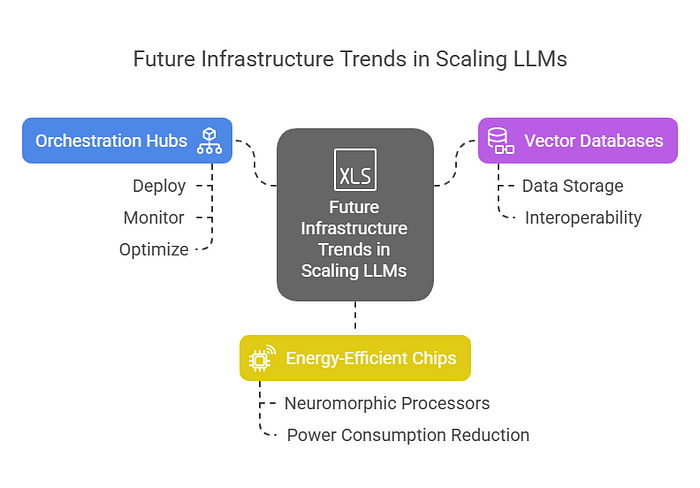

Tendances futures de l’infrastructure dans la mise à l’échelle LLMS

En regardant vers l’avenir, plusieurs tendances des infrastructures devraient jouer un rôle central dans la mise à l’échelle des LLM.

1. Côtes d’orchestration pour réseaux multi-modèles

À mesure que l’utilisation de LLMS devient plus répandue, les entreprises s’appuieront de plus en plus sur les centres d’orchestration pour gérer les réseaux multimodèles. Ces hubs permettront aux organisations de déployer, de surveiller et d’optimiser des milliers de LLM spécialisés, permettant une allocation efficace des ressources et une amélioration des performances à grande échelle.

2. Bases de données vectorielles et normes d’interopérabilité

L’essor des bases de données vectorielles et des normes d’interopérabilité changera la donne pour la mise à l’échelle des LLM. Ces bases de données permettront aux LLM apprentissage automatique applications.

À mesure que le marché de ces technologies se développe, ils devraient dominer 20 milliards de dollars + marchés d’ici 2030.

3. Chips économes en énergie

L’un des développements les plus excitants de la mise à l’échelle des LLM est l’émergence de puces économes en énergie, telles que les processeurs neuromorphiques.

Ces puces promettent de réduire la consommation d’énergie de LLMS jusqu’à 80%, ce qui rend plus durable le déploiement de LLMS à grande échelle sans encourir des coûts énergétiques prohibitifs.

Applications et compromis réels

Ces derniers temps, plusieurs organisations qui ont réussi à mettre à l’échelle les opérations de LLM attestent des avantages acquis.

Une institution financière a pu réduire 40% des coûts d’analyse de la fraude en utilisant le parallélisme du modèle dans 32 GPU, alors que dans le cas d’un fournisseur de soins de santé, LLMS améliorés par Rag a atteint une réduction de 55% des taux d’erreur de diagnostic.

Cependant, les entreprises sont désormais confrontées à des compromis entre les correctifs rapides et les investissements à long terme.

Les paradigmes tels que la quantification et la mise en cache offrent un soulagement rapide concernant l’optimisation de la mémoire et du coût, tandis que la mise à l’échelle à long terme nécessitera un investissement dans l’architecture modulaire, les puces économes en énergie et l’infrastructure d’IA de nouvelle génération.

Conclusion

Scaling LLMS est une activité majeure à forte intensité de ressources et d’efforts, qui est nécessaire pour débloquer les applications d’IA dans les entreprises.

Si les organisations peuvent améliorer et rendre les opérations LLM plus rentables en relevant des défis clés de l’infrastructure, à savoir les exigences de calcul, les goulots d’étranglement et les limitations matérielles, les entreprises seront sur la bonne voie.

Avec les bonnes approches, allant de l’informatique distribuée, du réglage fin spécifique au domaine, les entreprises peuvent faire évoluer leurs capacités d’IA pour répondre à la demande émergente d’applications intelligentes.

Comme l’écosystème LLM continue d’évoluer, les investissements soutenus dans les infrastructures seront cruciaux pour favoriser la croissance et garantir que l’IA reste un outil révolutionnaire dans diverses industries.

Publié via Vers l’IA

Source link