Utiliser la langue pour donner aux robots une meilleure compréhension d’un monde ouvert

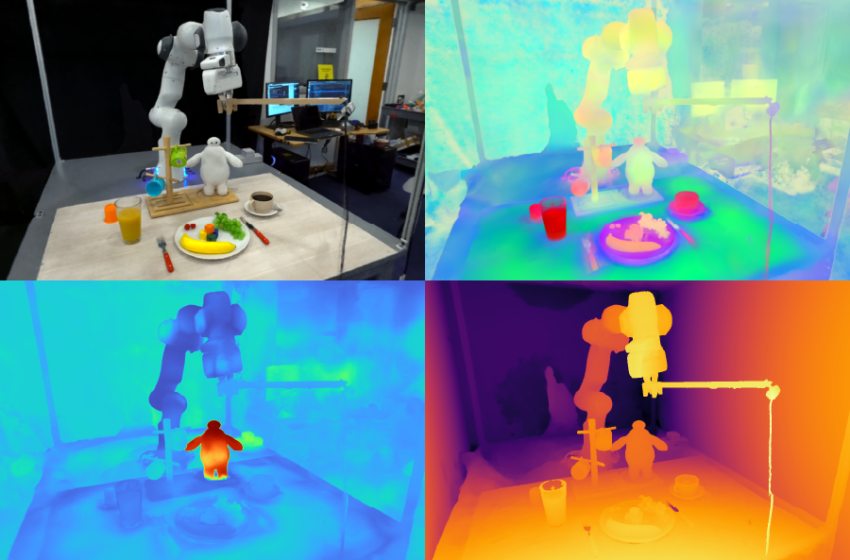

Les champs de caractéristiques pour la manipulation robotique (F3RM) permettent aux robots d’interpréter les invites de texte ouvertes en utilisant le langage naturel, aidant les machines à manipuler des objets inconnus. Les champs de fonctionnalités 3D du système pourraient être utiles dans des environnements qui contiennent des milliers d’objets, tels que les entrepôts. Images gracieuseté des chercheurs.

Par Alex Shipps | MIT CSAIL

Imaginez que vous visitez un ami à l’étranger et que vous regardez à l’intérieur de leur réfrigérateur pour voir ce qui ferait un excellent petit-déjeuner. De nombreux articles vous apparaissent initialement à l’étranger, chacun étant enfermé dans des emballages et des conteneurs inconnus. Malgré ces distinctions visuelles, vous commencez à comprendre ce que chacun est utilisé et les ramasser au besoin.

Inspiré par la capacité des humains à gérer des objets inconnus, un groupe de l’informatique et du laboratoire d’intelligence artificielle (CSAIL) du MIT (CSAIL) pour la manipulation robotique (F3RM), un système qui mélange des images 2D avec des fonctions de modèle de fondation en scènes 3D pour aider les robots à identifier et à saisir les éléments à proximité. F3RM Peut interpréter les invites en langage ouvert des humains, ce qui rend la méthode utile dans des environnements réels qui contiennent des milliers d’objets, comme les entrepôts et les ménages.

F3RM offre aux robots la possibilité d’interpréter les invites de texte ouvertes en utilisant le langage naturel, aidant les machines à manipuler des objets. En conséquence, les machines peuvent comprendre les demandes moins spécifiques des humains tout en terminant la tâche souhaitée. Par exemple, si un utilisateur demande au robot de «ramasser une tasse haute», le robot peut localiser et saisir l’article qui correspond le mieux à cette description.

«Faire des robots qui peuvent réellement généraliser dans le monde réel est incroyablement difficile», dit GE YANGPostdoc au National Science Foundation AI Institute for Artificial Intelligence and Fondamental Interactions and MIT CSAIL. «Nous voulons vraiment comprendre comment procéder, donc avec ce projet, nous essayons de faire pression pour un niveau de généralisation agressif, de seulement trois ou quatre objets à tout ce que nous trouvons dans le centre Stata du MIT. Nous voulions apprendre à rendre les robots aussi flexibles que nous-mêmes, car nous pouvons saisir et placer des objets même si nous ne les avons jamais vus auparavant.»

Apprendre «Qu’est-ce que c’est là qu’en regardant»

La méthode pourrait aider les robots à choisir des articles dans de grands centres de réalisation avec un encombrement et une imprévisibilité inévitables. Dans ces entrepôts, les robots reçoivent souvent une description de l’inventaire qu’elles sont nécessaires pour identifier. Les robots doivent correspondre au texte fourni à un objet, quelles que soient les variations de l’emballage, afin que les commandes des clients soient expédiées correctement.

Par exemple, les centres de réalisation des principaux détaillants en ligne peuvent contenir des millions d’articles, dont beaucoup un robot n’aura jamais rencontré auparavant. Pour fonctionner à une telle échelle, les robots doivent comprendre la géométrie et la sémantique de différents éléments, certains étant dans des espaces serrés. Avec les capacités avancées spatiales et sémantiques avancées de F3RM, un robot pourrait devenir plus efficace pour localiser un objet, le placer dans un bac, puis l’envoyer pour l’emballage. En fin de compte, cela aiderait les travailleurs d’usine à expédier les commandes des clients plus efficacement.

«Une chose qui surprend souvent les personnes atteintes de F3RM, c’est que le même système fonctionne également sur une pièce et une échelle de construction, et peut être utilisé pour construire des environnements de simulation pour l’apprentissage des robots et les grandes cartes», explique Yang. « Mais avant d’étendre ce travail plus loin, nous voulons d’abord que ce système fonctionne très rapidement. De cette façon, nous pouvons utiliser ce type de représentation pour des tâches de contrôle robotiques plus dynamiques, espérons-le en temps réel, afin que les robots qui gèrent des tâches plus dynamiques puissent l’utiliser pour la perception. »

L’équipe du MIT note que la capacité de F3RM à comprendre différentes scènes pourrait la rendre utile dans les environnements urbains et ménagers. Par exemple, l’approche pourrait aider les robots personnalisés à identifier et à ramasser des éléments spécifiques. Le système aide les robots dans la saisie de leur environnement – à la fois physiquement et avec perception.

«La perception visuelle a été définie par David Marr comme le problème de savoir` `ce qui est où en regardant », explique l’auteur principal Phillip IsolaProfesseur agrégé du MIT en génie électrique et en informatique et chercheur principal de CSAIL. «Les modèles de fondations récents sont devenus vraiment bons pour savoir ce qu’ils regardent; ils peuvent reconnaître des milliers de catégories d’objets et fournir des descriptions de texte détaillées d’images.

Création d’un «jumeau numérique»

F3RM commence à comprendre son environnement en prenant des photos sur un bâton de selfie. La caméra montée prend 50 images à différentes poses, ce qui lui permet de construire un Champ de radiance neurale (Nerf), une méthode d’apprentissage en profondeur qui prend des images 2D pour construire une scène 3D. Ce collage de photos RVB crée un «jumeau numérique» de son environnement sous la forme d’une représentation à 360 degrés de ce qui se trouve à proximité.

En plus d’un champ de radiance neuronale très détaillée, F3RM construit également un champ de fonctionnalités pour augmenter la géométrie avec des informations sémantiques. Le système utilise AGRAFEun modèle de fondation Vision formé sur des centaines de millions d’images pour apprendre efficacement les concepts visuels. En reconstruisant les caractéristiques du clip 2D pour les images prises par le Selfie Stick, F3RM soulève efficacement les fonctionnalités 2D en une représentation 3D.

Garder les choses ouvertes

Après avoir reçu quelques démonstrations, le robot applique ce qu’il sait de la géométrie et de la sémantique pour saisir des objets qu’il n’a jamais rencontrés auparavant. Une fois qu’un utilisateur soumet une requête texte, le robot recherche dans l’espace des landes possibles pour identifier les plus susceptibles de réussir à ramasser l’objet demandé par l’utilisateur. Chaque option potentielle est notée en fonction de sa pertinence pour l’invite, une similitude avec les démonstrations sur lesquelles le robot a été formé et si elle provoque des collisions. La saisie la plus scorée est ensuite choisie et exécutée.

Pour démontrer la capacité du système à interpréter les demandes ouvertes des humains, les chercheurs ont incité le robot à prendre Baymax, un personnage du «Big Hero 6» de Disney. Alors que F3RM n’avait jamais été directement formé pour ramasser un jouet du super-héros de dessin animé, le robot a utilisé sa conscience spatiale et ses fonctionnalités de vision des modèles de fondation pour décider de l’objet à saisir et comment le ramasser.

F3RM permet également aux utilisateurs de spécifier l’objet qu’ils souhaitent que le robot gére à différents niveaux de détails linguistiques. Par exemple, s’il y a une tasse en métal et une tasse en verre, l’utilisateur peut demander au robot la «tasse en verre». Si le bot voit deux tasses en verre et que l’une d’entre elles est remplie de café et l’autre de jus, l’utilisateur peut demander la «tasse en verre avec du café». Les fonctionnalités du modèle de fondation intégrées dans le champ de fonctionnalités permettent ce niveau de compréhension ouverte.

«Si je montrais à une personne comment ramasser une tasse par la lèvre, elle pourrait facilement transférer ces connaissances pour ramasser des objets avec des géométries similaires telles que des bols, mesurer les béchers ou même des rouleaux de ruban adhésif. Pour les robots, la réalisation de ce niveau d’adaptabilité a été assez difficile» William Shen. « F3RM combine la compréhension géométrique avec la sémantique à partir de modèles de fondation formés sur des données à l’échelle d’Internet pour permettre ce niveau de généralisation agressive à partir d’un petit nombre de démonstrations. »

Shen et Yang ont écrit le journal sous la supervision d’Isola, avec le professeur du MIT et chercheur principal de CSAIL, Leslie Pack Kaelbling et les étudiants de premier cycle Alan Yu et Jansen Wong en tant que co-auteurs. L’équipe a été soutenue, en partie, par Amazon.com Services, la National Science Foundation, le Bureau de la recherche scientifique de l’Air Force, l’initiative universitaire multidisciplinaire du Bureau de la recherche navale, le Bureau de la recherche de l’armée, le MIT-IBM Watson Lab et le MIT Quest for Intelligence. Leur travail sera présenté lors de la conférence de 2023 sur l’apprentissage des robots.

NOUVELLES MIT