Le test de Turing a un problème – et le GPT-4.5 d’Openai vient de l’exposer

La plupart des gens savent que le Test de Turing célèbreune expérience de pensée conçue par le pionnier informatique Alan Turing, est une mesure populaire du progrès dans l’intelligence artificielle.

Beaucoup supposent à tort, cependant, que c’est la preuve que les machines pensent réellement.

Les dernières recherches sur le test de Turing des chercheurs de l’Université de Californie à San Diego montrent que le dernier modèle de grande langue d’Openai, GPT-4.5peut tromper les humains en pensant que le modèle d’IA est une personne dans les chats de texte, encore plus qu’un humain peut convaincre une autre personne qu’ils sont humains.

Aussi: Comment utiliser Chatgpt: un guide du débutant sur le chatbot IA le plus populaire

C’est une percée dans la capacité de la génération AI à produire une sortie convaincante en réponse à une invite.

Preuve d’Agi?

Mais même les chercheurs reconnaissent que battre le test de Turing ne signifie pas nécessairement que « intelligence générale artificielle« ou Agi, a été atteint – un niveau de traitement informatique équivalent à la pensée humaine.

L’érudit AI Melanie Mitchell, professeur à l’Institut Santa Fe à Santa Fe, Nouveau-Mexique, a écrit Dans la revue savante scientifique, le test de Turing est moins un test d’intelligence en soi et plus un test d’hypothèses humaines. Malgré des scores élevés à l’épreuve, « la capacité de paraître couramment le langage naturel, comme jouer aux échecs, n’est pas une preuve concluante de l’intelligence générale », a écrit Mitchell.

La dernière réussite à consonance convaincante est décrite par Cameron Jones et Benjamin Bergen de UC San Diego dans un journal Publié sur le serveur pré-imprimé Arxiv cette semaineintitulé « Les grands modèles de langue passent le test de Turing. »

Aussi: Openai élargit le déploiement GPT-4.5. Voici comment accéder (et ce qu’il peut faire pour vous)

Le document est le dernier épisode d’une expérience que Jones et Bergen gèrent depuis des années avec la participation des étudiants de premier cycle de l’UC San Diego du département.

Comme les auteurs le notent, il y a eu des décennies de travail sur le problème. À ce jour, il y a eu « plus de 800 réclamations et contre-arguments distincts qui ont été faits » sur les ordinateurs passant le test.

Comment fonctionne le test Turing

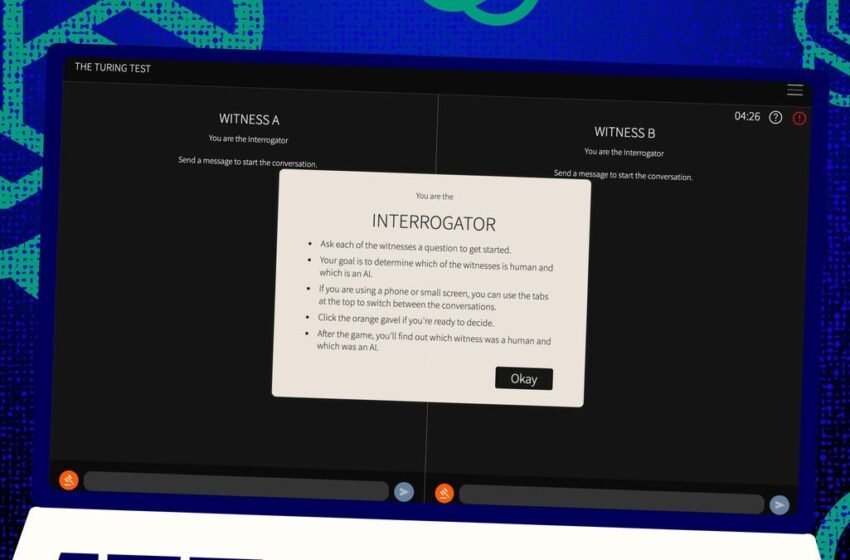

Le test de Turing a été conçu classiquement par Turing comme une série de messages texte qui passent entre un « juge » humain et deux « témoins », un humain et un ordinateur.

L’ordinateur et les témoins humains ont été accusés d’avoir convaincu le juge humain qu’ils étaient humains par les messages que chacun a envoyé. Le juge ne sait qu’un seul des deux est humain, mais pas lequel est lequel, et doit deviner.

Cette forme à trois est essentielle. Cela signifie que si le juge juge à tort un humain informatique, le juge manquait également les indices qu’ils auraient dû obtenir de l’humain sur l’humanité.

Aussi: Avec les modèles d’IA qui obtiennent chaque référence, il est temps pour l’évaluation humaine

En d’autres termes, c’est un test autant sur la façon dont les humains perçoivent et croient comme il s’agit du fonctionnement informatique.

La conception mise à jour de Jones et Bergen est publiée en ligne, Et vous pouvez jouer au jeu vous-même, en tant que juge ou témoin.

Comme dans les versions antérieures, les étudiants humains de l’UC San Diego ont été invités à s’engager dans une application de chat texte. Certains étudiants ont joué le juge et certains le témoin humain dans des échanges de chat randomisés de cinq minutes, tandis que GPT-4.5 a joué le témoin informatique. Chaque juge a eu des conversations simultanées avec un témoin humain et un témoin informatique pour s’adapter à la forme à trois voies de la formulation de Turing.

Pour jouer au témoin informatique, plusieurs modèles de gros langues ont été utilisés, dans les défis du juge dans une invite. GPT-4.5 a été testé avec deux invites différentes. Une invite a reçu des informations minimales. Mais une seconde, appelée Persona, a reçu beaucoup de détails supplémentaires dans l’invite, y compris « des instructions supplémentaires sur le type de personnage à adopter pour répondre à l’interrogateur: en particulier un jeune introverti, bien informé sur la culture Internet et utilise l’argot », écrivent les auteurs.

Les résultats

Trois autres programmes d’IA ont été testés: le modèle précédent d’OpenAI, GPT-4O; LLAMA 3.1 405B de Meta Platforms; et un programme de bot de chat très ancien des années 1960, appelé Eliza. Eliza a été incluse parce que, en tant que programme plus primitif, il pouvait agir comme une vérification si les modèles de grande langue ont trompé un humain simplement par une chance aléatoire ou parce qu’ils étaient en fait de meilleurs programmes.

GPT-4.5, rapport Jones et Bergen, avait un « taux de victoire » de 73%, ce qui signifie que cela a trompé le juge humain pour le déclarer humain 73% du temps. En revanche, la version de GPT-4.5 avec le invite minimaliste Et les trois autres programmes d’IA ont également été nulle part, avec des scores allant de 21% à 56%, même lorsque les autres modèles linguistiques ont reçu une invite de personnalité tout aussi riche.

Aussi: Chatgpt Plus ou Pro vaut-il la peine? Voici comment ils se comparent à la version gratuite

De plus, GPT-4.5 était bien au-dessus d’un test de GPT-4 l’année dernière par Jones et Bergen. Il avait un taux de victoire de seulement 54%, juste au-dessus de la chance aléatoire.

Jones et Bergen concluent que « les interrogateurs n’étaient pas seulement incapables d’identifier le vrai témoin humain, mais étaient en fait plus susceptibles de croire que ce modèle était humain que les autres participants humains ».

Le test est-il réellement une mesure de l’intelligence?

Ainsi, vous pourriez vous demander ce que cela signifie que les humains font un mauvais travail de dire à un ordinateur et à une personne en fonction des messages de chat.

La « question la plus controversée » sur le problème de Turing au cours des décennies est de savoir s’il est réellement mesurant l’intelligence, reconnaissent Jones et Bergen.

Une façon de l’examiner est que les machines sont devenues si bonnes qu’elles peuvent « adapter leur comportement à différents scénarios qui les rendent si flexibles: et apparemment si capables de passer comme humains », observent-ils. L’invite de personnage, créée par les humains, est quelque chose à laquelle GPT-4.5 s’est « adapté » lui-même pour gagner.

Encore une fois, c’est une véritable percée technique dans les capacités du modèle d’IA.

Cependant, une grande plainte auprès du test est que les humains pourraient simplement être mauvais à reconnaître l’intelligence. Les auteurs concluent que leur expérience en est une preuve, au moins partiellement.

Ils notent que 23% du temps, le programme Eliza plus âgé a trompé les juges humains. En ce qui concerne, ce n’était pas parce que c’était en quelque sorte évidemment plus intelligent. « De nombreux participants ont sélectionné Eliza parce qu’il ne répondait pas à leurs attentes Système d’IA (Par exemple, «ils étaient sarcastiques» ou «Je ne pense pas que l’IA serait si impoli».), « Ils écrivent.

Ces suppositions, ils écrivent, « suggèrent que les décisions des interrogateurs intègrent des hypothèses complexes sur la façon dont les humains et les systèmes d’IA pourraient être susceptibles de se comporter dans ces contextes, au-delà de la simple sélection de l’agent le plus intelligent. »

En fait, les juges humains n’ont pas beaucoup posé de questions sur les connaissances dans leurs défis, même si Turing pensait que ce serait le critère principal. « (O) NE des raisons les plus prédictives de verdicts précis » par le juge humain, ils écrivent « , était qu’un témoin était humain parce qu’ils manquaient de connaissances ».

Sociabilité, pas d’intelligence

Tout cela signifie que les humains reprenaient des choses comme la sociabilité plutôt que l’intelligence, conduisant Jones et Bergen à conclure que « fondamentalement, le test Turing n’est pas un test direct de l’intelligence, mais un test de l’élimination humaine ».

Pour Turing, l’intelligence a peut-être semblé être la plus grande obstacle à l’apparition de l’homme, et donc à passer le test de Turing. Mais à mesure que les machines deviennent plus similaires à nous, d’autres contrastes sont tombés en relief, au point où l’intelligence seule n’est pas suffisante pour paraître de manière convaincante humaine.

Les auteurs qui ne sont pas dit par les auteurs sont devenus si utilisés pour taper dans un ordinateur – à une personne ou à une machine – que le test n’est plus un nouveau test d’interaction humaine-ordinateur. C’est un test des habitudes humaines en ligne.

Une implication est que le test doit être élargi. Les auteurs écrivent que « l’intelligence est complexe et multiforme » et « Aucun test d’intelligence ne pourrait être décisif ».

Aussi: Gemini Pro 2.5 est un assistant de codage incroyablement capable – et une grande menace pour Chatgpt

En fait, ils suggèrent que le test pourrait sortir très différent avec différents conceptions. Les experts de l’IA, notent-ils, pourraient être testés en tant que cohorte de juge. Ils pourraient juger différemment des profanes parce qu’ils ont des attentes différentes d’une machine.

Si une incitation financière était ajoutée pour augmenter les enjeux, les juges humains pourraient examiner de plus en plus près et de manière plus réfléchie. Ce sont des indications que l’attitude et les attentes jouent un rôle.

« Dans la mesure où le test de Turing fait l’indexation, il devrait être pris en compte entre autres types de preuves », concluent-ils.

Cette suggestion semble carré avec Une tendance croissante dans le domaine de la recherche sur l’IA pour impliquer les humains «dans la boucle», l’évaluation et l’évaluation de ce que font les machines.

Le jugement humain est-il suffisant?

Laissée ouverte est la question de savoir si le jugement humain sera finalement suffisant. Dans le film Blade Runner, les robots « réplicants » parmi eux sont devenus si bons que les humains comptent sur une machine, « Voight-Kampff », pour détecter qui est humain et qui est le robot.

Au fur et à mesure que la quête atteint AGI, et les humains réalisent à quel point il est difficile de dire ce qu’est AGI ou comment ils le reconnaîtraient s’ils trébuchaient dessus, peut-être que les humains devront compter sur des machines pour évaluer l’intelligence des machines.

Aussi: 10 raisons clés, AI est devenu courant du jour au courant – et ce qui se passe ensuite

Ou, à tout le moins, ils devront peut-être demander aux machines quelles machines « pensent » des invites à l’écriture des humains pour essayer de rendre une machine à tromper d’autres humains.

Obtenez les meilleures histoires du matin dans votre boîte de réception chaque jour avec notre Newsletter Tech Today.