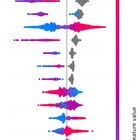

(P) Pourquoi les entrées NAN augmentent-elles la sortie du modèle? Ce tracé de forme est-il préoccupant?

|

Je m’entraîne LightGBM pour la classification binaire et le tracé de résumé de la forme (pour les importations de fonctionnalités) ressemble à ceci. Je suis sûr que mes entrées NAN ne sont pas biaisées, c’est-à-dire qu’il ne devrait pas y avoir de manque de manque informatif. Les entrées NAN sont aléatoires. Alors, pourquoi ont-ils une tendance pour affeter positivement les probabilités de prédiction? Quelqu’un a-t-il déjà rencontré quelque chose comme ça? J’ai 560 fonctionnalités et 18 000 échantillons. Je reçois 0,993 ASC et 0,965 précision. Les performances chutent considérablement lorsque je supprime ces fonctionnalités supérieures avec trop d’entrées NAN (AUC chute à 0,96). soumis par / u / eduardorsstonn |